机器之心分析师网络

作者:Jiying

编辑:H4O

本文结合三篇论文具体讨论计算机视觉领域中的物理攻击及检测方法 。对抗性攻击的概念首先由 Goodfellow 等人提出 [6] , 近年来 , 这一问题引起了越来越多研究人员的关注 , 对抗性攻击的方法也逐渐从算法领域进入到物理世界 , 出现了物理对抗性攻击 。 文献[1] 中首次提出了利用掩模方法将对抗性扰动集中到一个小区域 , 并对带有涂鸦的真实交通标志实施物理攻击 。 与基于噪声的对抗性攻击相比 , 物理攻击降低了攻击难度 , 进一步损害了深度学习技术的实用性和可靠性 。

我们都知道 , 深度学习系统在计算机视觉、语音等多媒体任务上都取得了非常好的效果 , 在一些应用场景中甚至获得了可以与人类相媲美的性能 。 基于这些成功的研究基础 , 越来越多的深度学习系统被应用于汽车、无人机和机器人等物理系统的控制 。 但是 , 随着物理攻击方法的出现 , 这些对视觉、语音等多媒体信息输入进行的篡改会导致系统出现错误行为 , 进而造成严重的后果 。 本文重点关注的就是针对多媒体领域的深度学习系统的物理攻击问题 。

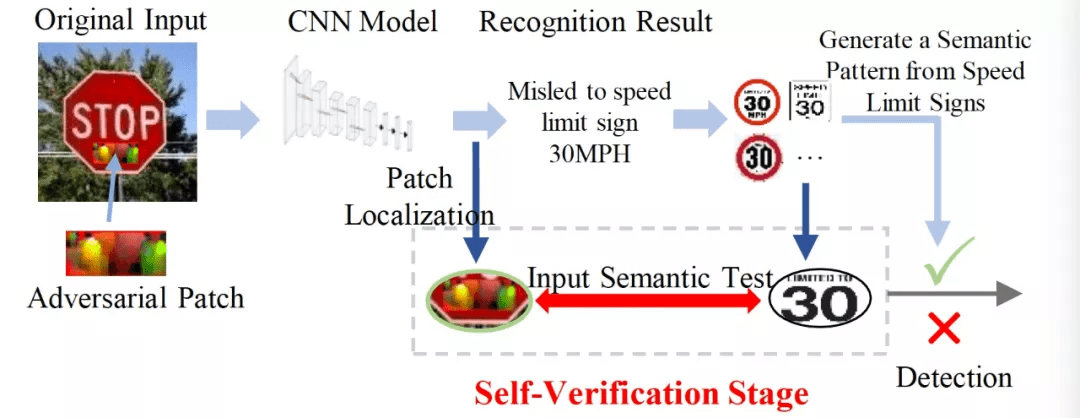

以 [1] 中给出的针对视觉领域的攻击为例 , 通过向输入数据注入特定的扰动 , 对抗性攻击可以误导深度学习系统的识别结果 。 通过物理攻击性方法 , 对抗性扰动可以集中到一个小区域并附着在真实物体上 , 这很容易威胁到物理世界中的深度学习识别系统 。 图 1 给出一个应对物理攻击的实际案例 。 图 1 中左图显示了一个关于交通标志检测的物理对抗样本 。 当在原始停车标志上附加一个对抗补丁时 , 交通标志检测系统将被误导输出限速标志的错误识别结果 。 图 1 右图展示了交通标志对抗性攻击的自我验证过程 。 对于每张输入图像 , 经过一次 CNN 推理后 , 验证阶段将定位重要的激活源(绿圈) , 并根据预测结果计算出输入语义与预期语义模式的不一致性(右圈) 。 一旦不一致性超过预定的阈值 , CNN 将进行数据恢复过程以恢复输入图像 。 关于这一过程 , 我们会在后面详细解释 。

文章图片

图 1. 交通标志的物理对抗性攻击[2]

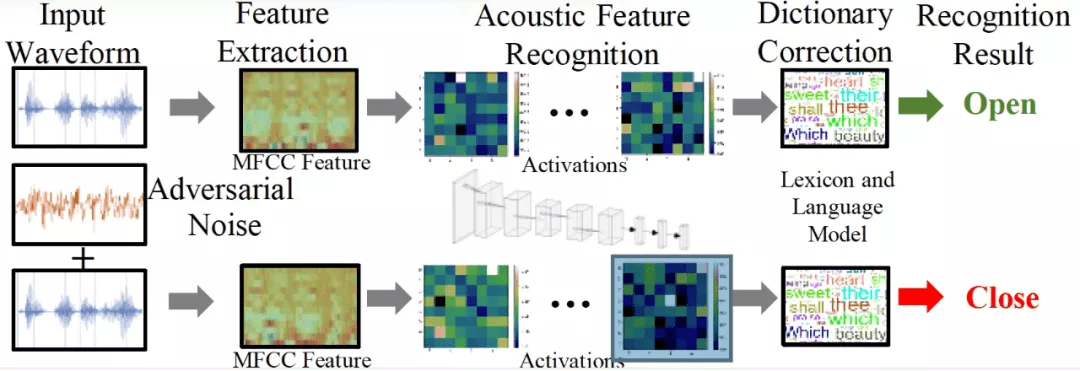

图 2 给出一个典型的音频识别过程和相应的物理对抗性攻击 。 首先 , 提取音频波形的梅尔倒谱系数 MeI-Freguency CeptraI Coefficients (MFCC) 特征 。 然后利用 CNN 来实现声学特征识别 , 从而获得候选音素 。 最后 , 应用词库和语言模型得到识别结果 "open" 。 将对抗性噪声注入到原始输入波形中时 , 最终的识别结果会被误导为 "close" 。

文章图片

图 2. 音频识别和物理对抗性攻击过程

我们在这篇文章中结合三篇最新的论文具体讨论计算机视觉领域中的物理攻击及检测方法 , 包括视觉领域和音频领域 。 首先 , 我们介绍 Kevin Eykholt 等在 CVPR 2018 上发表的关于生成鲁棒物理攻击的工作 , 其主要目的是生成对观察摄像机的距离和角度的巨大变化具有很强的适应性的物理扰动攻击 。 然后 , 第二篇论文提出了一个针对图像和音频识别应用的物理对抗性攻击的 CNN 防御方法 。 最后 , 第三篇文章聚焦于图像的局部物理攻击问题 , 即将对手区域限制在图像的一小部分 , 例如 “对手补丁” 攻击:

- Robust Physical-World Attacks on Deep Learning Visual Classification , CVPR 2018

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。