对于 DeepMind 的这一研究 , 网友大都惊呼「不可思议」 。

文章图片

方法

MiniWob++

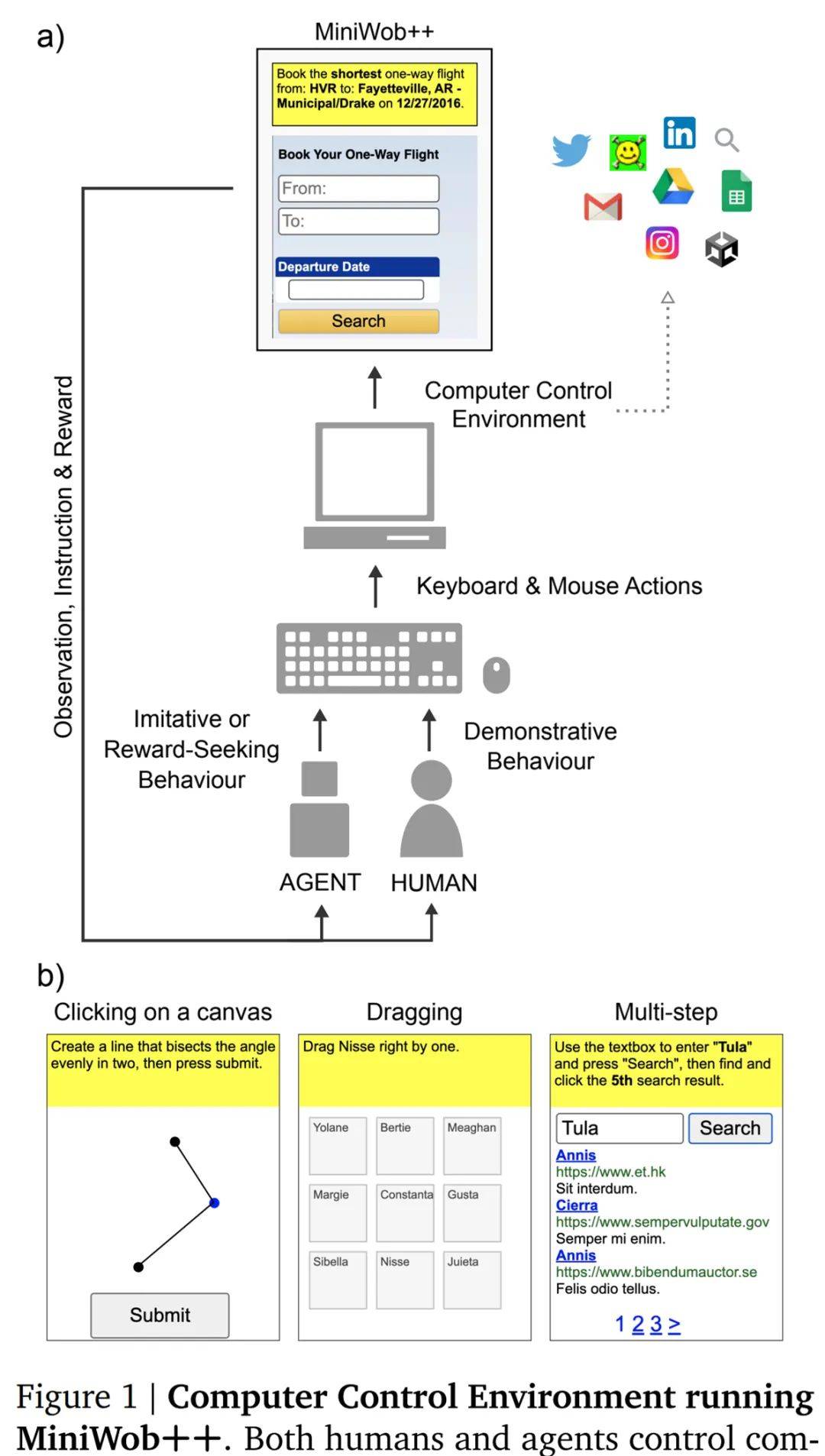

MiniWob++ 是 Liu 等人在 2018 年提出的基于 web 浏览器的套件 , 是早期 MiniWob(Mini World of Bits)任务套件的扩展 , 而 MiniWoB 是一个用于与网站交互的强化学习基准 , 其可以感知小网页(210x160 像素)的原始像素和产生键盘和鼠标动作 。 MiniWob++ 任务范围从简单的按钮点击到复杂的表单填写 , 例如 , 在给出特定指令时预订航班(图 1a) 。

之前关于 MiniWob++ 的研究已经考虑了能够访问 DOM 特定动作的架构 , 从而允许智能体直接与 DOM 元素交互而无需鼠标或键盘导航到它 。 DeepMind 的研究者选择仅使用基于鼠标和键盘的操作 , 并进一步假设该接口将更好地迁移到计算机控制任务 , 而无需与紧凑的 DOM 进行交互 。 最后 , MiniWob++ 任务需要单击或拖动操作 , 而这些操作无法通过基于 DOM 元素的操作来实现(参见图 1b 中的示例) 。

与之前的 MiniWob++ 研究一样 , DeepMind 的智能体可以访问由环境提供的文本字符串字典 , 该字典被输入到给定任务的输入字段中(参见附录图 9 示例) 。

下图为运行 MiniWob++ 的计算机控制环境 。 人类和智能体都使用键盘和鼠标控制计算机 , 人类提供用于行为克隆的示范行为 , 智能体受过训练以模仿这种行为或表现出追求奖励的行为 。 人类和智能体尝试解决 MiniWob++ 任务套件 , 其中包括需要单击、键入、拖动、填写表格等 。

文章图片

环境接口

如果想要智能体像人类一样使用计算机 , 它们需要接口来传输和接收观察结果和动作 。 最初的 MiniWob++ 任务套件提供了一个基于 Selenium 的接口 。 DeepMind 决定实现一个可替代环境堆栈 , 旨在支持智能体可以在 web 浏览器中实现各种任务 。 该接口从安全性、特性和性能方面进行了优化 (图 1a) 。

原来的 MiniWob++ 环境实现通过 Selenium 访问内部浏览器状态并发出控制命令 。 相反 , DeepMind 的智能体直接与 Chrome DevTools 协议 (CDP) 交互 , 以检索浏览器内部信息 。

智能体架构

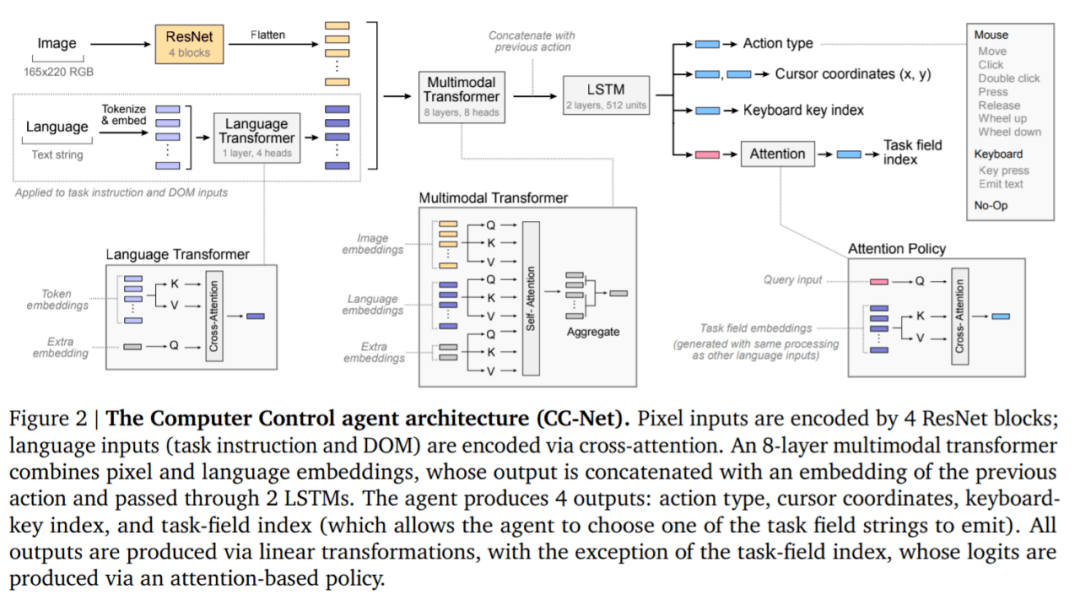

DeepMind 发现没有必要基于专门的 DOM 处理架构 , 相反 , 受最近关于多模态架构的影响 , DeepMind 应用了最小模态特定处理 , 其主要依靠多模态 transformer 来灵活处理相关信息 , 如图 2 所述 。

文章图片

感知 。 智能体接收视觉输入(165x220 RGB 像素)和语言输入(示例输入显示在附录图 9 中) 。 像素输入通过一系列四个 ResNet 块 , 具有 3×3 内核 , strides 为 2、2、2、2 , 以及输出通道(32、128、256、512) 。 这产生了 14×11 的特征向量 , DeepMind 将其展平为 154 个 token 列表 。

三种类型的语言输入任务指令、DOM 和任务字段使用同一个模块处理:每个文本字符串被分成 token , 每个 token 映射被到大小为 64 的嵌入 。

策略:智能体策略由 4 个输出组成:动作类型、光标坐标、键盘键索引和任务字段索引 。 每个输出都由单个离散概率分布建模 , 除光标坐标外 , 光标坐标由两个离散分布建模 。

动作类型是从一组 10 种可能的动作中选择的 , 其中包括一个无操作(表示无动作)、7 个鼠标动作(移动、单击、双击、按下、释放、上滚轮、下滚轮)和两个键盘动作(按键、发出文本) 。

DeepMind 从 77 名人类参与者那里收集了超过 240 万个 104 MiniWob++ 任务演示 , 总计大约 6300 小时 , 并使用模仿学习和强化学习 (RL) 的简单混合来训练智能体 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。