其次 , 将模型编辑好后 , 需要对许多参数进行选择 , 从而找到最佳的量化设定 , 需要考虑以下三个问题:

- 应该使用怎样的观测方式进行范围校正?

- 应该使用哪种量化方案?

- 目标设备支持哪些与量化相关的数据类型(int8、uint8、int16)?

最后 , 从目标设备导出量化模型 。

尽管 PyTorch 和 TensorFlow 在简化量化方面取得了很大的进展 , 但是基于 Transformer 的模型十分复杂 , 难以在不付出大量努力的情况下使用现成的工具让模型工作起来 。

英特尔的量化神器:Neural Compressor

文章图片

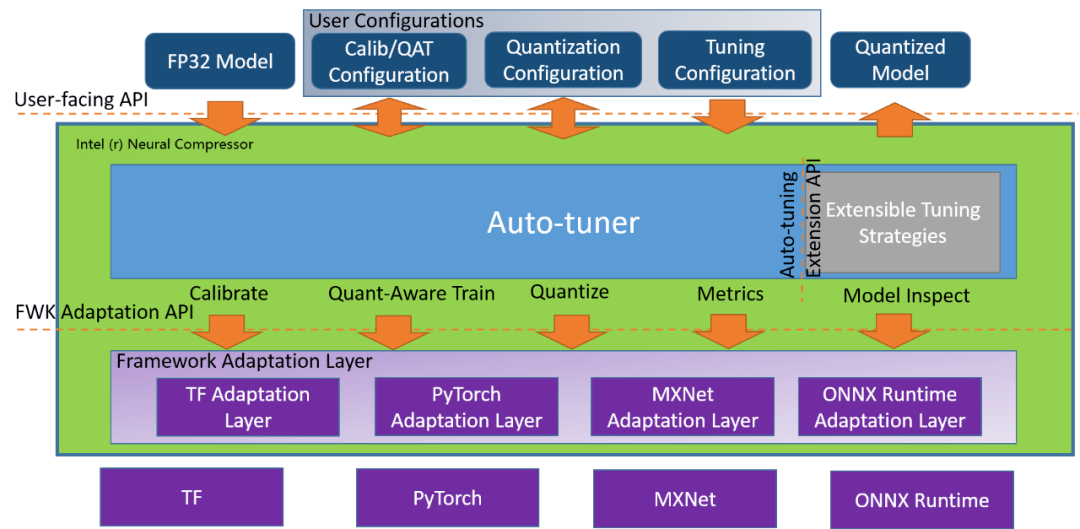

Neural Compressor 架构示意图 。 地址:https://github.com/intel/neural-compressor

英特尔开源的 Python 程序库 Neural Compressor(曾用名「低精度优化工具」——LPOT)用于帮助用户部署低精度的推理解决方案 , 它通过用于深度学习模型的低精度方法实现最优的生产目标 , 例如:推理性能和内存使用 。

Neural Compressor 支持训练后量化、量化的训练以及动态量化 。 为了指定量子化方法、目标和性能评测标准 , 用户需要提供指定调优参数的配置 yaml 文件 。 配置文件既可以托管在 Hugging Face 的 Model Hub 上 , 也可以通过本地文件夹路径给出 。

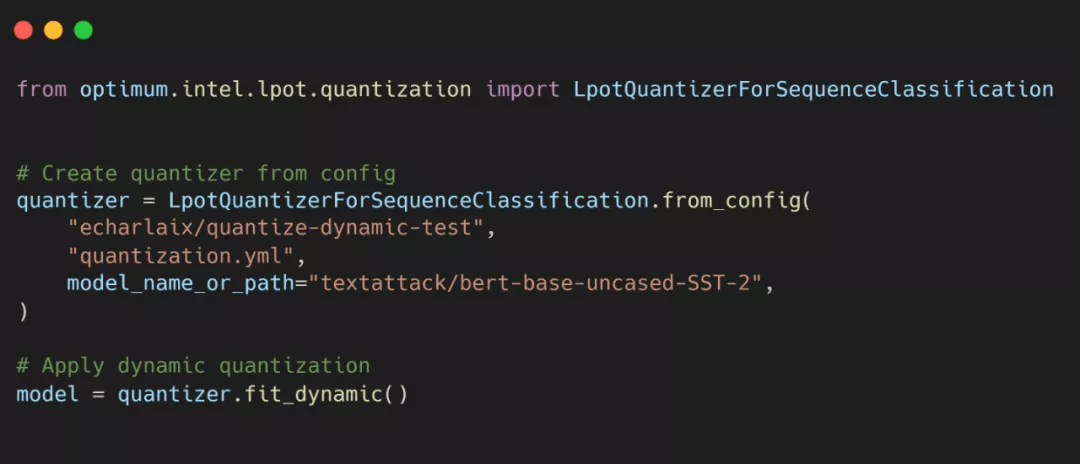

使用 Optimum 在英特尔至强 CPU 上轻松实现 Transformer 量化

实现代码如下:

文章图片

踏上 ML 生产性能下放的大众化之路

SOTA 硬件

【大模型高效释放生产性能,HuggingFace开源Transformer扩展优化新库】Optimum 重点关注在专用硬件上实现最优的生产性能 , 其中软件和硬件加速技术可以被用来实现效率最大化 。 Optimum 团队将与硬件合作伙伴协作 , 从而赋能、测试和维护加速技术 , 将其以一种简单易用的方式交互 。 该团队近期将宣布新的硬件合作者 , 与其一同实现高效机器学习 。

SOTA 模型

Optimum 团队将与硬件合作伙伴研究针对特定硬件的优化模型设置和组件 , 成果将在 Hugging Face 模型上向人工智能社区发布 。 该团队希望 Optimum 和针对特定硬件优化的模型可以提升生产流程中的效率 , 它们在机器学习消耗的总能量中占很大的比例 。 最重要的是 , 该团队希望 Optimum 促进普通人对大规模 Transformer 的应用 。

原文链接:https://huggingface.co/blog/hardware-partners-program?&continueFlag=41b75b6447bf1c6783988438d5b28c0d

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。