2、发布飞桨开源框架V2.2 , 包括4方面特性

百度深度学习技术平台部高级总监马艳军分享了飞桨产业级深度学习开源开发平台最新发布 。

马艳军说 , 今年上半年开始 , 飞桨开源框架进入2.0时代 , 今天发布的是2.2版本 , 分别涉及到开发、训练、文本领域的全流程以及多层次、低成本硬件适配方案来赋能硬件生态圈等四个方面的最新特性 。

飞桨新增100多个API , 覆盖了更多的计算场景 , 并对全部API进行了高性能的实现 , 飞桨还保证向前兼容 。

训练方面 , 飞桨新推出的是端到端自适应大规模分布式训练 , 动态感应硬件资源的变化 。

升级后的飞桨开源框架以四大特性加速文本任务全流程 , 分别是端到端文本处理、预训练任务加速、生成任务解码加速和训推一体部署体验 , 例如在产业级部署时 , 代码可以减少94% , 减少代码文本量 。

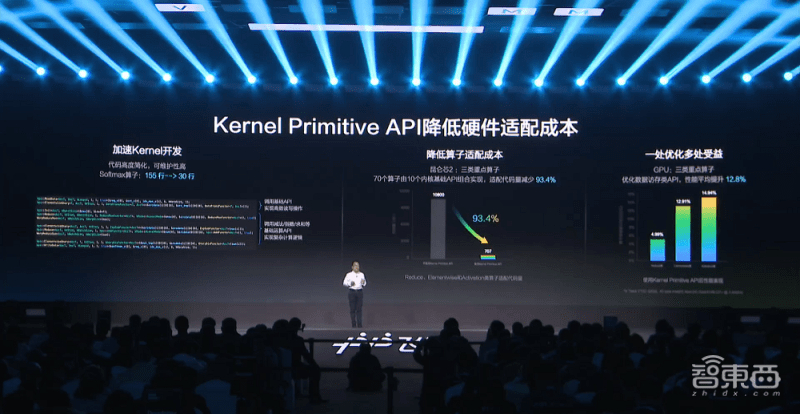

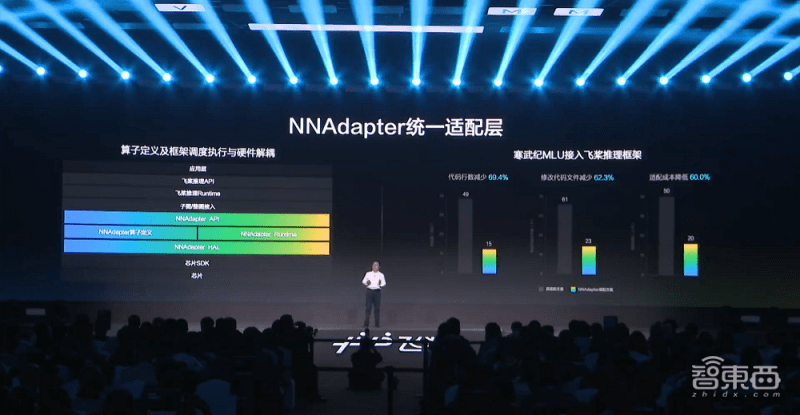

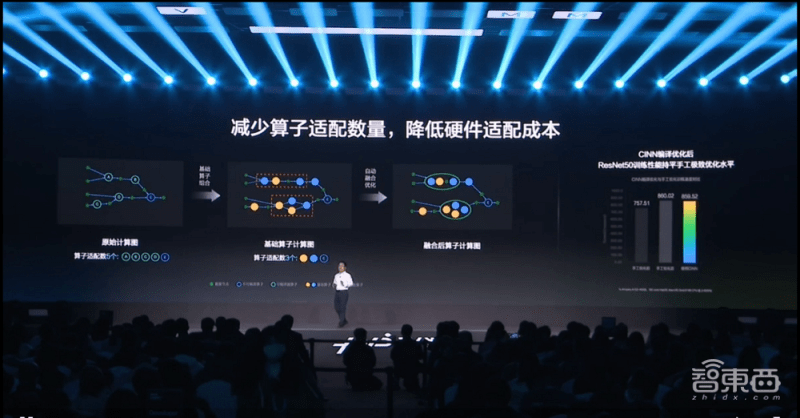

马艳军还介绍了飞桨新推出的硬件适配统一方案 , 3个技术方案分3类 , 第一类是算子的开发与映射 , 第二类是图(Graph)的接入 , 第三类是编译器后端的接入 , 具体包括Kernel Primitive API、NNAdapter和神经网络编译器CINN 。

Kernel Primitive API方案 , 将底层Kernel开发工作进行封装和抽象 , 开发者编写更复杂Kernel时 , 可利用底层封装的Kernel , 使计算更简洁 , 加速Kernel开发 , 降低算子适配成本 , 代码得到高度简化 , 一处优化可多处受益 。

文章图片

NNAdapter统计适配层方案 , 减少算子定义及框架调度的程序 , 在底层封装 , 硬件不需要知道框架背后调动的一系列逻辑 , 也不需要做侵入式修改 , 代码也更容易维护 。

文章图片

飞桨还预发布了第三种硬件适配统一方案:神经网络编译器CINN 。

文章图片

神经网络编译器CINN方案面向飞桨的框架进行深度的优化 , 同时支持训练和推理两方面 , 基于基础算子 , 组合实现更复杂的算子 , 减少算子适配数量 , 降低硬件适配成本 , 训练性能持平人工极致优化 。

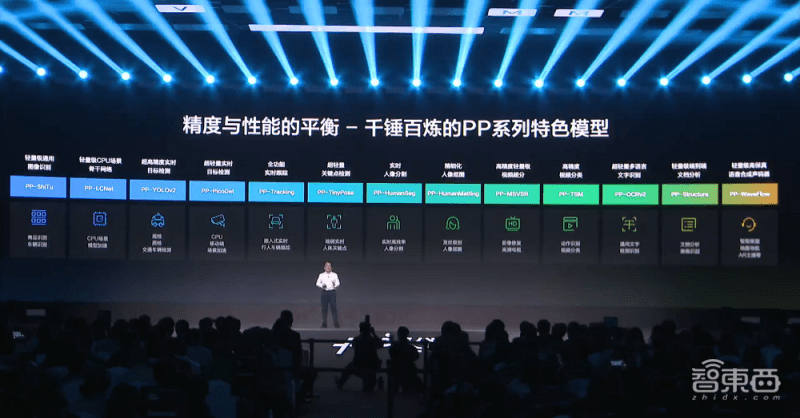

飞桨产业级模型库也进行了升级 , 不但关注精度还关注速度 , 并且正式推出产业级PP模型 , 发布13个PP系列的特色模型 。

文章图片

3、EasyDL推出桌面版 , 一键快速安装

百度AI产品研发部总监忻舟谈道 , 随着模型参数增长、芯片种类增多、应用场景更多样 , 模型部署复杂度也不断增长 。

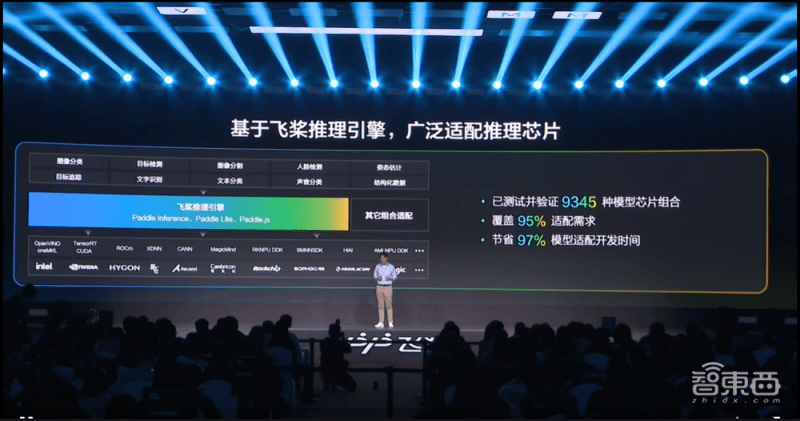

他介绍了飞桨企业版模型部署升级情况 , 基于飞桨模型框架中的推理和部署的工具链 , 结合平台的优势 , 飞桨为企业打造自动高效的企业级部署功能 , 拥有显著提升推理性能、广泛适配推理芯片和大幅提高部署效率三大特性 。

基于PaddleSlim并预置多种前沿压缩算法 , 飞桨提出根据模型框架和硬件和压缩级别 , 自动选择最优的压缩路径 , 对于常见的模型和硬件来说 , 平均精度损失控制在1%以内的情况下 , 推理性能提升3-5倍 。

文章图片

飞桨基于自身的推理引擎 , 用组合适配的方式 , 测试并验证了9345种模型芯片组合 , 覆盖95%的适配需求 , 平均节省97%的模型适配开发时间 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。