反过来说 , 人工智能如果不辅以数据治理则可产生严重的马太效应从而加深社会分化 。

《社会心态蓝皮书:中国社会心态研究报告(2019)》显示 , 对第三方保存个人信息「非常有信心」的民众不足一成 。 「商业机构」位列最担心个人信息和数据被收集、保存和使用第三方的第二位 。

这一结果与 2019 年普华永道的一份调查结果吻合 。 中国企业数字化进程中面临的最严峻风险是数据治理或隐私问题 , 比例达到 28% , 高于全球平均水平(11%) 。

吊诡的是 , 对于当下陆续奔赴二级市场的中国 AI 公司来说 , 主流业务的规模商用根本离不开客户信任 。 当 AI 从安装期(installation )步入真正部署期(deploy)后 , 算法本身不是壁垒 , 未来更多的(壁垒)是如何与行业结合 , 对技术的信任问题成为其中重要一环 。

目前 , 各国和各地区的法律正在扎紧篱笆 , 对企业的启示相似——数据安全风险不是闹着玩的 , 企业都要在数据安全上做足投入 , 依法达成数据安全合规 。

过去几个月 , 中国立法机构敲定了至少四部新的法律法规 , 随后陆续生效 , 中国互联网版图可能被重塑 。

二、约束求解

作为《数据安全法》和《个人信息保护法》颁布后首家向港交所递交招股说明书的企业 , 商汤科技招股说明书中的「业务」章节 , 总计有 22 处提到「数据安全」 , 并对自身伦理治理、管控做了详细披露 。

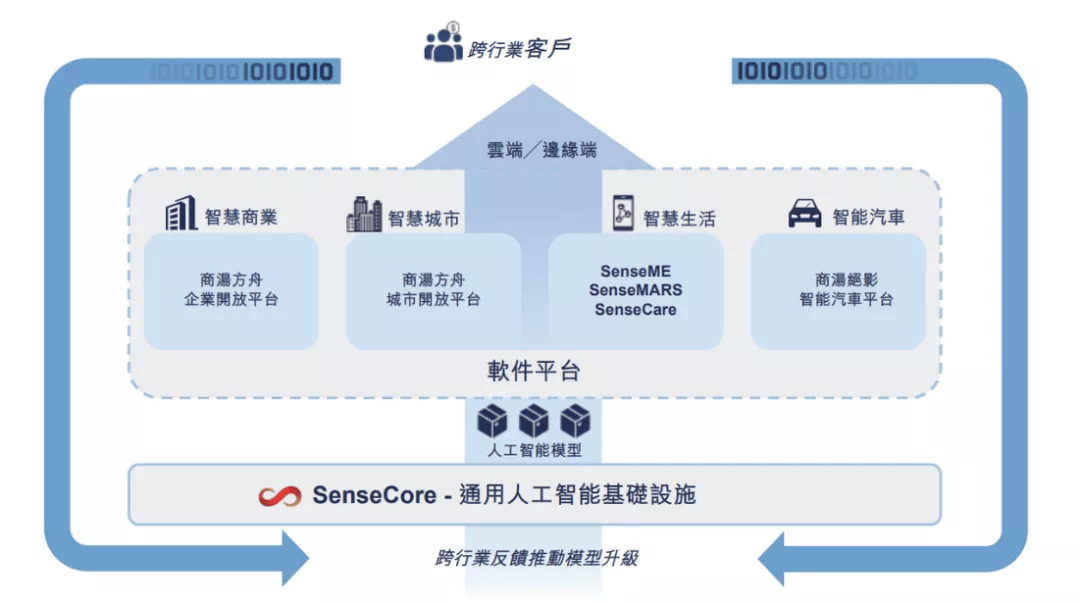

文章图片

商汤通过软件平台快速部署及商业化人工智能模型的流程 。

徐立打过一个比方 , 如果优化函数是 AI 推动社会的进步 , 纵观全世界 , 大概有三个约束条件需要满足:以人为本、可持续发展以及技术可控 。

以人为本 , 强调的是人权、隐私保护及无偏见地应用技术;技术可控 , 包含透明计算、可解释性、技术安全的边界等;可持续发展 , 追求公共善与长远发展 。

「未来的人工智能伦理治理其实就是在这三大支柱当中求得平衡」 , 徐立坚信 。

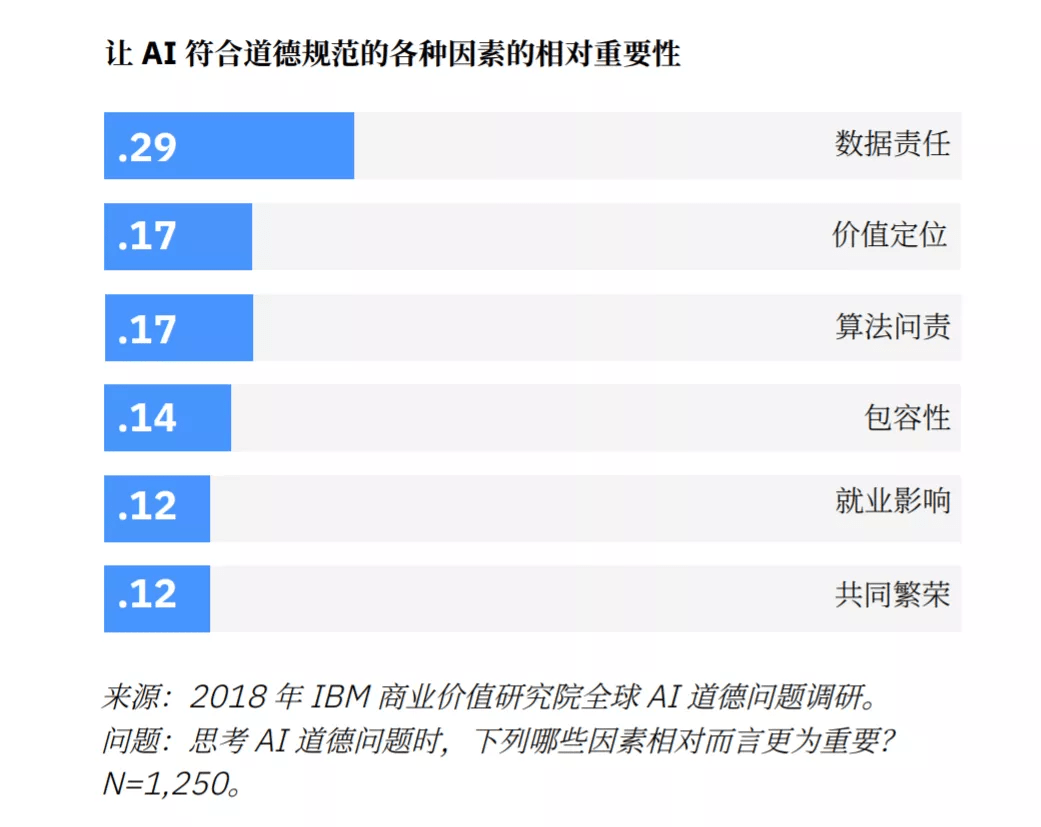

而其中 , 首当其冲的是数据与隐私保护 。 IBM 商业价值研究院曾在 2018 年与牛津经济研究院合作调查 , 发现 , 近 2/3 高管将「AI 道德」视为重要业务主题 。 位居道德风险首位的正是「数据责任」 , 包括数据所有权、存储、使用和共享 。

文章图片

「数据责任」得分差不多是排名第二 (「价值定位」)的两倍 。

在一些法律人士看来 , AI 行业在模型训练、落地应用中涉及大量数据 , 同时也要为其保障用户数据安全的能力提出更高要求 , 在数据的采集、分析、利用等各个方面均应设置严格的条件和专业的技术防火墙 。

商汤招股书显示 , 公司受客户委托就若干业务合作处理其数据 。 公司要求客户确认 , 彼等乃从合法来源获得该等数据并已取得该等数据的使用权 , 且彼等终端用户已同意协议中指定的使用目的 。 仅使用数据作客户明确授权用途 , 如身份核实、记录保存和统计数据 。

除履行或敦促敦促客户履行「通知 - 同意」基本义务 , AI 公司还应积极采用技术手段解决数据安全问题 。 《个人信息保护法》第五十一条明确规定 , 采取相应的加密、去标识化等安全技术措施;…… 人工智能企业在收集到数据后应该按照此规定对信息采取去标识化等措施 , 充分保障信息和数据的安全 。

隐私增强计算可以将数据做一些模糊化处理或者加密处理 , 然后再做计算 , 它保护到是数据本身 , 有利于突破数据保护与产业应用的难题 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。