文章图片

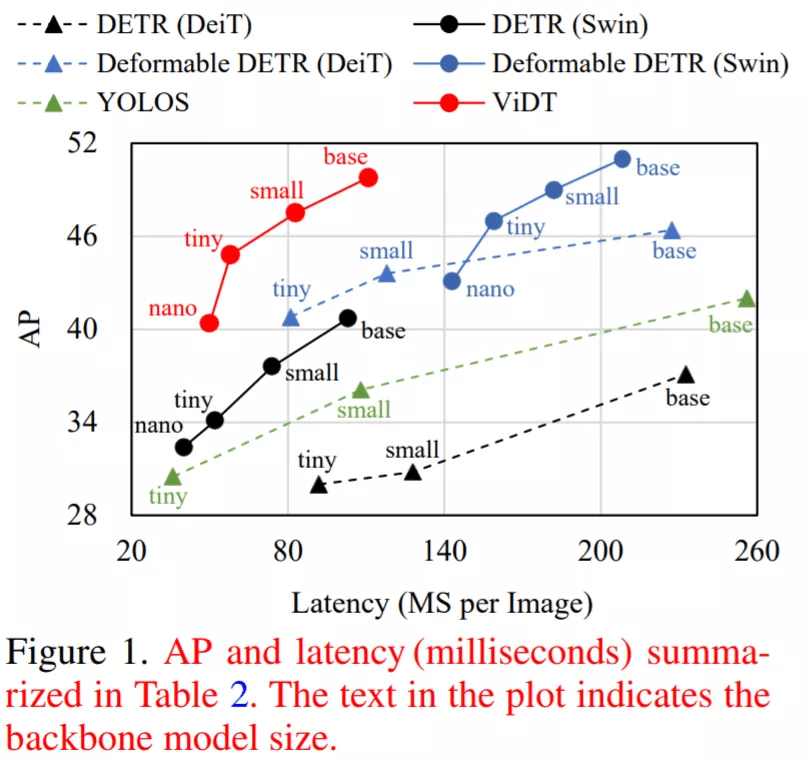

中采样的一小组关键内容:

文章图片

用于目标检测的 token 匹配知识蒸馏

虽然大型模型具有实现高性能的高容量 , 但在实际使用中它的计算成本可能很高 。 因此 , 该研究还提出了一种简单的知识蒸馏方法 , 可以通过 token 匹配从大型 ViDT 模型中迁移知识 。

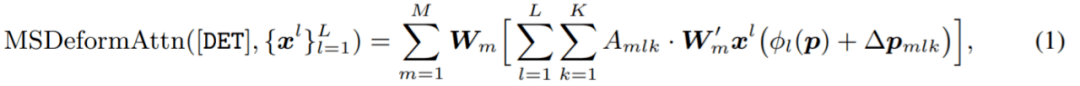

匹配每一层的所有 token 在训练中非常低效 , 因此 , 该研究只匹配对预测贡献最大的 token 。 两组 token 直接相关:(1)P:用作多尺度特征图的 [PATCH] token 集合 , 由 body 中的每个阶段生成 , (2)D:[DET ] token 的集合 , 它们是从 neck 的每个解码层生成的 。 因此 , 基于 token 匹配的蒸馏损失公式为:

文章图片

评估

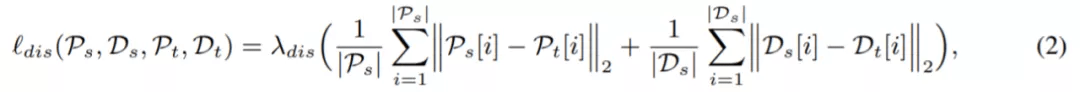

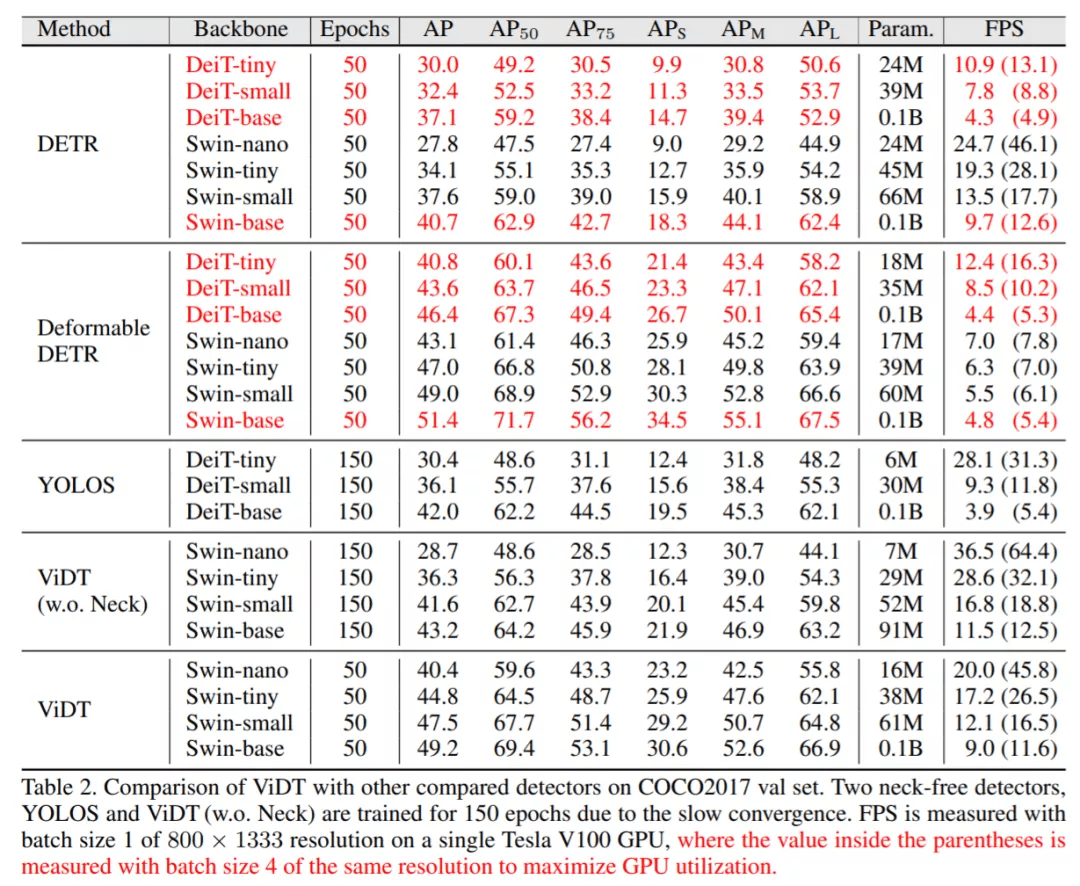

表 2 将 ViDT 与 DETR (ViT) 和 YOLOS 的 AP、FPS 等进行了比较 , 其中 DETR (ViT) 有两个变体:DETR 和 Deformable DETR 。

实验结果表明:ViDT 实现了 AP 和 FPS 之间的最佳权衡 。 凭借其高可扩展性 , 其性能优于 1 亿个参数的 Swin-base , 在相似的 AP 的下 , FPS 比 Deformable DETR 快 2 倍 。 此外 , ViDT 参数为 16M , 得到 40.4AP , 比 DETR (swin-nano) 和 DETR (swin-tiny) 高分别高 6.3AP、12.6AP 。

文章图片

文章图片

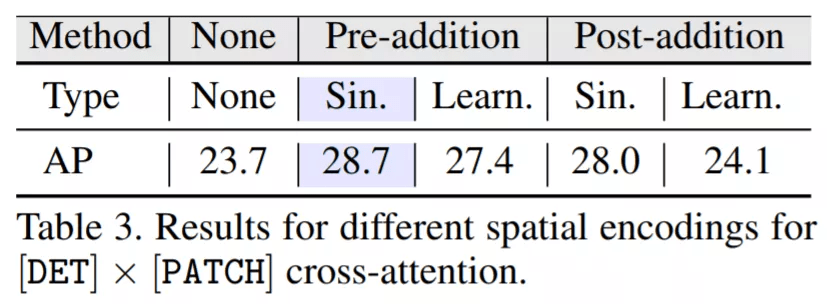

表 3 对比了不同空间位置编码与 ViDT(w.o. Neck)的结果 。 结果表明:pre-addition 比 post-addition 带来的性能提升更高 , 即 sinusoidal encoding 优于 learnable 编码;因此 , 正弦空间编码的 2D 归纳偏置在目标检测中更有帮助 。 特别是 , 与不使用任何编码相比 , 使用正弦编码的预加法(pre-addition)将 AP 增加了 5.0 。

文章图片

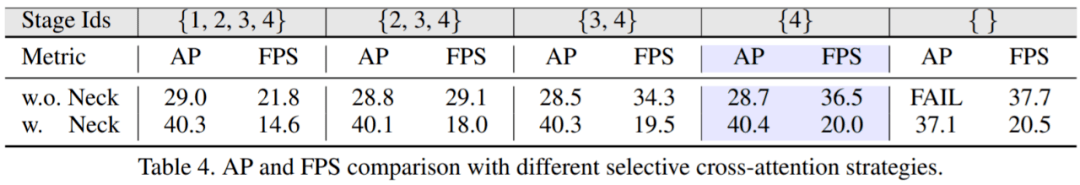

表 4 总结了使用不同选择策略进行交叉注意力(cross-attention)时的 AP 和 FPS , 其中 Swin Transformer 总共包含四个阶段 。 有趣的是 , 只要在最后阶段激活交叉注意力 , 所有策略都表现出相似的 AP 。 由于在各个阶段中以自下而上的方式提取特征 , 因此在低级别阶段很难直接获得有关目标对象的有用信息 。 因此 , 研究者想要获得较高的 AP 和 FPS , 只使用最后阶段是最好的设计选择 , 因为 [PATCH] token 的数量最少 。

文章图片

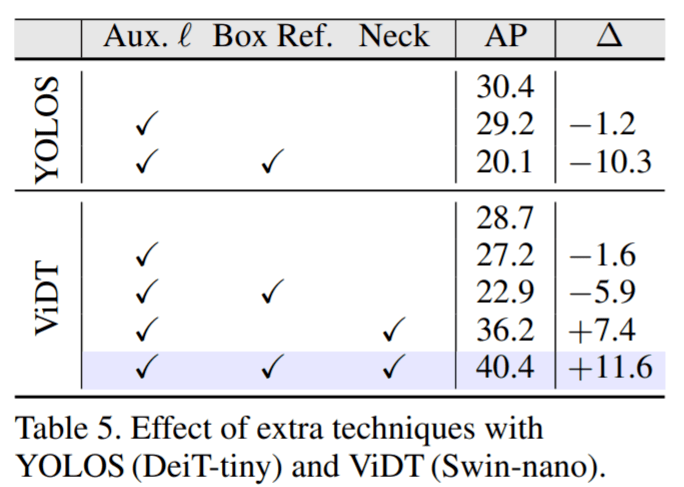

为了彻底验证辅助解码损失(auxiliary decoding loss)和迭代框细化(iterative box refinement)的有效性 , 该研究甚至对 YOLOS 等 neck-free 检测器进行了扩展 。 表 5 显示了两种 neck-free 检测器 YOLOS 和 ViDT (w.o. Neck) 性能 。 实验结果证明在 ViDT 中使用 Neck 解码器来提高目标检测性能是合理的 。

文章图片

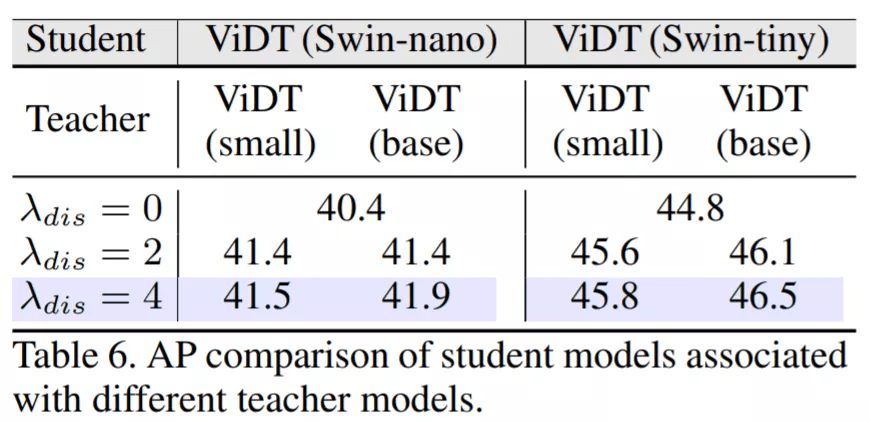

下图表明:教师模型的规模越大 , 学生模型的收益越大 。 从系数来看 , 系数值越大 , 性能越好 。 模型蒸馏将 AP 提高了 1.0-1.7 , 而不会影响学生模型的推理速度 。

文章图片

研究者将所有提议的组件结合起来 , 以实现目标检测的高精度和速度 。 如表 8 所示 , 有四个组件:(1) RAM 将 Swin Transformer 扩展为独立的目标检测器 , (2) neck 解码器利用多尺度特征和两种辅助技术 , (3) 从大模型中获益知识蒸馏 , (4) 解码层 drop 进一步加快推理速度 。 结果表明:当使用 Swin-nano 作为其主干时 , 它仅使用 13M 参数就达到了 41.7AP 和合理的 FPS 。 此外 , 当使用 Swin-tiny 时 , 它仅损失了 2.7 FPS 而表现出 46.4AP 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。