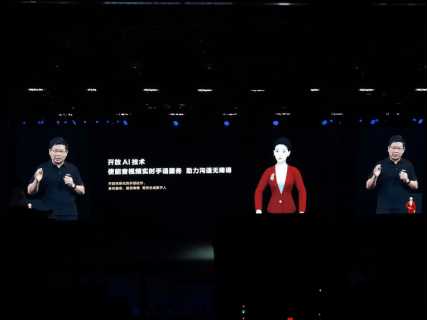

在2021年10月22日华为开发者大会的直播中 , 有一位红衣女孩一直在直播屏幕左下角 , 兢兢业业地为整场大会做实时手语翻译 。 这位红衣女孩是HMS Core团队的手语数字人 , 她基于团队最新研发的手语服务 , 可以完成实时手语翻译 , 生成包括身体姿态、手部动作以及面部表情的手语 。 有了她 , 听障手语使用者也可以“听”懂HDC大会 , 获取到更多感兴趣的资讯 。 这是华为首次采用AI全程手语直播 , 引发了线上线下观众和媒体的关注 。

文章图片

一个美好的愿望

手语项目起源于一款在2018年推出的应用StorySign , 这是一个将欧美流行儿童书籍转化成手语动画 , 帮助有听力障碍的儿童学习阅读的App 。 StorySign的推出为众多听障儿童打开了连接世界的一扇窗 , 也给他们的家庭带去了温暖 。 发布一段时间后 , StorySign逐步上架了71本儿童读物 , 支持了英、法、德等15种语言的手语 , 但同时项目也遇到瓶颈:想要普及手语 , 让更多的人学习更丰富的手语 , 就要有充足的手语动画作为手语学习的资源 。 但如何更快速地生成丰富的手语动画呢?

StorySign集成了HMS Core的OCR(Optical Character Recognition ,光学字符识别)技术 , 这是一种基于深度学习 , 将图片上的文字智能识别成文本的AI技术 。 那么 , 既然AI可以智能识别图片上的文字 ,AI能不能做手语翻译呢?给AI一段话 , 它如果可以自动翻译成手语动画 , 大家就可以跟着AI学习手语了 , 甚至AI也能成为聋人与健听人之间的实时翻译官 , 这样AI造福的不仅仅是儿童的阅读场景 , 更是更广泛的听障群体!

为了让AI手语翻译通过HMS Core能力开放出去 , 让开发者去集成 , 进而服务到全球4.6亿的听障人群 。 首先要面对的难题便是 - AI能不能做手语翻译 , 从文字智能生成手语动画?HMS Core组建了覆盖AI手语翻译所需要的3D数字人建模、自然语言理解、计算机视觉、3D动画、图形渲染、移动端Android开发、云侧服务化等众多关键技术专家团队 , 并邀请到国内权威手语语言学专业教授作为项目顾问 , 携手共同攻关智能实时手语翻译项目 。 算法和数据的双重挑战

手语翻译项目启动后 , 团队通过查阅大量文献和专利 , 快速对行业内相关技术进行了调研 , 一起梳理出了几大难题 。 首先 , 要考虑到手语动作对于精度的高要求 , 1厘米指尖位置的误差就可能表示完全不同的意思 。 其次 , 中文和手语成对的大规模高质量手语语料极难获取 , 无法在短时间内找到这么多专业的手语老师来提供语料 。 第三 , 手语作为独立的语言 , 有其自身的语法及语序 , 中文与手语的语法及语序存在差异 。 例如中文“我没有带身份证” , 对应的手语语序为“身份证/我/带/没有” 。 最后 , 手语不仅包括手部动作 , 还包含身体姿态及面部表情和口动 , 多模态数据的协同生成很重要 。

通过对这些难题的逐一分析与解决方案的讨论 , 手语团队输出了一种基于文本的多模态数字人动作和表情生成方案 。 这个方案由手语转写模块和手语动作表情生成模块组成 , 融合了手语语言学领域知识 , 并且能够有效解决高质量动捕数据较少的问题 。

算法方案确定后 , 手语团队迎来了更大的挑战——数据 。 在人工智能领域 , 有句话是“兵马未动 , 粮草先行” , 对手语翻译项目来说 , “粮草”就是手语数据获取问题 , 包括手语转写数据和3D动作数据 。 如何制定合理的转写方案?什么样的动作捕捉设备采集的数据可以满足手语项目的商用要求?

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。