随着大数据的发展 ,计算机芯片算力的提升 , 人工智能近两年迎来了新一轮的爆发 。而人工智能实现超级算力的核心就是AI芯片 。 AI芯片也被称为人工智能加速器 , 即专门用于处理人工智能应用中的大量计算任务的模块 。

2020年我国人工智能芯片市场规模约为184亿元 。 未来5G商用的普及将继续催生人工智能芯片的应用需求 , 中国人工智能芯片行业将快速发展 , 预计2023年市场规模将突破千亿元 。

那么 , 如何借助AI芯片来实现特定的任务 , 将是所有AI芯片产业人员必备的技能 。

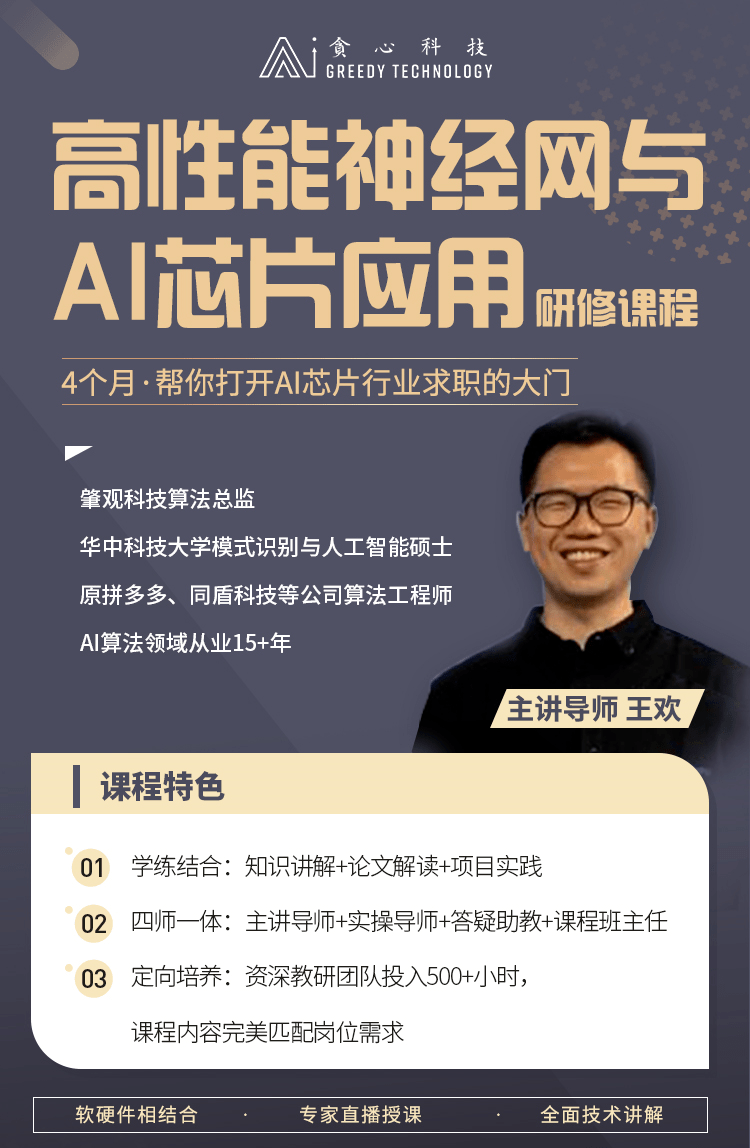

为此 , 贪心学院重磅推出《高性能神经网络与AI芯片应用研修课程》 , 为想进入AI芯片行业的同学们提供一个可以大幅提升自身就业竞争力的选择 。

本课程会讲解AI芯片相关知识、高性能网络设计、通用芯片及专用芯片计算加速方法等专业技能 , 并结合优秀编译器的架构和实现细节的讲解, 为学生构建高性能AI算法的软硬件视角 , 能够解决应用落地时神经网络的优化和部署相关问题 。

文章图片

01

内容亮点

- 全面技术讲解:课程涵盖了轻量化神经网络设计、神经网络部署前的优化方法、神经网络编译器的设计模式和具体实现、神经网络部署到芯片上的计算加速等全面的AI嵌入式芯片设计和应用相关人员就业必备的知识 。

- 软硬件相结合:本课程除了全面讲解高性能神经网络相关的知识技术外 , 还会指导学员在硬件上进行实操 。

- 专家导师授课:课程导师为AI芯片行业专家 , 相关项目经验十分丰富 。

你将收获

- 掌握神经网络高性能实现的算法及工具

- 掌握通用芯片及专用AI芯片架构及网络加速技术

- 掌握通用芯片及专用AI芯片神经网络部署应用的实际案例

- 短期内对一个领域有全面的认识 , 大大节省学习时间

- 认识一群拥有同样兴趣的人、相互交流、相互学习

03

项目介绍

▌项目1

项目名称:模型轻量化

项目内容描述:mobilenet、shufflenet、squeezenet等 , 模型量化、剪枝和蒸馏技术 , 网络的计算量和内存分析的工具 , 主干网络的轻量化 , 检测网络的轻量化 , 分割网络的轻量化 , 不同框架提供的加速方案 。

项目使用的数据集:COCO , ADE20k , ImageNet

项目使用的算法:模型量化 , 模型剪枝和模型蒸馏

项目使用的工具:python , c/c++ , pytorch , tensorflow , distiller , ncnn

项目预期结果:学员掌握轻量化网络设计准则 , 模型轻量化技术 , 能够上手操作一 个网络部署前的优化 。

项目对应第几周的课程:1~4周

▌项目2

项目名称:神经网络编译器

项目内容描述:tvm , ncnn , mnn , tnn 各自的特点 , 对于神经网络的优化方案 , tvm的具体设备的优化方案 , 算子融合 , 路径优化 , 内存优化 , ncnn的网络的表示数据结构 , ncnn的一些优化计算的思路 , 量化方法 , mnn中的数据结构 , 模型转换和量化方法 , tnn和ncnn的区别 , 系统架构 , 量化方法 。

项目使用的算法:离线量化 , 在线感知量化

项目使用的工具:python , c/c++ , tvm , ncnn , tnn , mnn

项目预期结果:学员对于神经网络编译器有全面的了解 , 对于主流神经网络编译器能够实践使用 , 完成模型到芯片所需要格式的转换 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。