所以 , 当未来有感知能力的 AI 系统成为道德关怀体时 , 并不意味着我们对其它人类的福祉不再关心 , 也不意味着我们需要转移现有资源来帮助他们 。

道德行为体

道德行为体因为懂得善恶是非 , 他们倾向以好的方式行事 , 避免以坏的方式行事 。 当做了道德或法律上不允许的事情的时候 , 他们会受到相应的惩罚 。

道德行为体中最弱的部分只需要对积极和消极的激励做出反应 。 这就是说 , 另外的实体 可以惩罚该行为体的不良行为或奖励其良好行为 , 因为这将改善行为体今后的行为 。

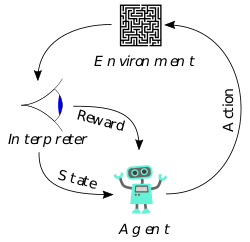

值得注意的是 , Askell 指出: 接收刺激并得到反馈似乎并不要求现象意识 。 当前的 ML 系统在某种意义上已经符合这一规律 , 比如模型需要降低损失函数 , 或者强化学习中更明显的「奖励」和「惩罚」 。

文章图片

图注:强化学习的奖励反馈机制

那么对于更强的道德行为体呢?我们通常认为 , 只有当行为体有能力理解是非对错 , 并没有被糊弄采取其它行为时 , Ta 才能对他们的行为负有道德责任 。 比方说 , 一个人说服他的朋友在森林放火 , 如果这位朋友被抓到 , 不管他怎么辩解自己是受到别人教唆才放火的 , 承担道德责任的都是引发火灾的人(即朋友本人) , 而不是说服他的人 。 但是 , 如果一个人训练他的狗去放火 , 在这种情况下 , 我们会将大部分的道德责任放在这位训练师而不是他的宠物身上 。

为什么我们让人类纵火犯承担道德责任 , 而不是训练有素的狗?首先 , 人类纵火犯有能力考虑他们的选择 , 并选择不听从朋友的劝说 , 而狗则缺乏这种能力来推理他们的选择 。 其次 , 狗从不明白自己的行为是错误的 , 也从不表现出做错事的意图(disposition)——它只是做了它受过训练的事情 。

假设先进的机器学习系统在这种更强的意义上成为道德行为体 , 即它完全有能力理解是非 , 充分考虑可行的选项 , 并按照自己的意愿行事 , 那么这是否意味着:如果机器学习系统做错了事 , 那些创建该系统的人应该被免除道德责任?

对此 , Askell 持反对意见 。 为了更加细致地考虑这一问题 , 她认为可以询问创造者们以下几个问题:

- 创造特定的实体(如AI)预期的影响是什么?

- 创造者为获得有关其影响的证据付出了多少努力?

- 他们对他们创造实体的行为可以在多大程度上进行控制(无论是直接影响其行为还是间接影响其意图)?

- 在他们力所能及的范围内 , 他们为改善实体的行为付出了多少努力?

3

研究 AI 意识的工作有多重要?

目前 AI 领域专门针对意识(甚至其它哲学方面的思考)的研究非常少 , 但也已经有学者在针对该话题进行跨领域的合作研究 。 比如 , GPT-3问世后 , 专注哲学问题探讨的博客 Daily Nous 就专门开辟了一个板块讨论语言哲学在 AI 上的思考 。

但同时 , Askell 强调 , 对 AI 意识的讨论不应仅仅停留在哲学式的抽象思辨上 , 还要致力于发展相关的实用框架 , 比如为机器意识和感知建立一系列高效的评估 。 目前已经有一些方法可以用于检测动物疼痛 , 似乎可以从那里获得一些灵感 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。