扩展 ParNet

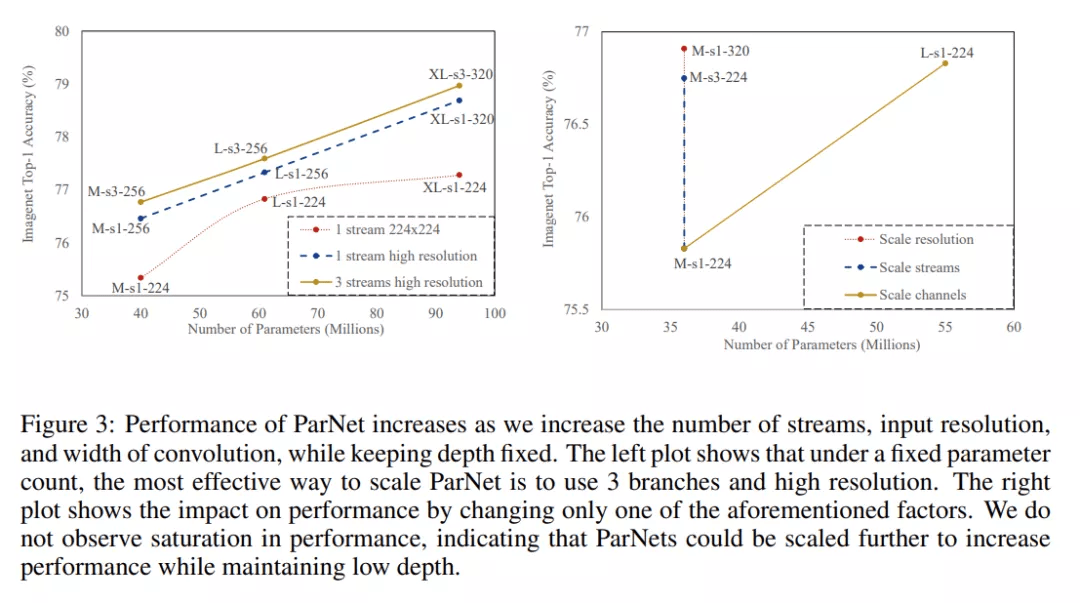

据观察 , 神经网络可以通过扩大网络规模来获得更高的准确度 。 之前的研究 (Tan & Le, 2019) 扩展了宽度、分辨率和深度 。 由于本研究的目标是评估是否可以在深度较低的情况下实现高性能 , 因此研究者将模型的深度保持不变 , 通过增加宽度、分辨率和流数来扩展 ParNet 。

对于 CIFAR10 和 CIFAR100 , 该研究增加了网络的宽度 , 同时将分辨率保持为 32 , 流数保持为 3 。 对于 ImageNet , 该研究在三个不同的维度上进行了实验 , 如下图 3 所示 。

文章图片

并行架构的实际优势

目前 5 纳米光刻工艺已接近 0.5 纳米晶硅尺寸 , 处理器频率进一步提升的空间有限 。 这意味着神经网络的更快推理必须依赖计算的并行化 。 单个单片 GPU 的性能增长也在放缓 , 预计传统光刻可实现的最大芯片尺寸将达到 800 平方毫米(Arunkumar 等 , 2017) 。 总体而言 , 未来在处理器频率、芯片尺寸以及每个处理器的晶体管数等方面都将维持一个平稳状态 。

为了解决这个问题 , 最近的一些工作提出了多芯片模块 GPU (MCM-GPU) , 比最大的可实现单片 GPU 更快 。 用中型芯片取代大型芯片有望降低硅成本 。 这样的芯片设计有利于具有并行分支的分区算法 , 算法之间交换有限的数据并且尽可能地分别独立执行 。 基于这些因素 , 非深度并行结构将有利于实现快速推理 , 尤其是对于未来的硬件 。

实验结果

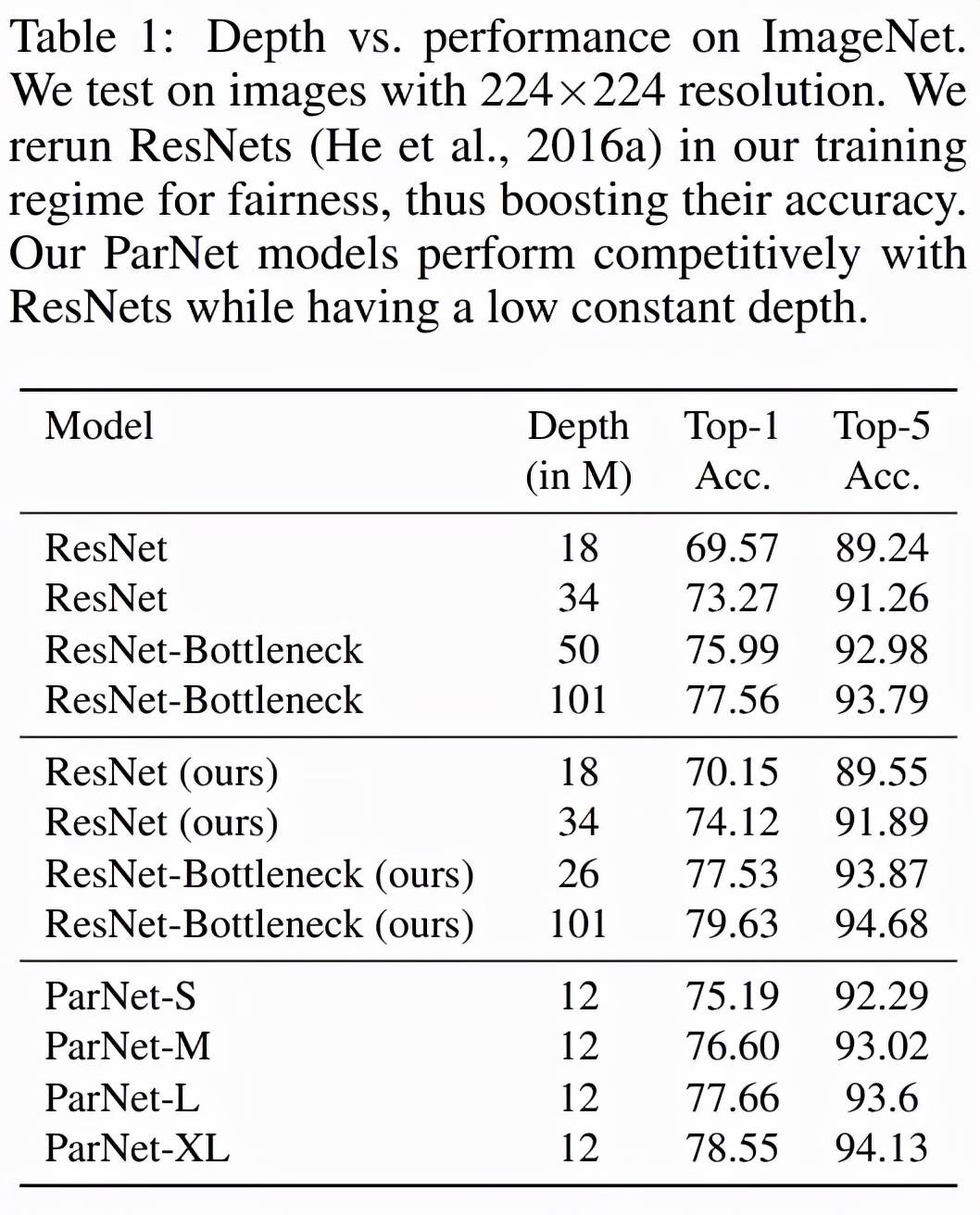

表 1 展示了 ParNet 在 ImageNet 上的性能 。 该研究发现 , 深度仅为 12 的网络就可以实现惊人的高性能 。 为了与 ResNet 进行公平比较 , 研究者使用相同的训练协议和数据增强重新训练 ResNet , 这将 ResNet 的性能提升到了超越官方结果的水平 。 值得注意的是 , 该研究发现 ParNet-S 在参数数量较少的情况下(19M vs 22M)在准确率上比 ResNet34 高出 1 个百分点以上 。 ParNet 还通过瓶颈设计实现了与 ResNet 相当的性能 , 同时深度减少到 1/4-1/8 。

文章图片

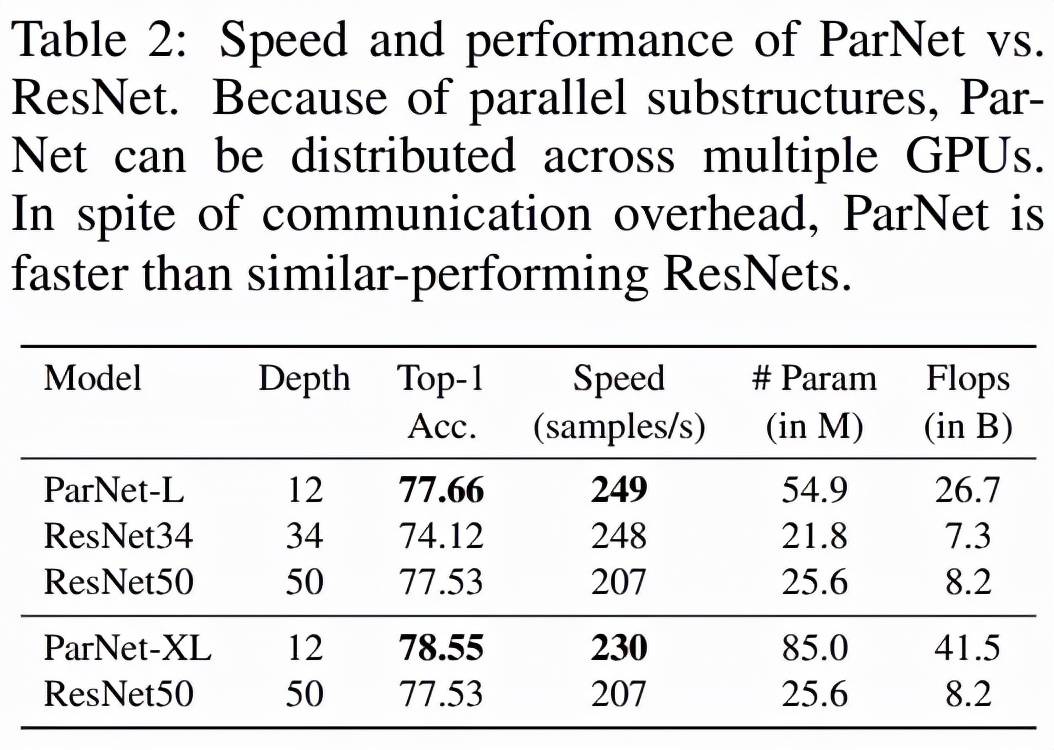

如下表 2 所示 , ParNet 在准确率和速度上优于 ResNet , 但参数和 flop 也更多 。 例如 , ParNet-L 实现了比 ResNet34 和 ResNet50 更快的速度和更好的准确度 。 类似地 , ParNet-XL 实现了比 ResNet50 更快的速度和更好的准确度 , 但具有更多的参数和 flop 。 这表明使用 ParNet 代替 ResNet 时存在速度与参数和 flop 之间的权衡 。 请注意 , 可以通过利用可以分布在 GPU 上的并行子结构来实现高速 。

文章图片

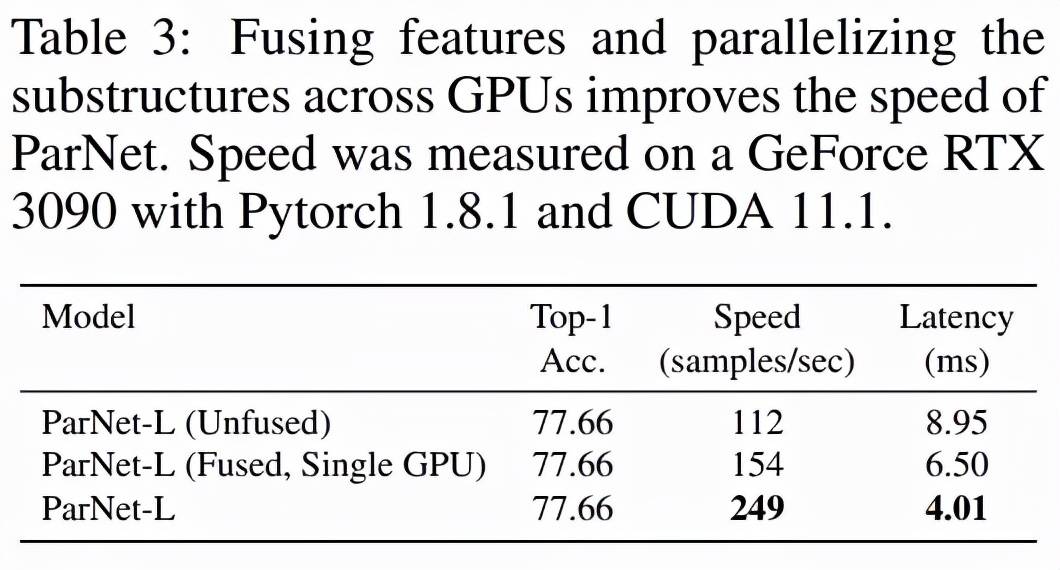

该研究测试了 ParNet 三种变体的速度:未融合、融合和多 GPU , 结果如下表 3 所示 。 未融合的变体由 RepVGG-SSE 块中的 3×3 和 1×1 分支组成 。 在融合变体中 , 使用结构重参数化技巧将 3×3 和 1×1 分支合并为一个 3×3 分支 。 对于融合和未融合变体 , 该研究使用单个 GPU 进行推理 , 而对于多 GPU 变体 , 使用了 3 个 GPU 。 对于多 GPU 变体 , 每个流都在单独的 GPU 上启动 。 当一个流中的所有层都被处理时 , 来自两个相邻流的结果将在其中一个 GPU 上连接并进一步处理 。 为了跨 GPU 传输数据 , 该研究使用了 PyTorch 中的 NCCL 后端 。

文章图片

该研究发现尽管存在通信开销 , 但 ParNet 仍可以跨 GPU 有效并行化以进行快速推理 。 使用专门的硬件可以减少通信延迟 , 甚至可以实现更快的速度 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。