作为元宇宙最坚定的支持者之一 , Facebook 在上个月宣布改名 Meta , 此后便新动作不断 , 先是推出了一个触觉手套, 试图让人们在 VR 世界中也能体验到触觉变化 。

文章图片

【在元宇宙听不懂外语怎么办?Meta:新技术可翻译 128 种语言】▲ 图源:Meta

触觉之后 , Meta 又盯上了语言 , 它要让人们在虚拟世界中也可以无障碍沟通 , 哪怕双方使用的语言不同 , 你说英语 , 我说中文都能互相理解 。

就这样 XLS-R 来了 , 它是 Meta 最近发布的一个 AI 语言处理模型 , 最高能识别 128 种语言 , 目前已经公布了网页体验版 。

文章图片

▲

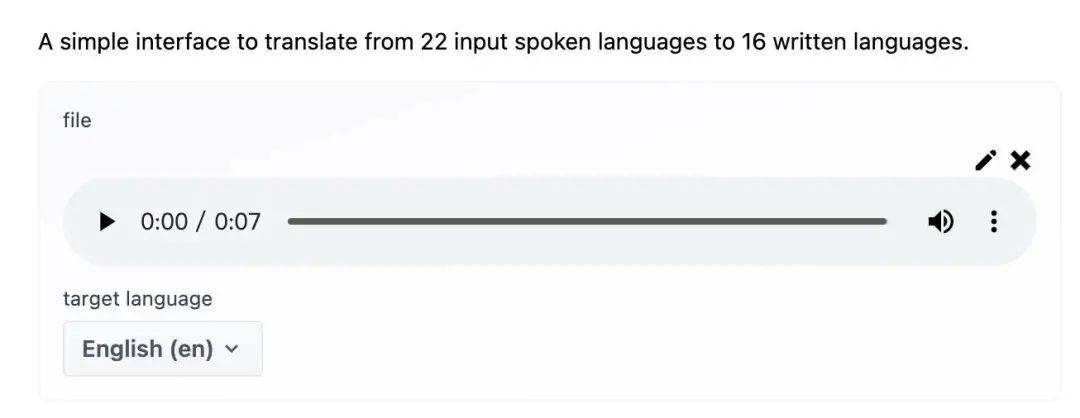

XLS-R 网页体验版仅支持语音输入

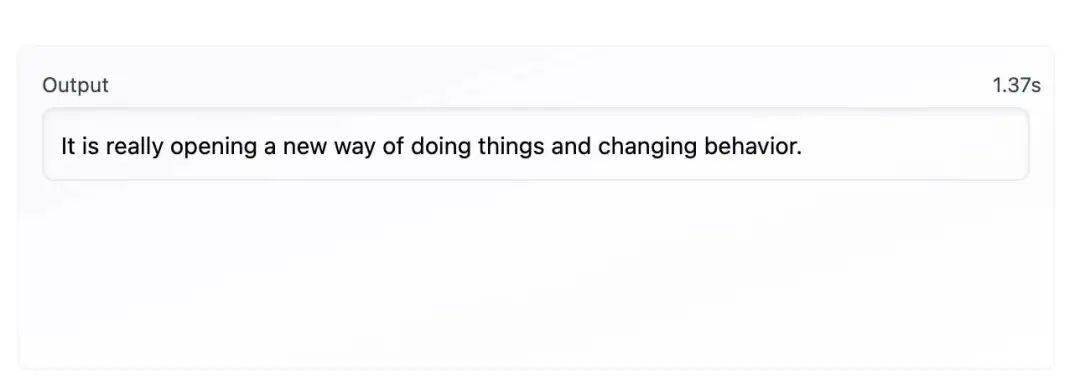

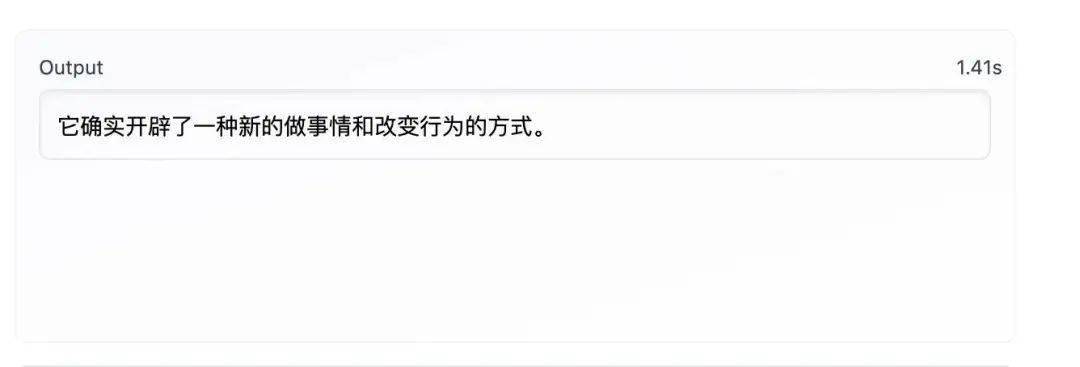

体验版的功能有一定缺失 , 仅支持将 22 种语言翻译为 16 种语言 , 我试了下最常见的英译中 , 一段 7 秒左右英文语音 , XLS-R 还是能相对准确地识别 , 中文翻译和英文识别都基本正确 , 两者耗时都在 1.4 秒 左右 , 并不算短 。

文章图片

文章图片

▲

XLS-R 识别同一段语音的英文和中文翻译结果

对比市面上常见语音翻译应用 , 这个速度和转译表现其实中规中矩 , 都对口语清晰度有要求 , 一旦语速稍微快一些 , 就比较难理解 , 转译会出错 。

XLS-R 的潜力体现在多语言通用 AI 模型上 , 据 Meta 该技术基于 wac2vec 2.0 预训练模型 , 能将语音拆成拆成 25 毫秒的基本单元来分析 , 利用上下文转换语音内容 , 提升识别准确度 。

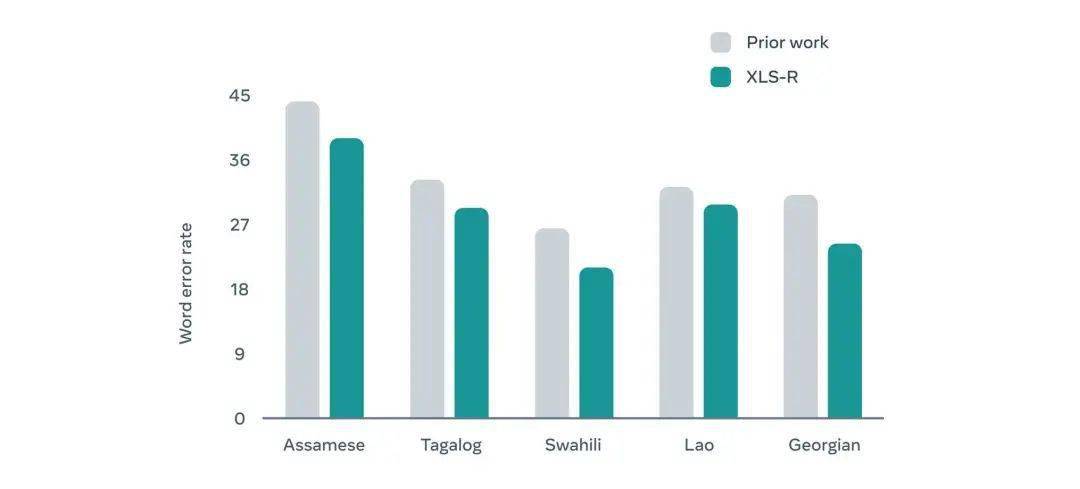

之后 Meta 又对 wac2vec 2.0 技术进行了多次调整 , 尝试处理多种语言 , 转换准确率提升了不少 , 经过通过 436000 小时的公开录音训练后 , 才有如今的 XLS-R 。

文章图片

▲

XLS-R 识别单词错误率更低. 图源:Meta

XLS-R 仅仅用一种语言模型就可以转换 128 种语言 , 和特殊领域使用特殊模型的常见做法不同 , 极大地提升了通用性 。 在官方博客中 , Meta 表示它们的目标是用单一模型识别全球 7000 多种语言 , 从而改进转换算法 。

这是一个新的开始 , 离真正成为 Meta 所设想的虚拟世界基础组成部分还比较难 , 这不仅仅和技术有关 , 设备算力也是限制 。

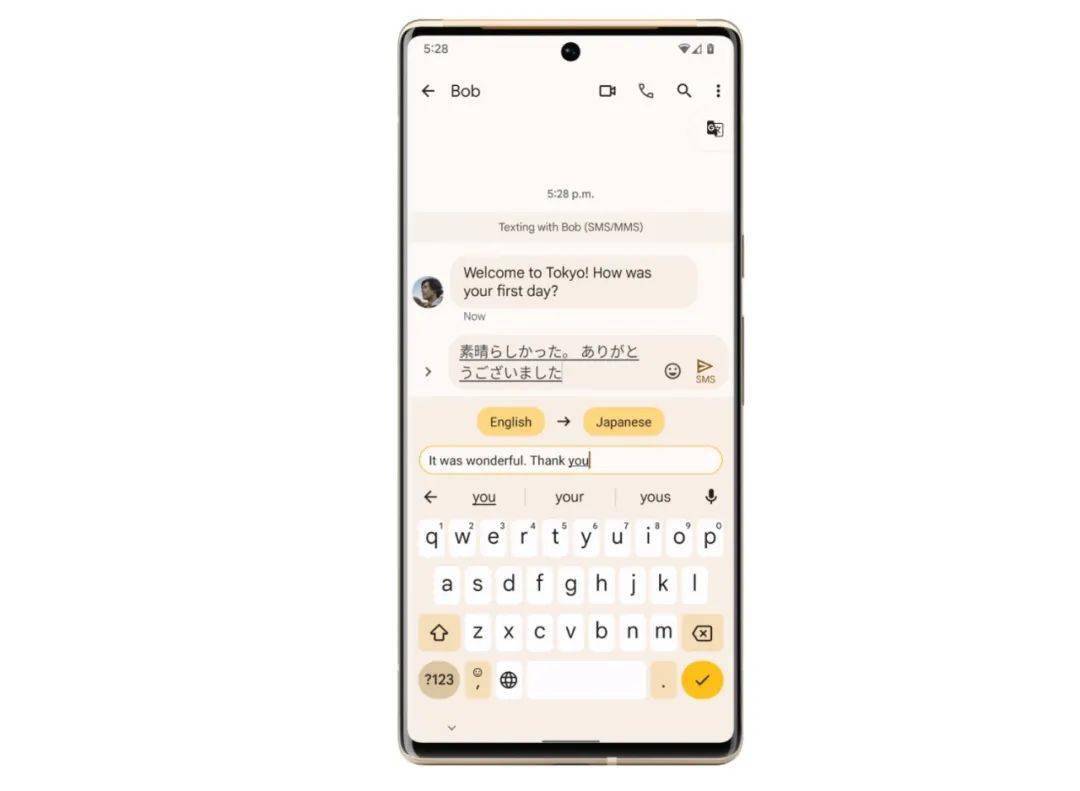

作为同在在自然语言识别领域拥有大量技术储备的 Google , 其实比 Meta 更早在消费级设备上支持多语种翻译功能 ,Pixel 6 系列支持 live Translate 功能, 可以在聊天软件中进行翻译 , 无障碍地与外语朋友交流 。

文章图片

只是 live Translate 功能支持的语言并不算多 , 主要还是英语、德语、日语之间的翻译 , 哪怕 Pixel 6 所使用的 Tensor 芯片在 AI 性能方面已经是冠绝全球 , 达到了骁龙 888+ 的三倍 。

只有联网 live Translate 功能才能做到支持 48 种语言 , 而使用云计算技术的 Google 翻译也仅支持 108 种语言 , 离 7000 种语言很远 。

元宇宙离我们仍然有一段距离 , 不过 XLS-R 等技术作为 Meta 口中虚拟世界的基础建设之一 , 或许能在其他领域发挥作用 , 现在它已经发布了 XLS-R 预训练模型的微调教程 , 让业内人士可以基于它进行微调以便应用到具体的工作当中 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。