文章图片

学习用于视觉内容的 PeCo

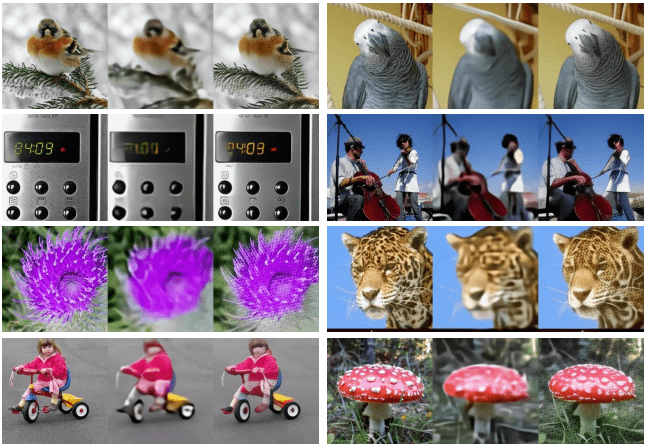

该研究提出 , 在不包含像素损失的情况下 , 对模型强制执行原始图像和重构图像之间的感知相似性 。 感知相似性不是基于像素之间的差异得到的 , 而是基于从预训练深度神经网络中提取的高级图像特征表示之间的差异而得到 。 该研究希望这种基于 feature-wise 的损失能够更好地捕捉感知差异并提供对低级变化的不变性 。 下图从图像重构的角度展示了模型使用不同损失的比较 , 结果表明图像在较低的 pixel-wise 损失下可能不会出现感知相似:

文章图片

图 1. 不同损失下的图像重构比较 。 每个示例包含三个图像 , 输入(左)、使用 pixel-wise 损失重构图像(中)、使用 pixel-wise 损失和 feature-wise 损失重构图像(右) 。 与中间图像相比 , 右侧图像在感知上与输入更相似 。

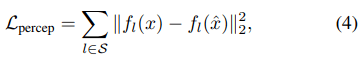

在形式上 , 假设输入图像 x 和重构图像

文章图片

的感知度量可以表示为:

文章图片

其中 S 表示提取特征的层数 , 总的目标函数为:

文章图片

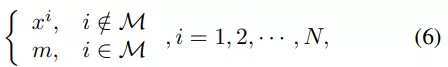

BERT objective 执行掩码图像建模

该研究采用 BERT objective 在离散视觉 token 上执行掩码图像建模任务 , 如 BEiT 。 对于给定的图像 x , 输入 token 为不重叠的图像 patch , 输出 token 是通过学习方程 (5) 获得的离散感知视觉单词 。 设输入为 {x_1 , x_2 , · · · , x_N } , 并且真值输出为

文章图片

。掩码图像建模的目标是从掩码输入中恢复相应的视觉 token , 其中一部分输入 token 已被掩码掉 。 准确地说 , 令 M 为掩码索引集合 , 掩码输入

文章图片

表示为:

文章图片

其中 , m 是与非掩码 token 相同维度的可学习掩码 token 。 掩码(masked)输入 token 被送入 L 层视觉 Transformer , 最后一层的隐藏输出表示为 {h^1 , h^2 , · · · , h^N } 。

实验

该研究将预训练模型应用于各种下游任务 , 包括 ImageNet-1K 分类、COCO 目标检测和 ADE20k 分割 。

与 SOTA 模型比较

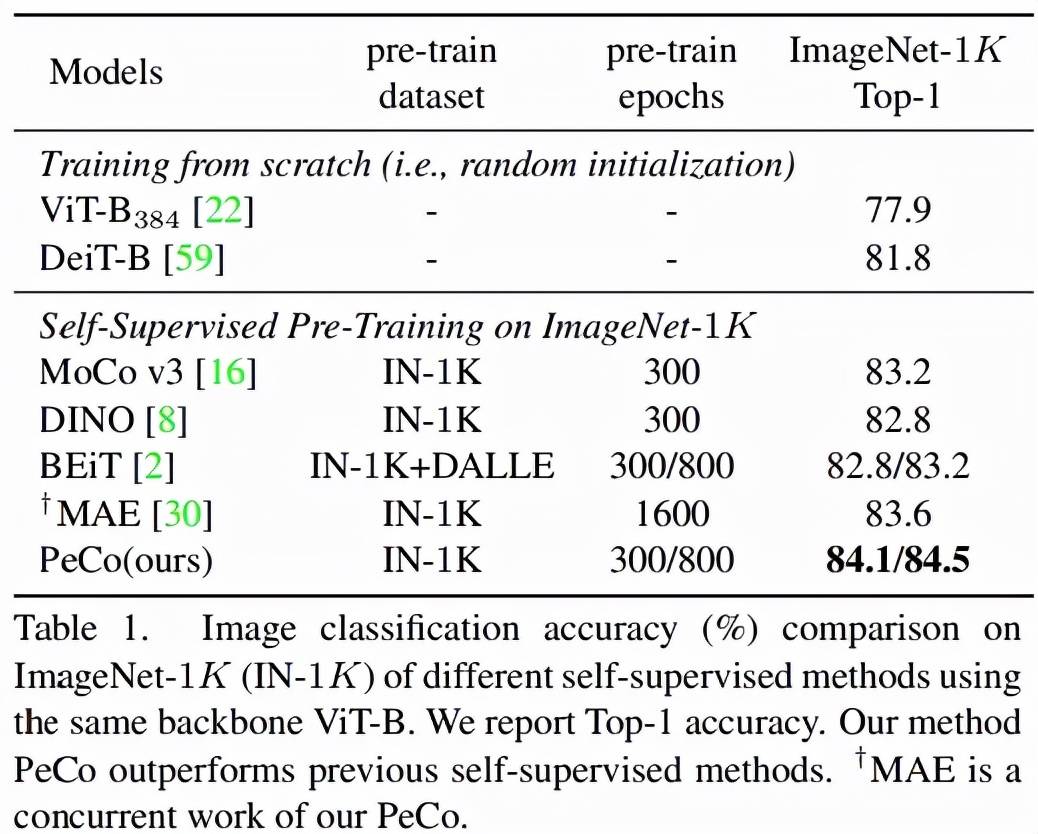

首先该研究将 PeCo 与 SOTA 研究进行比较 。 研究者使用 ViT-B 作为主干并在 ImageNet-1K 上进行预训练 , epoch 为 300。

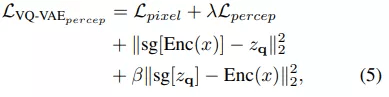

图像分类任务:在 ImageNet 1K 上进行分类任务的 Top-1 准确率如表 1 所示 。 可以看出 , 与从头开始训练的模型相比 , PeCo 显着提高了性能 , 这表明预训练的有效性 。 更重要的是 , 与之前自监督预训练模型相比 , PeCo 模型实现了最佳性能 。 值得一提的是 , 与采用 800 epoch 的 BEiT 预训练相比 , PeCo 仅用 300 epoch 就实现了 0.9% 的提高 , 并比 MAE 采用 1600 epoch 预训练性能提高 0.5% 。 这验证了 PeCo 确实有利于预训练 。

文章图片

语义分割任务:该研究将 PeCo 与 1)在 ImageNet-1K 上进行监督预训练和 2)BEiT(SOTA 性能自监督学习模型)进行比较 , 评估指标是 mIoU , 结果如表 2 所示 。 由结果可得 , PeCo 在预训练期间不涉及任何标签信息 , 却取得了比监督预训练更好的性能 。 此外 , 与自监督 BEiT 相比 , PeCo 模型也获得了较好的性能 , 这进一步验证了 PeCo 的有效性 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。