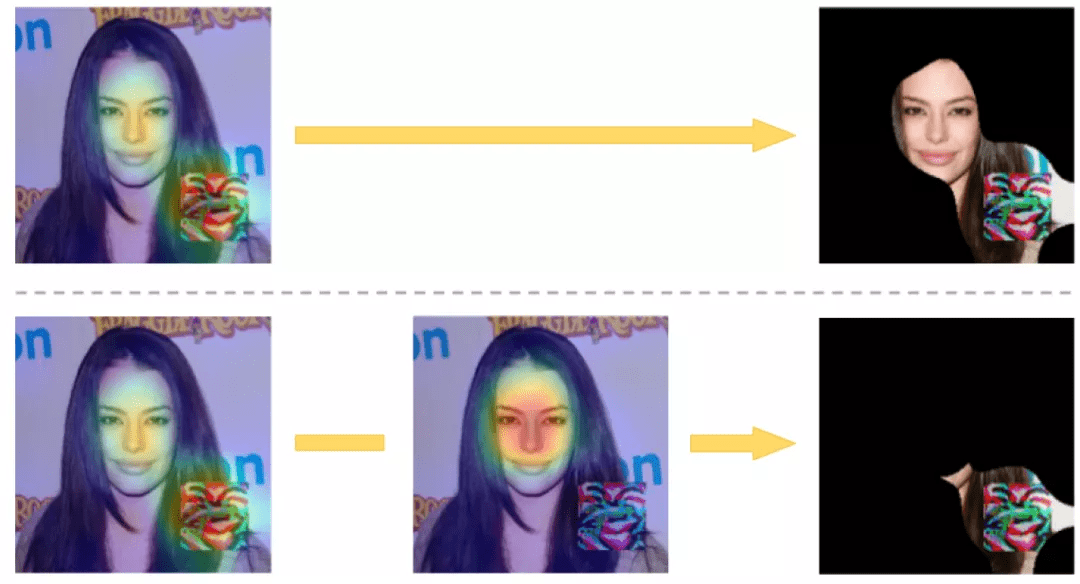

精确的掩模生成 。 尽管 Grad-CAM 可以成功地识别与对抗性目标相对应的鉴别性输入区域 , 但它也可能识别良性的 salient 区域 。 图 11 给出了一个说明性示例 , Grad-CAM 为一个人脸识别网络生成的热图既覆盖了木马的触发补丁 , 也覆盖了原始的人脸区域 。 为了提高掩模准确性 , 作者提出需要对输入图像的选定区域进行额外预测 。 然后 , 对于每个预测 , 使用 Grad-CAM 来提取一个与预测最相关的输入区域的掩模 。 最后 , 结合这些额外的掩模来完善初始预测 y 的掩模 。

文章图片

图 11. 上一行:使用渐变 CAM 生成掩模 。 左图显示了与目标 “0” 类别相关的 Grad-CAM 热图 , 右图显示了覆盖了物理攻击以外区域的提取掩模 。 下一行:左图是相对于目标 “0” 类别的 Grad-CAM 热图 , 该行中间的图是对应于给定类别的 Grad-CAM

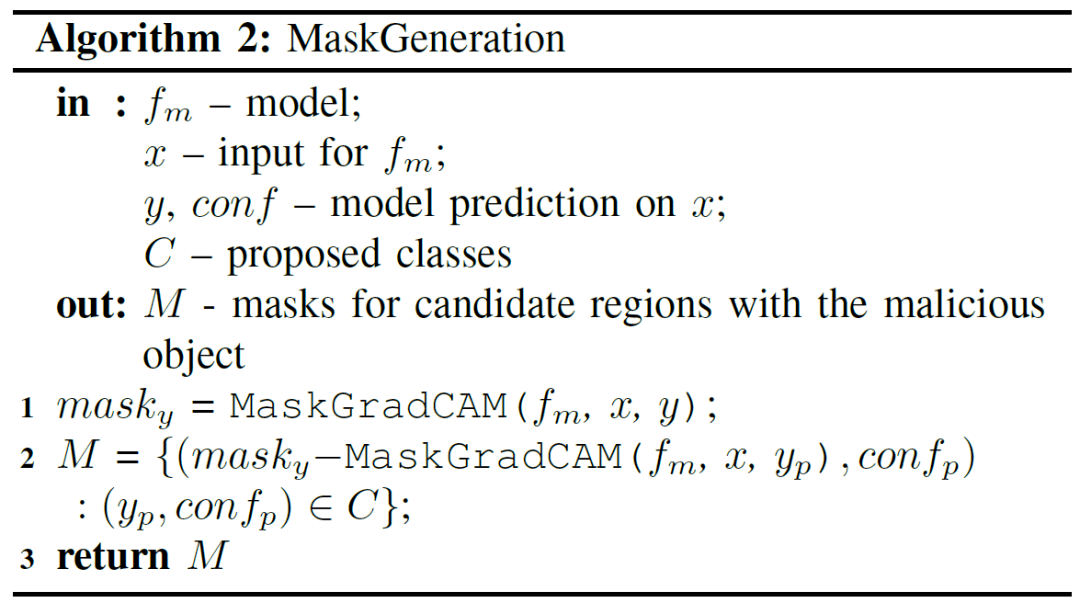

一旦得到了图片中可能存在的类别列表 , 我们就会划出与每个预测类别更相关的区域 x 。 为简单起见 , 作者假设每个输入只能包含一个恶意对象 。 Algorithm 2 给出了从 x 中提取输入区域的过程 。

文章图片

首先 , 使用 Grad-CAM 对输入的 x 和预测的 y 提取掩模 , 同时还为每一个建议的类别 y_p 提取一个掩模 。 在其他的建议类别上执行 Grad-CAM , 可以让我们在对抗性攻击之外找到图像的重要区域 。 此外 , 由于对抗性区域通常与非目标类别呈负相关性 , 热图主动避免突出图像的对抗性区域 。 我们可以使用这些热图来生成二级掩模 , 通过减去掩模重叠的区域来改进原始掩模 。 这能够保证掩模只突出局部攻击 , 而不会突出图像中的其他 salient 区域 。 由图 11 我们可以看到使用这种方法生成了一个更精确的掩模 , 其中只包含了大部分对抗性区域 。

3.1.2 攻击检测

攻击检测需要两个步骤 。 首先 , 如上所述 , SentiNet 提取可能包含对抗性补丁的输入区域 。 然后 , SentiNet 在一组良性图像上测试这些区域 , 以区分对抗性区域和良性区域 。

测试- 一旦定位了输入区域 , SentiNet 就会观察该区域对模型的影响 , 以确定该区域是对手的还是良性的 。 为此 , SentiNet 将可疑区域叠加在一组良性测试图像 X 上 。 将测试图像反馈到网络中 , 网络计算被欺骗的样本数量并用于对抗性图像 。 直观地说 , 可能欺骗模型的变异图像数量越多 , 疑似区域就越有可能是对抗性攻击 。 当恢复的掩模较小时 , 这种反馈技术能有效区分对抗性和良性输入 , 因为小的良性物体通常不能影响到网络的预测 。 然而 , 这种方法的一个问题是 , 一个覆盖了输入图像较大区域的掩模在叠加到其他图像上时 , 很可能会造成错误的分类 。 例如 , 考虑一个输入图像 x 的较大掩模 , 当叠加时 , 掩模内的特征可能比外面的特征相关性更强 , 这就提高了将变异的测试输入分类为 y 的可能性 。 为了解决这一问题 , 作者引入了惰性模式(inert patterns) , 其作用是抑制掩模内部的特征 , 从而提高网络对掩模外特征的反应 。

检测的决策边界- 有了这两个指标(被欺骗的图像数量和平均惰性模式置信值) , 我们可以确定在哪些条件下输入的 x 是对抗性的 。 下一步 , 作者希望引入一种技术 , 使我们能够根据攻击无关的指标 , 将未见过的对抗性输入识别为攻击 。 图 12 给出一个示例 , 其中红色的三角点代表的是在对抗性样本中发现的指标 , 蓝色的圆点是根据清洁样本计算得到的 。 我们可以看到对抗性样本大多聚集在图中右上角的位置 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。