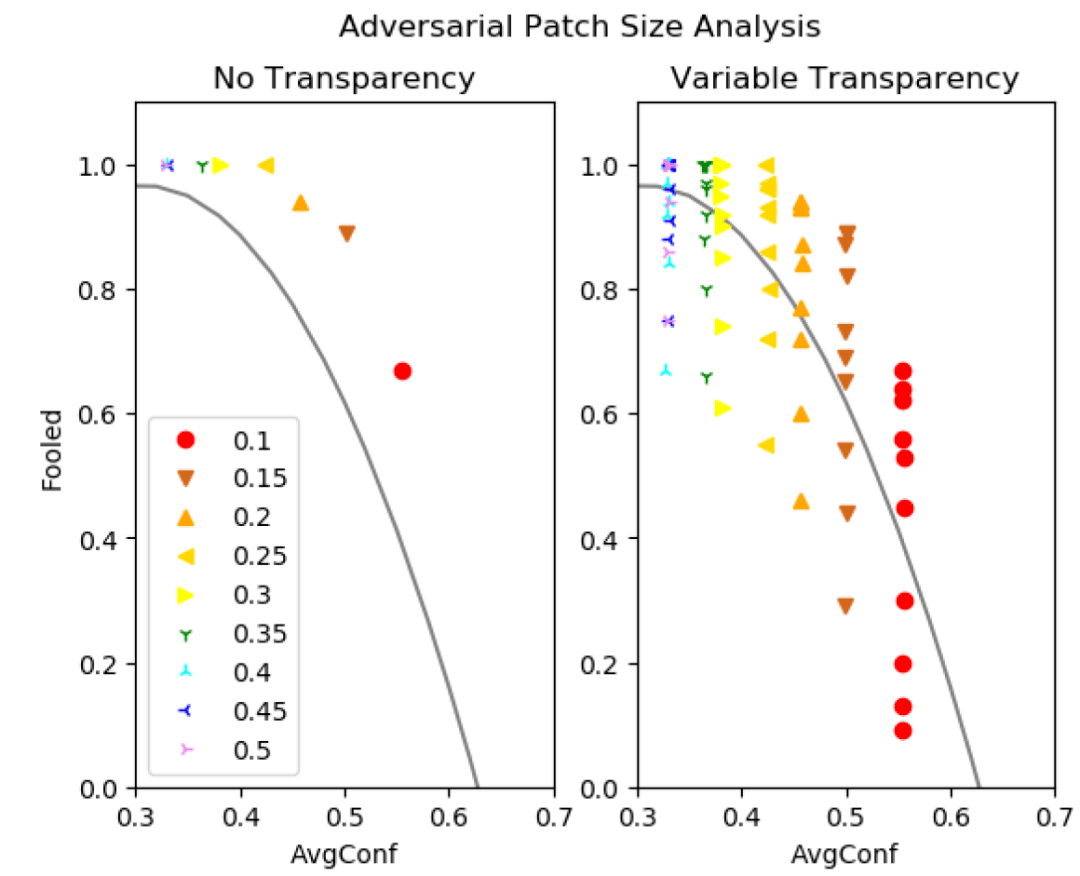

如果攻击者使用足够大的补丁 , X 上的平均置信度将降低 , 从而降低防御的有效性 。 由图 15 可以看出 , 对于对抗性补丁 , 攻击的 avgConf 随着补丁大小的增加而下降 。 通过增加补丁的透明度 , 我们可以将攻击降低到阈值以下 , 同时保持非常高的攻击成功率 。

文章图片

图 15. 对抗性补丁大小分析

4、小结

我们在这篇文章中讨论了多媒体领域的物理攻击问题 , 包括图像领域、音频领域等 。 与算法攻击相比 , 在图像或音频上施加物理攻击的难度性低 , 进一步损害了深度学习技术的实用性和可靠性 。 我们选择了三篇文章从攻击和防御的角度分别进行了探讨 , 同时包括了图像领域和音频领域的攻击 。 由于物理攻击对于人类来说是易于发现的 , 所以从文章给出的实验结果来看 , 不同方法的防御效果都不错 。 不过 , 几篇文章中谈到的防御都是限定攻击类型的防御 , 如何对不可知的攻击进行有效防御仍值得进一步研究和探讨 。

分析师介绍:Jiying , 工学博士 , 毕业于北京交通大学 , 曾分别于香港中文大学和香港科技大学担任助理研究员和研究助理 , 现从事电子政务领域信息化新技术研究工作 。 主要研究方向为模式识别、计算机视觉 , 爱好科研 , 希望能保持学习、不断进步 。

本文参考引用的文献

[1] Kevin Eykholt; Ivan Evtimov; Earlence Fernandes; Bo Li; Amir Rahmati; Chaowei Xiao; Atul Prakash; Tadayoshi Kohno; Dawn Son , Robust Physical-World Attacks on Deep Learning Visual Classification , CVPR 2018 ,https://ieeexplore.ieee.org/document/8578273(https://robohub.org/physical-adversarial-examples-against-deep-neural-networks/)

[2] Zirui Xu , Fuxun Yu; Xiang Chen , LanCe: A Comprehensive and Lightweight CNN Defense Methodology against Physical Adversarial Attacks on Embedded Multimedia Applications , 25th Asia and South Pacific Design Automation Conference (ASP-DAC) , 2020 , https://ieeexplore.ieee.org/document/9045584

[3] Chou E , F Tramèr, Pellegrino G . SentiNet: Detecting Physical Attacks Against Deep Learning Systems. 2020. https://arxiv.org/abs/1812.00292

[4] A. Kurakin, I. Goodfellow, and S. Bengio. Adversarial examples in the physical world. arXiv preprint arXiv:1607.02533, 2016.

[5] K. Eykholt, I. Evtimov, E. Fernandes, B. Li, D. Song, T. Kohno, A. Rahmati, A. Prakash, and F. Tramer. Note on Attacking Object Detectors with Adversarial Stickers. Dec. 2017.

[6] I. Goodfellow and et al., “Explaining and harnessing adversarial examples,” arXiv preprint arXiv:1412.6572, 2014.

[7] J. Hayes, “On visible adversarial perturbations & digital watermarking,” in Proc. of CVPR Workshops, 2018, pp. 1597–1604.

[8] Z. Yang and et al., “Characterizing audio adversarial examples using temporal dependency,” arXiv preprint arXiv:1809.10875, 2018.

[9] Q. Zeng and et al., “A multiversion programming inspired approach to detecting audio adversarial examples,” arXiv preprint arXiv:1812.10199, 2018.

[10] K. Rajaratnam and et al., “Noise flooding for detecting audio adversarial examples against automatic speech recognition,” in Proc. of ISSPIT, 2018, pp. 197–201.

[11] T. Gu, B. Dolan-Gavitt, and S. Garg, “Badnets: Identifying vulnerabilities in the machine learning model supply chain,” CoRR, vol. abs/1708.06733, 2017. [Online]. Available: http://arxiv.org/abs/1708.06733

[12] Y. Liu, S. Ma, Y. Aafer, W.-C. Lee, J. Zhai, W. Wang, and X. Zhang, “Trojaning attack on neural networks,” in NDSS, 2018.

[13] K. Simonyan and A. Zisserman, “Very deep convolutional networks for large-scale image recognition,” CoRR, vol. abs/1409.1556, 2014. [Online]. Available: http://arxiv.org/abs/1409.1556

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。