3月1日起 , 国家网信办等四部门联合发布的《互联网信息服务算法推荐管理规定》正式施行 。 “向用户提供便捷的关闭算法推荐服务的选项”等规定 , 贴近用户实际需求 , 而且在全球范围内开启对具体算法加以监管的先河 , 因此广受关注 。 本文分析了相关规定的来龙去脉 , 以及未来可能的发展 。

文 观察者网专栏作者 熊节

马酷洞察创始人/总编

手机上的App会“读心术”早已不是秘密了 。 很多人有过这样的体验:刚和朋友聊天说到什么想买什么 , 转眼就在某App里看见了这件商品;刚浏览了几条某个主题的新闻 , 突然某App里就全是关于这件事的回答 。

长期来 , 许多网民对这种情况感到不满 , 甚至有点恐惧 。

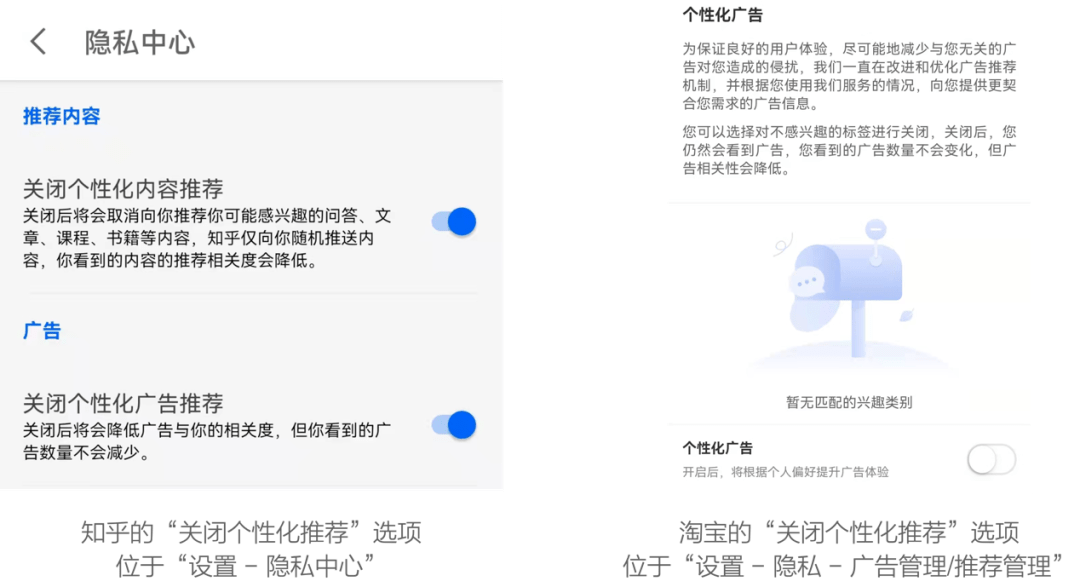

如今 , 一个开关“千呼万唤始出来” , 在许多常用App的“设置”页 , 您应该能找到“关闭个性化推荐”之类的选项 。

笔者找到了“知乎”和“淘宝”的相关开关并亲测:

【算法推荐终于可关闭,中国规定开世界先河】

文章图片

为何各个常见的App悄悄给出了关闭个性化推荐的选项?原因是今年1月4日正式公布的 《互联网信息服务算法推荐管理规定》(下文简称《规定》)中有这么一条:

第十七条 算法推荐服务提供者应当向用户提供不针对其个人特征的选项 , 或者向用户提供便捷的关闭算法推荐服务的选项 。 用户选择关闭算法推荐服务的 , 算法推荐服务提供者应当立即停止提供相关服务 。

这份由国家互联网信息办公室、工业和信息化部、公安部、国家市场监督管理总局联合发布的《规定》将于今年3月1日正式起施行 。

据笔者所知 , 这是全世界第一个对算法推荐行为加以具体约束的法案 。

欧洲的《数字市场法案》(DMA)中也有“不允许利用数据优势向用户投放指向性广告 , 除非获得用户明确许可”的约定 , 但DMA去年11月才获得欧洲议会内部市场委员会通过 , 与欧洲各国政府的谈判还未启动 , 完成立法仍有一段距离 。

而中国各大互联网企业已经在以实际行动迎接《规定》的落地 。

算法推荐的潜在危害

2006年 , 哈佛大学凯斯·桑斯坦教授在《信息乌托邦》一书中提出 , 人类社会存在一种 “信息茧房”现象 。 他认为 , 在信息传播中人们自身的信息需求并非全方位的 , 只会注意选择自己想要的、能使自己愉悦的信息 , 久而久之接触的信息就越来越局限 , 就像蚕吐出来的丝一样 , 细细密密地把自己包裹起来 , 最终将自己桎梏在“信息茧房”内 , 失去接触和了解不同观念的机会 。

算法推荐则有可能强化信息茧房效应:你越是对某种事物感兴趣、倾向于某种观念 , 算法就会越是给你推荐关于这种事物、支持这种观念的材料 , 让你不断强化自己的兴趣和倾向 。 而且 , 算法推荐还可能被有目的性地引导人群 , 从而影响公众观念 , 甚至影响政治决策 。 因此 , 美国数学家凯西·奥尼尔在《算法霸权》一书中将推荐算法称作“数学大杀器”(weapons of math destruction) 。 在过去几年中 , 这件“大杀器”已经在现实世界中多次产生效果 。

就在美国大选前几个月 , 英国的剑桥分析(Cambridge Analytica)公司使用来自脸书的用户数据操纵了英国脱欧(Brexit)公投 , 令脱欧派意外获胜——与特朗普意外当选如出一辙 。

在正式用于影响英美政局之前 , 类似的手段已经在多个发展中国家做过实验 。 2010年 , 在特立尼达和多巴哥 , 一场起源于脸书的“Do So”运动让大批非洲裔选民拒绝投票 , 从而使印度裔主导的联合民族大会(UNC)在大选中受益 。 2015年 , 部分尼日利亚用户在脸书上看到暴力血腥、仇视穆斯林的视频短片 , 其目的是恐吓选民、操纵选举 。算法推荐一旦被滥用 , 真的可以成为“大杀器” 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。