左下象限:低理解 , 低效用

图神经网络(GNN)现在是机器学习中一个非常热门的领域 , 在多个领域都取得了可喜的成果 。 但是对于其中许多示例 , 尚不清楚 GNN 是否比使用更传统的结构化数据与深度学习架构配对的替代方法更好 。 数据自然是图结构的问题 , 例如化学信息学中的分子 , 似乎具有更引人注目的 GNN 结果(尽管这些通常不如非图相关的方法) 。 与大多数领域相比 , 用于大规模训练 GNN 的开源工具与工业中使用的内部工具之间似乎存在很大差异 , 这限制了大型 GNN 在这些围墙花园之外的可行性 。 该领域的复杂性和广度表明理论上限很高 , 因此 GNN 应该有成熟的空间并令人信服地展示某些任务的优势 , 这将导致更大的实用性 。 GNN 也可以从技术进步中受益 , 因为图目前不能自然地适用于现有的计算硬件 。

可解释的机器学习(IML)是一个重要且有前途的领域 , 并继续受到关注 。 SHAP 和 LIME 等技术已经成为真正有用的工具来询问 ML 模型 。 然而 , 由于采用有限 , 现有方法的效用尚未完全实现——尚未建立健全的最佳实践和实施指南 。 然而 , IML 目前的主要弱点是它没有解决我们真正感兴趣的因果问题 。 IML 解释了模型如何进行预测 , 但没有解释基础数据如何与它们因果关系(尽管经常被错误地解释像这样) 。 在取得重大理论进展之前 , IML 的合法用途大多仅限于模型调试 / 监控和假设生成 。

量子机器学习(QML)远远超出我的驾驶室 , 但目前似乎是一个假设性的练习 , 耐心等待可行的量子计算机可用 。 在那之前 , QML 微不足道地坐在左下角 。

渐进式进步、技术飞跃和范式转变

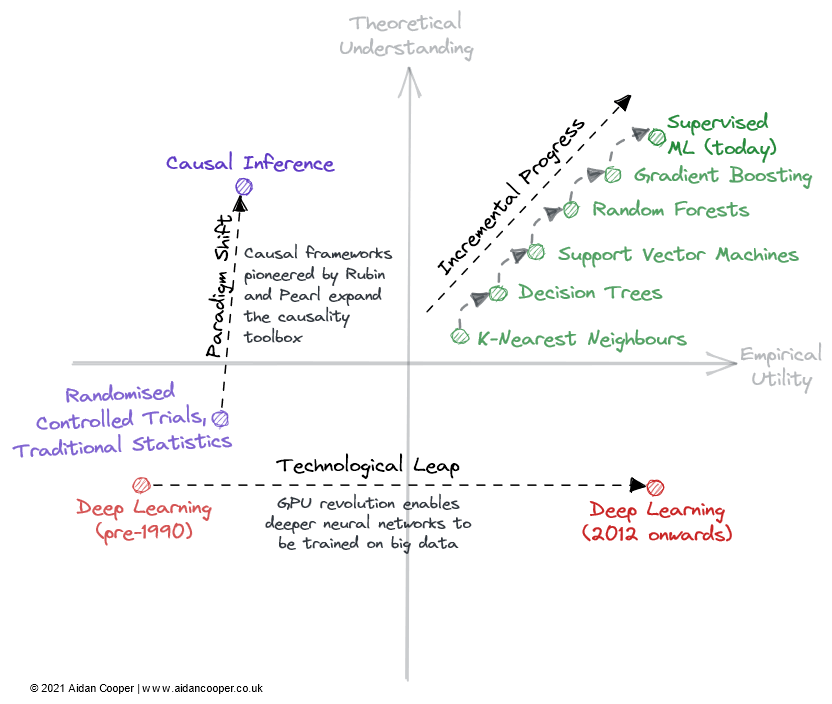

领域内主要通过三种主要机制来遍历理论理解与经验效用矩阵(图 2) 。

文章图片

【机器学习理论基础到底有多可靠?】字段可以遍历矩阵的方式的说明性示例 。

渐进式进展是缓慢而稳定的进展 , 它在矩阵的右侧向上移动英寸场 。 过去几十年的监督机器学习就是一个很好的例子 , 在此期间 , 越来越有效的预测算法被改进和采用 , 为我们提供了我们今天喜欢的强大工具箱 。 渐进式进步是所有成熟领域的现状 , 除了由于技术飞跃和范式转变而经历更剧烈运动的时期之外 。

由于由于技术的飞跃 , 一些领域看到了科学进步的阶梯式变化 。 * 深度学习 * 领域并没有被它的理论基础所解开 , 这些基础是在 2010 年代深度学习热潮之前 20 多年发现的——它是由消费级 GPU 支持的并行处理推动了它的复兴 。 技术飞跃通常表现为沿经验效用轴向右跳跃 。 然而 , 并非所有以技术为主导的进步都是飞跃 。 今天的深度学习的特点是通过使用更多的计算能力和越来越专业的硬件训练越来越大的模型来实现渐进式进步 。

在这个框架内科学进步的最终机制是范式转变 。 正如托马斯 · 库恩(Thomas Kuhn)在他的著作《科学革命的结构》中所指出的 , 范式转变代表了科学学科的基本概念和实验实践的重要变化 。 Donald Rubin 和 Judea Pearl 开创的因果框架就是这样一个例子 , 它将因果关系领域从随机对照试验和传统统计分析提升为更强大的数学化学科 , 形式为因果推理 。 范式转变通常表现为理解的向上运动 , 这可能会跟随或伴随着效用的增加 。

然而 , 范式转换可以在任何方向上遍历矩阵 。 当神经网络(以及随后的深度神经网络)将自己确立为传统 ML 的独立范式时 , 这最初对应于实用性和理解力的下降 。 许多新兴领域以这种方式从更成熟的研究领域分支出来 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。