实验结果

One-shot 4K 非重复图像合成

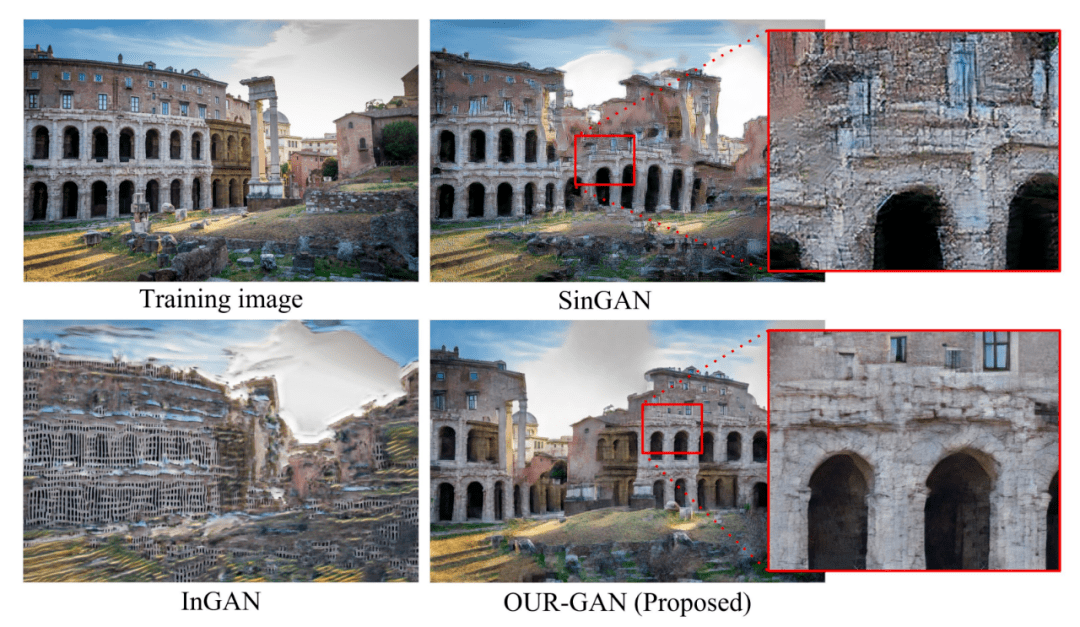

下图 8 展示了 OUR-GAN 生成的 4K 样本、基线模型以及 ground truth 图像 。

文章图片

图 8. OUR-GAN 生成的 4K 样本、基线模型生成的样本 , 以及 ground truth 图像 。

InGAN 未能合成包含大量形状的可视化超高分辨率图像 , 因为它是通过重复从小样本训练中学到的小规模模式来合成图像 。 SinGAN 可以生成大规模的模式 , 但是未能捕捉到结构细节 。 然而 , OUR-GAN 成功地合成了具有视觉连贯形状和精细细节的高质量图像 。 与其他模型相比 , OUR-GAN 合成了最具视觉冲击力的图像 。

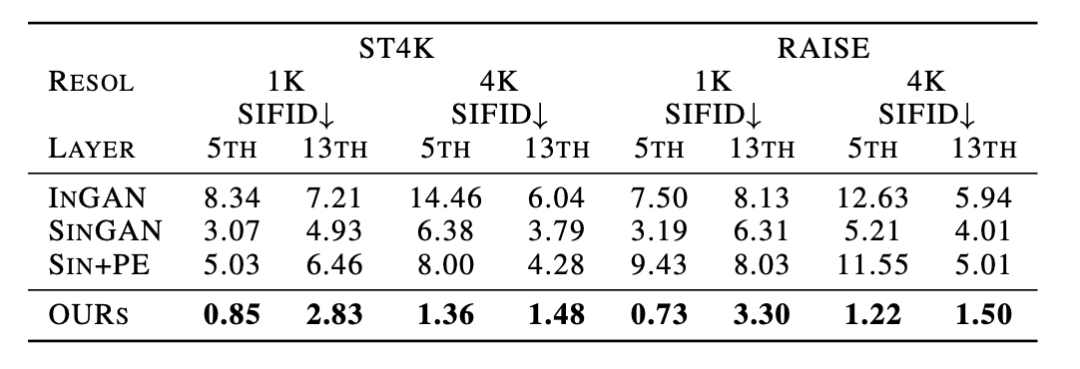

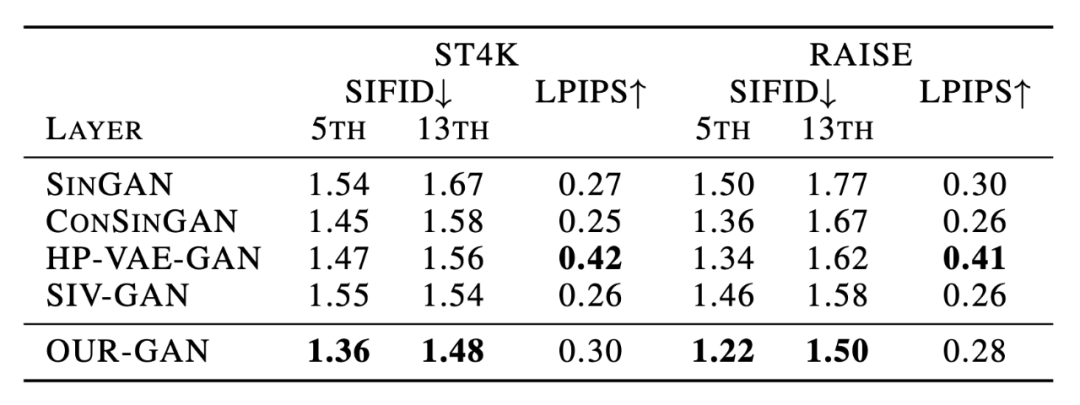

如下表 1 所示 , OUR-GAN 在定量研究中的表现也优于其他模型 , 它在所有配置中得分最高 , 这表明 OUR-GAN 综合了全局形状和局部细节的高质量图像 。

文章图片

全局连贯性和多样性

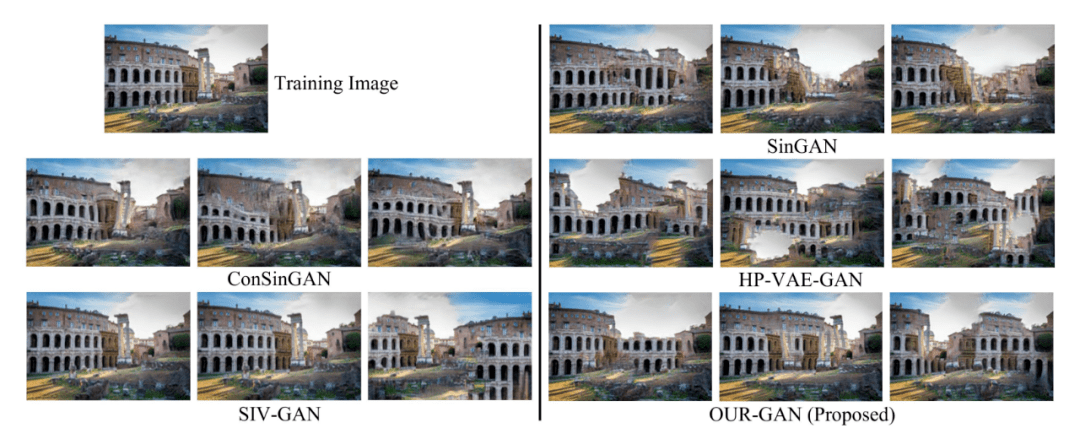

为了评估垂直坐标卷积的效果 , 研究者用其他模型替换了 OUR-GAN 的 first step 模型 , 并比较了合成图像的差异: SinGAN , ConSinGAN , HP-VAE-GAN , SIV-GAN 。

文章图片

图 9 。

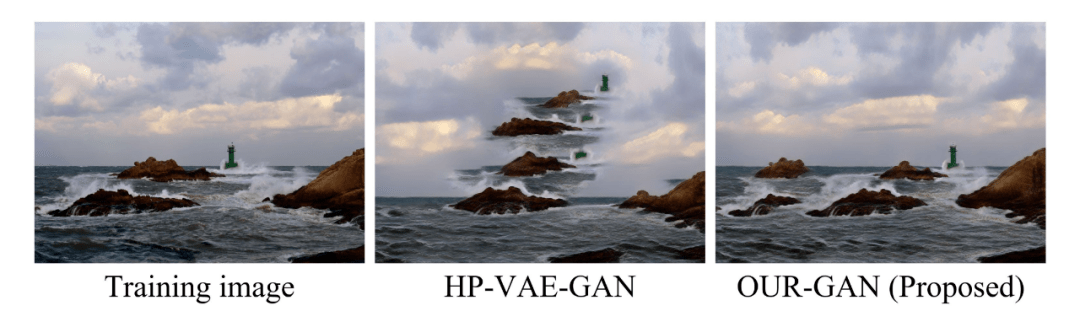

图 9 展示了生成的图像 。 ConSinGAN 和 SIV-GAN 生成的模式多样性有限 , 而 HPVAE-GAN 合成的扭曲结构结合了不相关的模式 。 如图 10 所示 , 与 HP-VAE-GAN 相比 , OUR-GAN 显著提高了模式的全局一致性 , 并且与 ConSinGAN 和 SIV-GAN 相比产生了更多样化的模式 。

文章图片

图 10: 采用垂直坐标卷积的效果 。 OUR-GAN 通过垂直坐标卷积的空间偏差来提高视觉连贯性 。

文章图片

表 2 。

表 2 列出了定量评价的结果 , OUR-GAN 在定量结果方面表现良好 。 OUR-GAN 的 SIFID 分数最低 , 这表明 OUR-GAN 在学习训练图像的内部统计数据方面是有效的 。 与 LPIPS 的其他基线相比 , OUR-GAN 没有表现出显著差异 。 然而 , 高 LPIPS 并不总是表明模型产生高质量的图像 , 因为它不惩罚视觉上不协调的模式(附录 H 展示了高 LPIPS 视觉不协调的样本) 。 尽管与 HP-VAE-GAN 相比 , OUR-GAN 缺乏多样性 , 但 OUR-GAN 可以合成视觉上更为连贯的图像 。

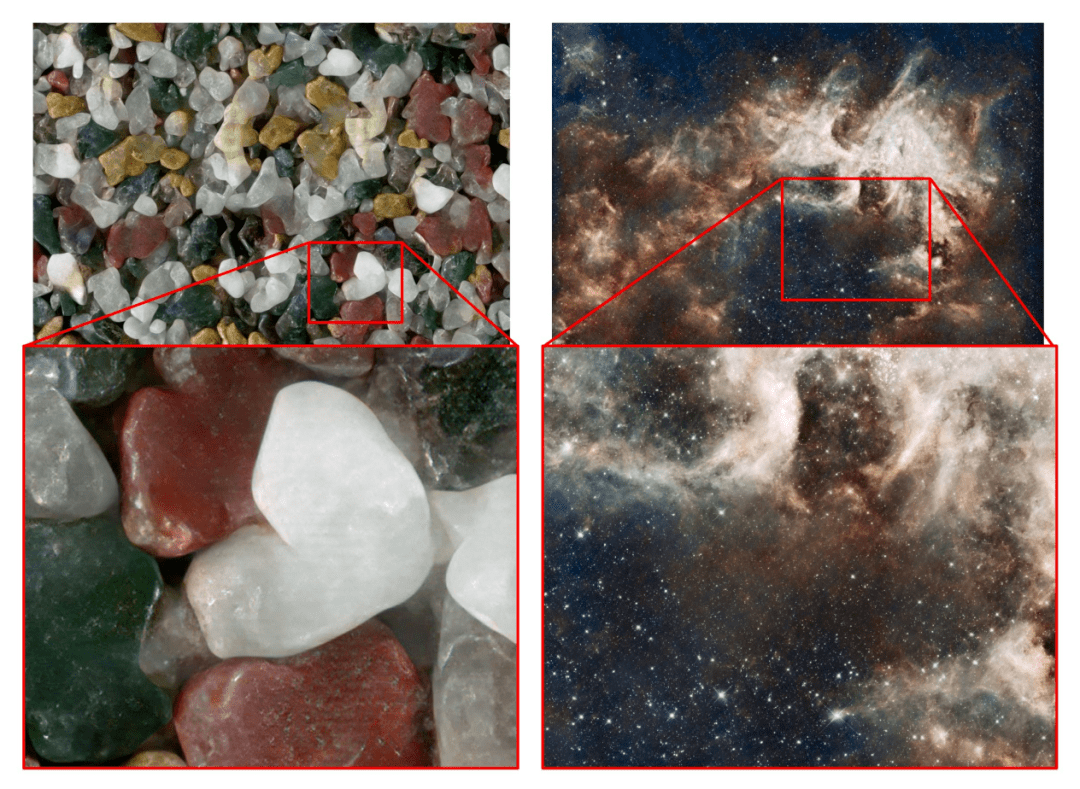

One-shot 高保真度 4K 纹理图像合成

文章图片

该研究还评估了 OUR-GAN 合成高保真 UHR 纹理图像的性能 。 OUR-GAN 从 ST4K 纹理图像和合成 UHR 图像中学习 , 图 11 中展示了两个合成样本 。

更多研究细节 , 可参考原论文 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。