选自arXiv

作者:Donghwee Yoon等

机器之心编译

编辑:蛋酱、张倩

在这篇论文中 , 研究者提出了 OUR-GAN , 这是首个单样本(one-shot)超高分辨率(UHR)图像合成框架 , 能够从单个训练图像生成具有 4K 甚至更高分辨率的非重复图像 。

文章图片

论文链接:https://arxiv.org/pdf/2202.13799.pdf

传统生成模型通常从相对较小的图像数据集中 , 基于 patch 分布学习生成大型图像 , 这种方法很难生成视觉上连贯的图像 。 OUR-GAN 以低分辨率生成视觉上连贯的图像 , 然后通过超分辨率逐渐提升分辨率 。 由于 OUR-GAN 从真实的 UHR 图像中学习 , 它可以合成具有精细细节的大规模形状 , 同时保持远距离连贯性 。

OUR-GAN 应用无缝衔接的子区域超分辨率 , 在内存受限的条件下合成 4K 或更高分辨率的 UHR 图像 , 并解决了边界不连续的问题 。 此外 , OUR-GAN 通过向特征图添加垂直位置嵌入来提高多样性和视觉连贯性 。 在 ST4K 和 RAISE 数据集上的实验结果表明:与现有方法相比 , OUR-GAN 表现出更高的保真度、视觉连贯性和多样性 。

我们来看一下 OUR-GAN 的合成效果 , 下图(上)是 OUR-GAN 训练使用的单个 4K 图像 , (下)是 OUR-GAN 合成的 16K (16384 x 10912) 图像 。

文章图片

文章图片

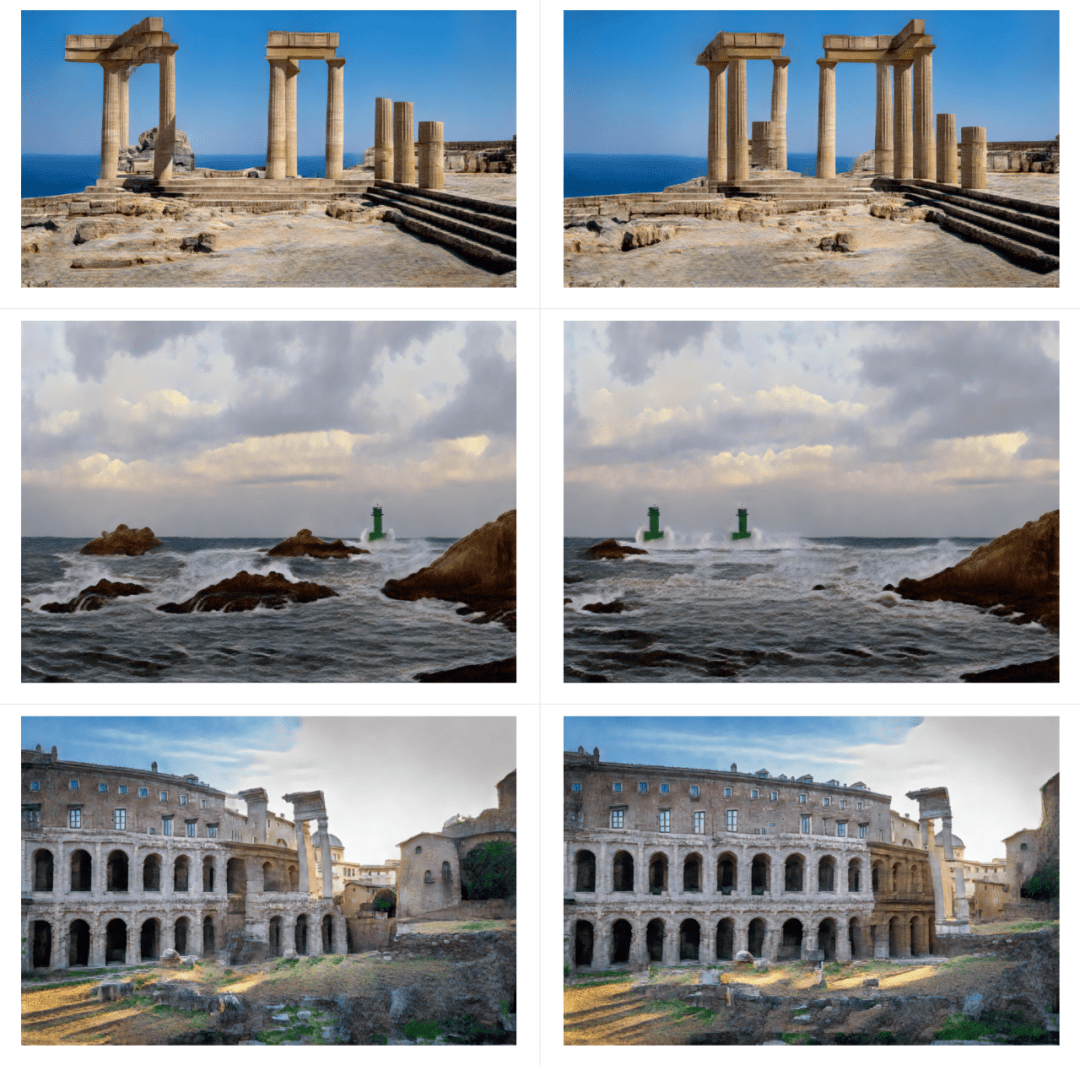

以下几组是 OUR-GAN 合成的 4K 风景图:

文章图片

OUR-GAN 成功合成了具有多种图案的高质量纹理图像:

文章图片

one-shot 超分辨率生成对抗网络

OUR-GAN 框架

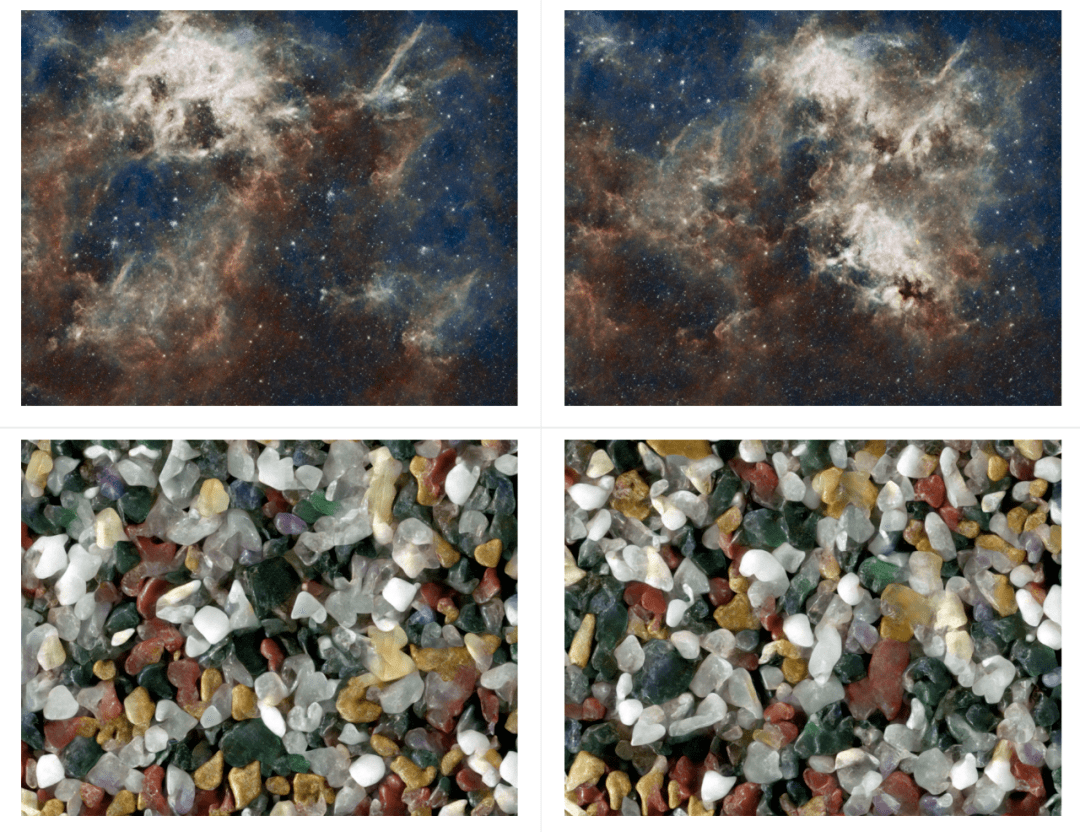

OUR-GAN 通过三个步骤合成占用有限 GPU 内存的 UHR 图像 , 如下图 3 所示 。 首先 , OURGAN 生成低分辨率的全局结构 。 然后通过 in-memory 超分辨率在内存限制内尽可能提高分辨率 。 最后 , OURGAN 通过逐个子区域应用超分辨率来进一步提高超出内存限制的分辨率来合成 UHR 图像 。

【从4K到16K仅用一张图像训练,首个单样本超高分辨率图像合成框架】

文章图片

超分辨率模型的输出分辨率受限于训练图像的分辨率 。 然而 , ZSSR 和 MZSR 已经证明 , 通过利用信息的内部循环 , 超分辨率模型可以生成比训练图像大 2 到 4 倍的图像 。

全局结构生成

从单个训练图像中学习合成具有全局连贯形状的不同图像 , 是一项具有挑战性的任务 。 该研究的初步实验比较了可以用单个图像训练的多个模型 。 其中 , HP-VAE-GAN 表现出比其他模型更高的多样性 , 但全局一致性不足 。 因此 , 该研究选择 HP-VAE-GAN 作为第一步的基线模型 , 并通过应用垂直坐标卷积来提高全局一致性 。 HP-VAE-GAN 通过基于分层 patch 的生成方案合成图像 , 如方程式 (1)-(3) , 其中

文章图片

、

文章图片

和

文章图片

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。