文章图片

任务驱动的语言建模(TLM) vs 预训练语言模型(PLMs)

文章图片

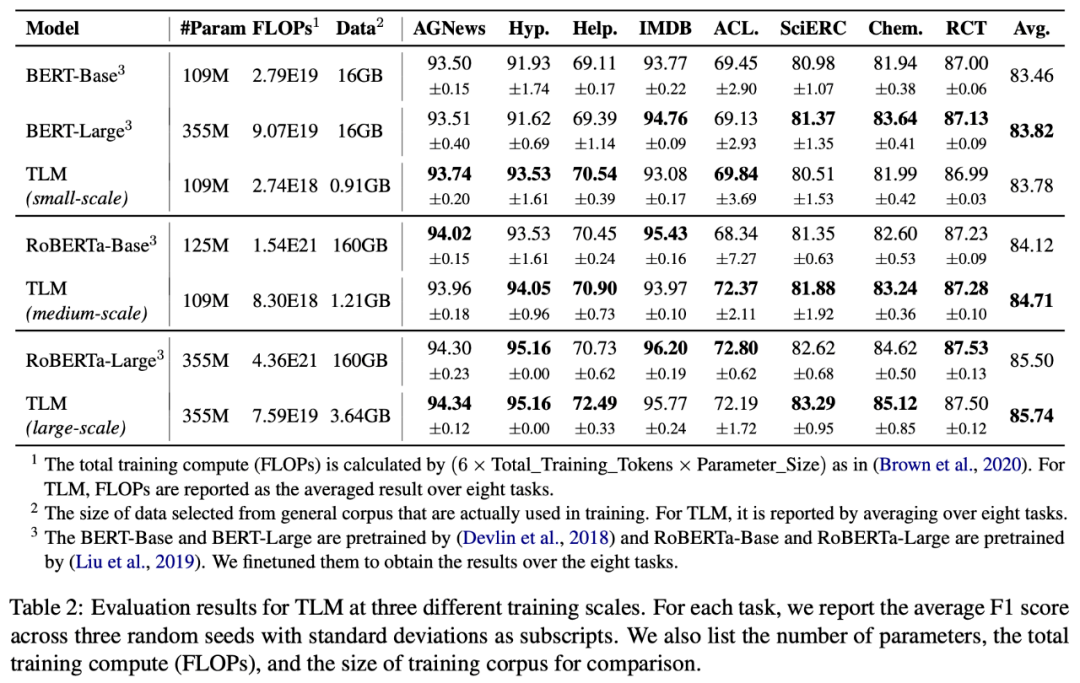

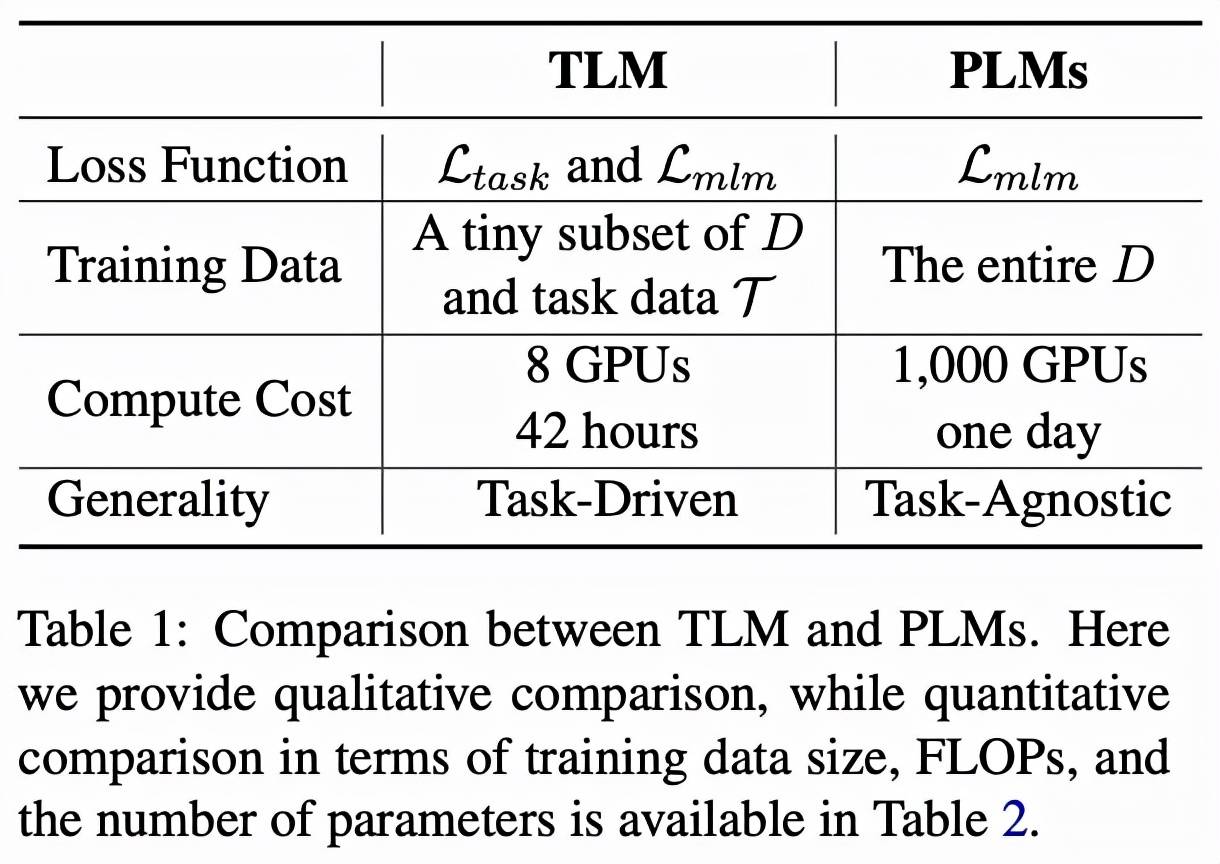

表格 1 直接对比了 TLM 和 PLM 。 整体来说 , PLM 以极高的成本学习尽可能多的任务无关的知识 , 而 TLM 以非常低的成本针对每个任务学习相关知识 。 对比 TLM 和 PLM 有如下几个方面特点 。

1.推动 NLP 研究公平化和民主化(Democratization)

【无需大规模预训练,清华提出高效NLP学习框架TLM】预训练本身严重依赖大量的计算资源 , 这一限制使得大多数 NLP 研究者专项对微调算法的研究 。 然而微调性能上限很大程度上受预训练模型性能的约束 。 而 TLM 使得大多数研究人员可以以较低的代价和较高的效率 , 基于最先进的解决方案对模型架构、损失函数、算法等方面进一步自由探索 。

2. 高效性(Efficiency)

TLM 在平均每个任务的 FLOPs 消耗方面显著优于 PLM 。 当我们有少数目标任务需要解决的时候(例如研究人员希望对少量几个数据集进行研究) , TLM 会是非常高效的;然而当需要一次性解决大量任务时(例如工业界构建一个 NLP 平台为多方提供相似的服务) , PLM 仍然具有优势 。

3. 灵活性(Flexibility)

TLM 是任务驱动的 , 所以可以给研究人员更大的自由度 , 从而自定义策略进行标记、序列长度、数据表示、超参数的调整等等 , 从而达到提高性能和效率的目的 。

4. 通用性(Generality)

PLM 学习与任务无关的一般性表示 , 可用于小样本和零样本学习 , 而 TLM 通过学习任务相关的表示一定程度牺牲通用型换取效率 。 从这个意义上 , TLM 需要在通用型方面进一步提升 。 此外也可以 PLM 和 TLM 结合从而在通用性和效率之间实现更好的权衡 。

深入观察 TLM:让更多参数为下游任务服务

文章图片

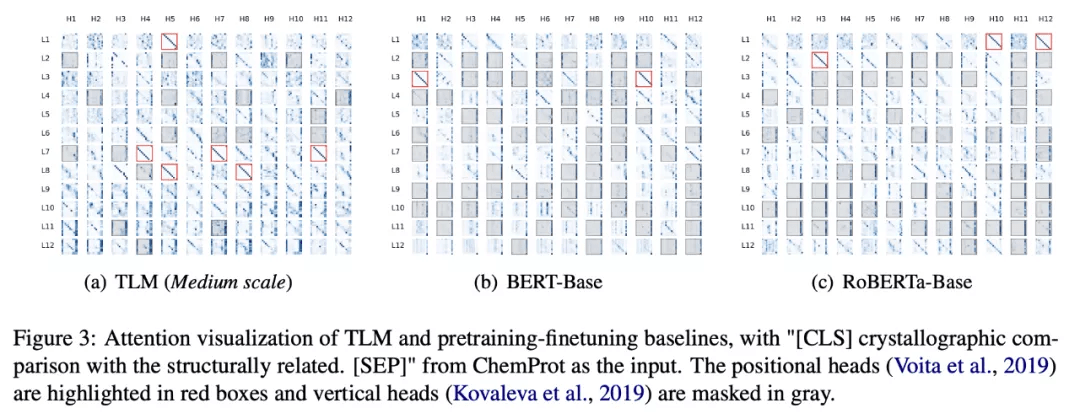

为了深入了解 TLM 的工作机制 , 研究人员对模型每个注意力头所输出的注意力分数进行了可视化 。 可以观察到 , TLM 的注意力模式中包含了更多的「对角线」模式(图 3 红框) , 也即大多 token 都将注意力分数集中赋予了其邻近 token , 这种模式已在前人的工作 [1] 中被证明对模型的最终预测有着重要贡献 。 而预训练模型(BERT, RoBERTa)中则包含了大量「垂直」模式的注意力头(图 3 灰色区域) , 也即大多 token 都将注意力分数集中赋予了 [CLS] , [SEP] 或者句号这种毫无语义或者句法信息的词汇上 。 这一现象表明 TLM 中参数利用率要显著高于预训练语言模型 , TLM 或许针对下游任务学习到了更加富有语义信息的表示 。

总结

TLM 的提出让 NLP 研究跳脱出预训练微调范式成为了可能 , 这使得 NLP 研究者们可以更为自由地探索新兴的模型结构与训练框架 , 而不拘泥于大规模预训练模型 。 在未来 , 更多有趣的研究可以在 TLM 的基础上展开 , 例如:如何经济地达到更大规模预训练模型的表现效果;如何提升 TLM 的通用性与可迁移性;可否利用 TLM 进行小样本或零样本学习等等 。

参考文献

[1] Elena Voita, David Talbot, Fedor Moiseev, Rico Sennrich, and Ivan Titov. 2019. Analyzing multi-head self-attention: Specialized heads do the heavy lifting, the rest can be pruned. In Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, pages 5797–5808, Florence, Italy. Association for Computational Linguistics.

[2] Stephen E. Robertson and Hugo Zaragoza. 2009. The probabilistic relevance framework: BM25 and beyond. Found. Trends Inf. Retr., 3(4):333–389.

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。