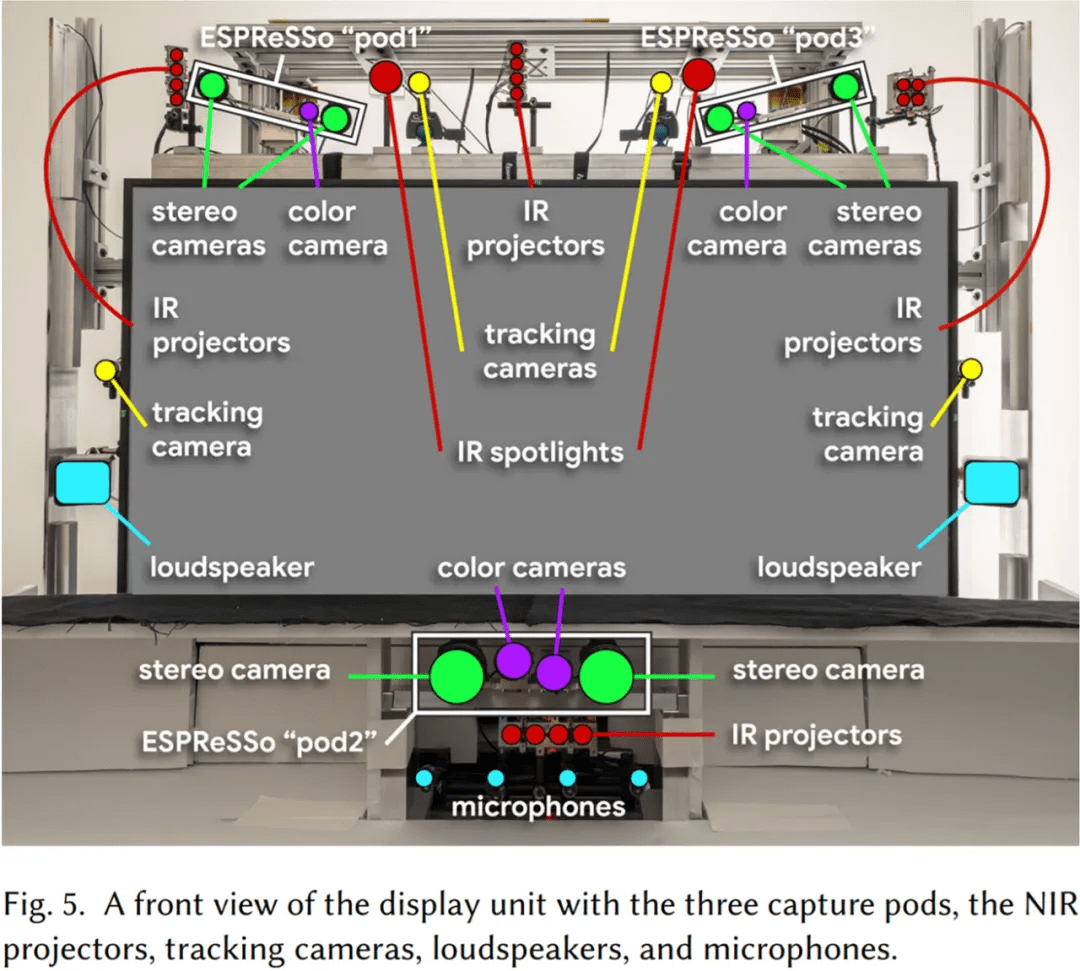

下图 5 展示了捕获和显示组件的排列 。

文章图片

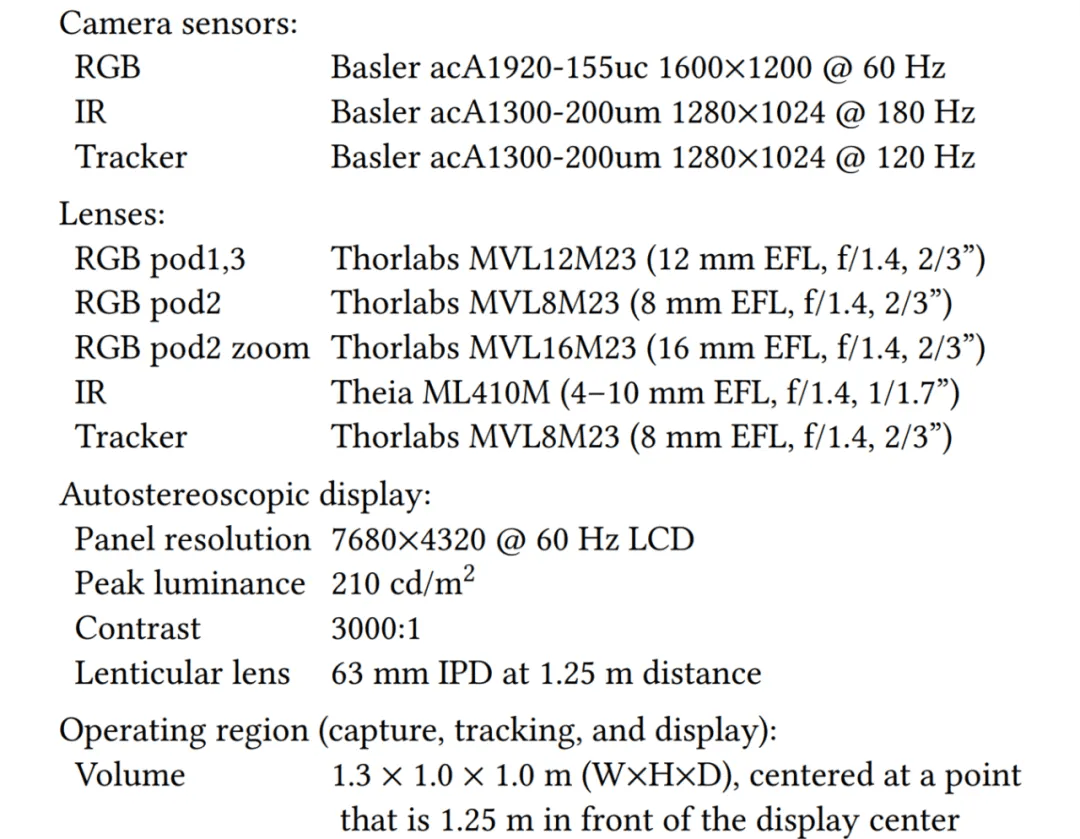

更详细的系统组件信息如下:

文章图片

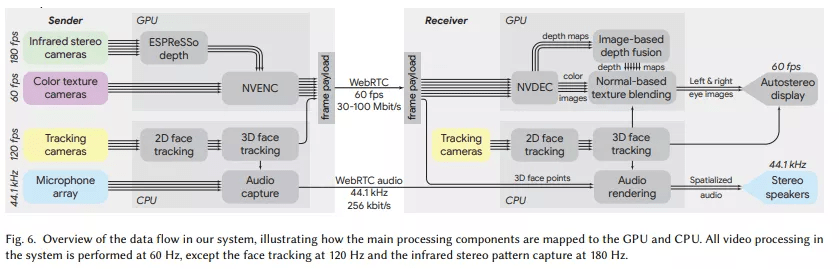

下图 6 为系统中的数据流 , 展示了 Starline 主要的处理组件如何映射到 GPU 和 CPU 。 系统中的所有视频处理都在 60 Hz 下进行 , 除了 120 Hz 的面部跟踪和 180 Hz 的红外立体模式捕获 。

【谷歌公开裸眼3D全息视频聊天技术:8k屏幕、4块GPU和一堆摄像头】

文章图片

照明

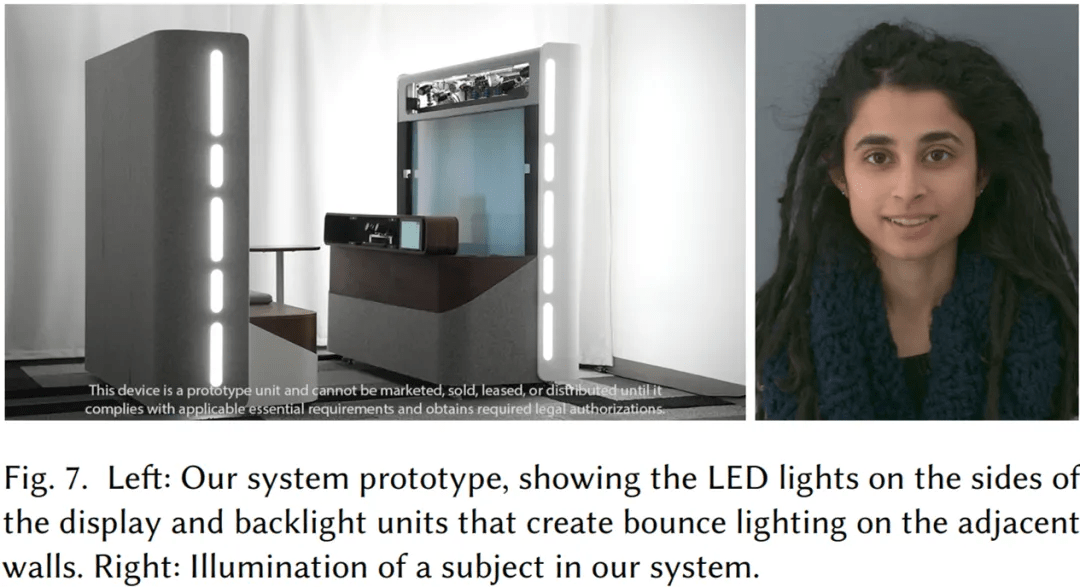

谷歌使用间接「反弹」(bounce)光源创造了一个柔和的照明环境 。 在显示和背光单元的侧面和背面 , 白色 LED 灯带照亮了周围的墙壁 , 产生舒适的漫射源 , 最大限度地减少锐利高光 。 与明亮的 LED 直接照明相比 , 这种散射的光对用户来说也更舒适 。

同时 , 光亮保持一定的不均匀分布也很重要 。 谷歌发现 , 完全均匀的入射光使人脸和其他 3D 形状看起来扁平且不真实 , 阻碍了系统中其他 3D 效果的发挥 。 摄影师尤其是电影摄影师将拍摄对象完全照亮和阴影两侧之间的对比度称为「照明比」 。 为了保持对象的立体感 , 谷歌在邻近墙壁的显示单元一侧使用更强的强度 , 产生大约 2:1 的照明比 。

展示效果如下图 7 所示:

文章图片

色彩校准

谷歌通过调整每个相机的增益、色彩校正 (3×3) 矩阵和 gamma 对系统的 RGB 相机进行色彩校准 , 以使标准色彩目标 [McCamy et al. 1976] 匹配 D65 光源下的参考色彩值 , 抵消了室内照明的影响 。 经过色彩校准的显示器在 D65 光源下拍摄的图像看起来像是在当地房间的照明条件(强度和色彩)下拍摄的 。 这种色彩校准方案可确保系统自动校正两个用户位置之间的细微照明差异 。

对象捕获

谷歌的目标是渲染每个用户的新图像 , 这是因为它们应该出现在其他用户的左眼和右眼 。 显然 , 如果可以将相机精确地放置在这些眼睛位置 , 那么捕捉就变得微不足道了 。

遗憾的是 , 这是不可行的 。 一方面 , 这些位置位于显示器的中心附近 , 因而会被遮挡;另一方面 , 用户将会在所有 3 个维度上自由运动 。 新兴的透视显示技术或许能够部分解决这个问题 , 但透明的自动立体显示器还不存在 , 并且无论如何都无法解决观看者的运动问题 。

因此 , 谷歌将捕获传感器放置在显示器的外围 。 由于显示器对着本地用户的角度很大 , 因此捕获视角与需要渲染的眼睛位置相距甚远 。 为了解决这种大视差 , 谷歌使用可见光和近红外(NIR)全局快门图像传感器的组合来重建用户的几何近似值 。

如上图 5 所示 , 传感器分布在三个捕获 pod 中 , 两个在显示器上方 , 一个位于其下方的中墙 。 上方的 pod 可以很好地观察手势以及头部和躯干的侧面 , 同时下方的 pod 又能很好地观察颈部、面部和下巴 。 pod 的体积足够大 , 宽 1.4 m、高 1.0 m 和深 0.9 m , 用于捕捉坐着自然谈话和打手势的用户的头部、躯干、手臂和手 。

3D 脸部追踪

谷歌采用了四个同步的 1280×1024 单色相机 , 它们以 120Hz 运行并配有过滤器来阻挡 NIR 光 。 对于每个捕获的图像 , 谷歌检测面部并定位 34 个面部标志 [FaceDetector 2019] 。 此外 , 他们还将眼睛、嘴巴和耳朵的 2D 位置确定为邻近标志的加权组合 。 为了让四个追踪相机中至少有两个找出这些对象 , 谷歌使用三角测距法(triangulation)来获取它们的 3D 位置 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。