视频压缩以及传输

来自 RGBD 捕获 pod 的四种颜色和三种深度流在 GPU 上进行压缩 , 并使用 WebRTC 与追踪的 3D 面部点一起传输 。

通过使用视频压缩技术 , 该研究能够利用现代 GPU 中高度优化的视频编码器和解码器 。 具体来说 , 他们使用四个 NVIDIA GPU 的 NVENC/NVDEC 单元 。 这样一来会有足够的吞吐量处理四种颜色和三种深度流在全分辨率和 60Hz 的帧率 。 颜色和深度流都使用带有 YUV420 chroma 子采样的 H.265 编解码器进行编码 。 颜色流每通道使用 8 位 ,深度流每通道使用 10 位 , 深度数据存储在 Y 亮度(luminance)通道中 , 而 UV chroma 通道设置为 512(灰色) 。 该研究通过省略双向编码 (B) 帧来减少编码和解码延迟 。

渲染

在接收客户端上解压好 3 个深度图和 4 个彩色图像后 , 该研究从本地用户的眼睛位置渲染虚拟远程用户左右透视图 。 它由三个步骤组成:

对于每个 4 色相机 , 通过为每条射线找到与输入深度图融合的表面的第一个交点 , 使用光线投射计算阴影图;

对于 2 用户视图 (左和眼) 中的每一个 , 使用相同的光线投射算法计算输出深度图;

对于每个输出深度映射点(output depth map point) , 计算由第 1 步得出的阴影映射图加权颜色混合 。

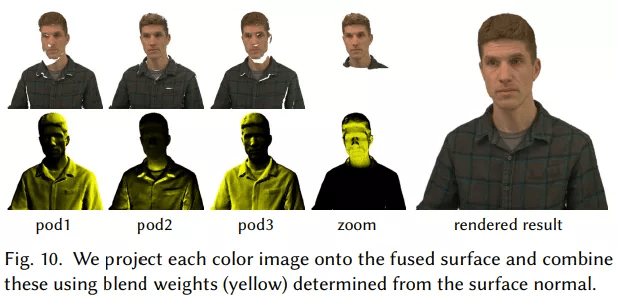

对于左视图和右视图 , 该研究通过将彩色图像投射到融合几何体上来获得每个像素的颜色(图 10):

文章图片

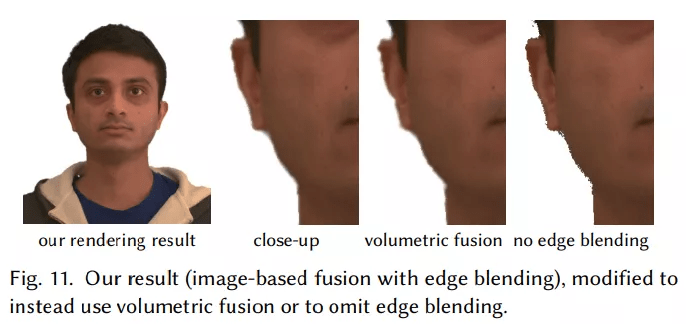

图 11 显示了没有边缘融合的不规则像素化轮廓 。 该图还显示 , 基于图像的融合提供了比轮廓附近体积融合(volumetric fusion)更完整的重建:

文章图片

声音传输

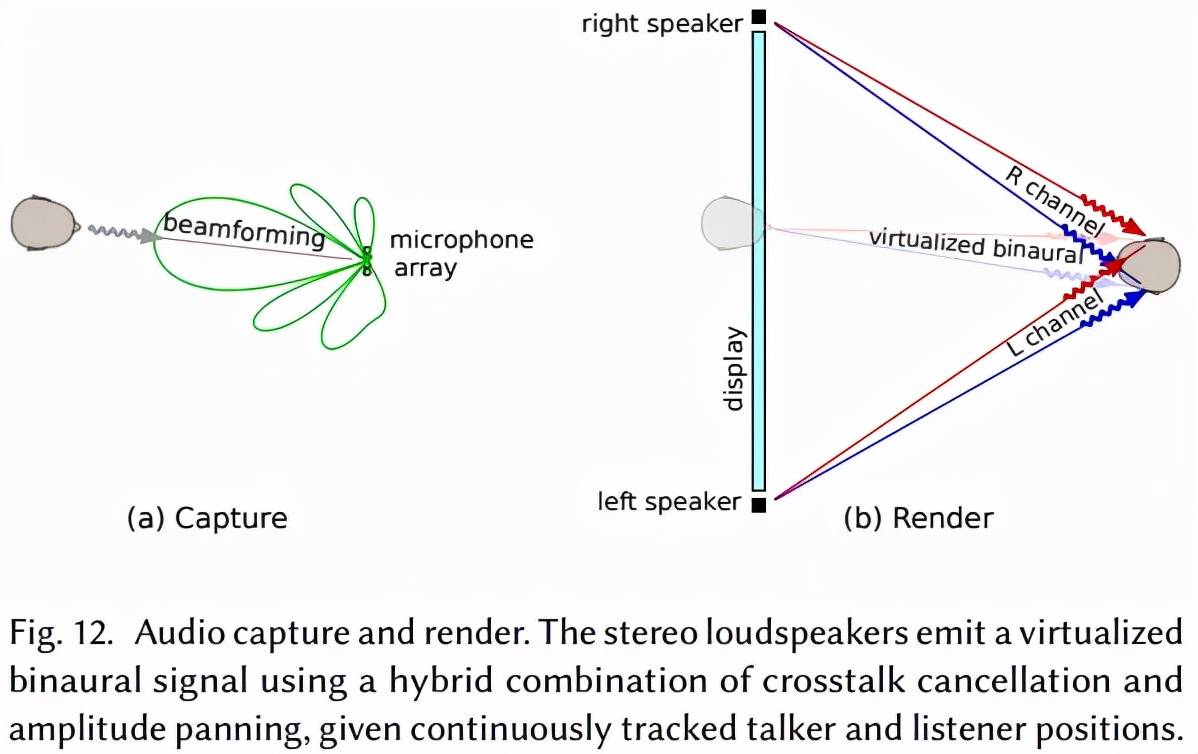

该研究使用的音频传输技术是将一系列先进技术进行组合:talker-tracked 波束成形、混响消减、WebRTC 传输、talker/listener-tracked 虚拟音频合成、双耳串扰消除分频组合以及振幅平移 。 与传统的视频会议系统相比 , 对谈话者和倾听者精确的追踪是共享空间达到真实性的关键因素(图 12) 。 据了解 , 这是首次在视频会议中无需耳机、头部追踪的音频技术 。

文章图片

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。