文章图片

文章图片

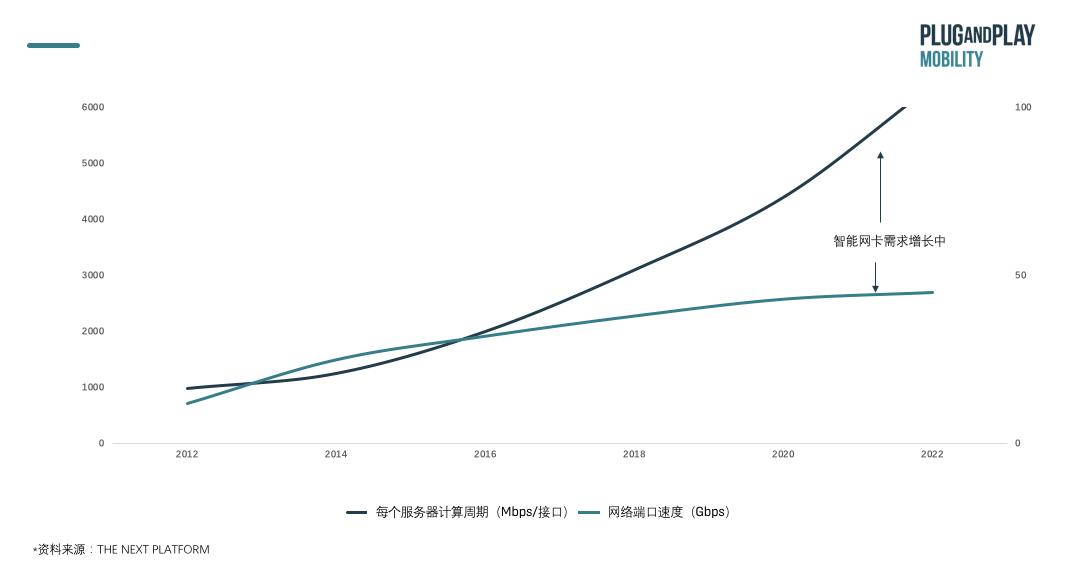

01核心观点 随着数据处理量需求的高速发展 , 对数据运行算力和网络端口速度的要求与日俱增 , 同时面临数据高速涌入时和对应处理单元匹配失衡的情况 , 通过设置专用DPU进在网络端口处对数据完成预处理

- 有利于释放算力和存储空间 , 增加计算安全性 , 降低计算成本 ,

- 同时为整体计算应用相关行业的未来发展奠定基础 。

- 近期在于确认技术路径的选择和分析落地案例的场景 ,

- 长远来看在于找到核心推广至全体计算行业应用的方法 。

- 玩家类型众多 ,

- 且入局时间接近 ,

- 处于激烈竞争状态 ,

- 技术路径各异:包括FPGA、ARM和自研异构多种架构 , 目前还没有确认的最优解决方案及芯片厂商应用落地案例 。

在这个阶段 , 计算成本和能力一直处于平稳状态 , 但随着数据量的增大 , 网络和存储负载一直在增加 。 网络性能和计算性能的差距一直在扩大 , 早在2018 年超过 70%的以太网端口的出货速度就约为10G/秒 。 如果一直提升算力 , 但是通信基础设施跟不上 , 整体系统性能还是受限 , 难以发挥出真正的潜能 。

文章图片

为了弥补此需求缺口 , DPU应运而生 , 专门用于处理数据 。

DPU , Data Processing Unit , 数据处理单元 , 是一种片上系统 , 结合了以下三个关键要素:

- 行业标准的高性能软件可编程多核CPU , 通常基于广泛使用的Arm架构 , 并与其他SOC组件紧密耦合 。

- 高性能的网络接口 , 能够以网络速度解析 , 处理和有效地将数据传输到GPU和CPU 。

- 灵活的可编程加速引擎 , 旨在减轻网络任务负担并优化AI和机器学习 , 安全性 , 电信和存储等的应用程序性能 。

文章图片

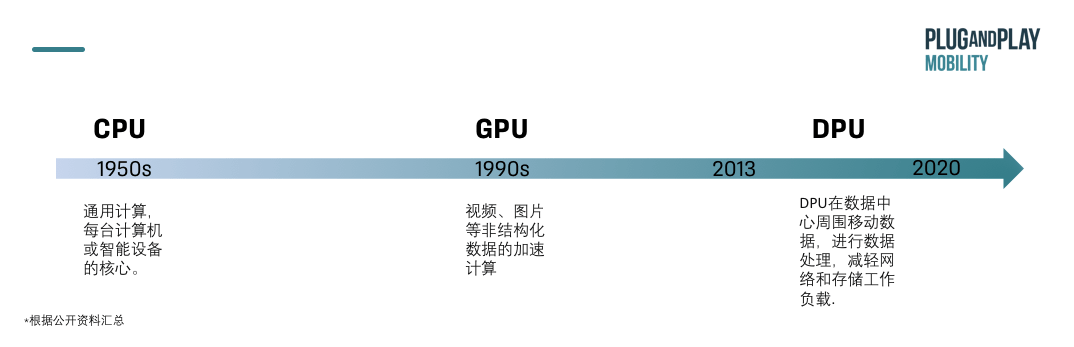

DPU专门用于数据处理 , 拥有高性能的网络接口 , 用于弥补CPU和GPU的不足 。

与专门用于通用计算的CPU和适合视频、图片等非结构化数据的加速计算不同的GPU相比 , DPU出现年代较晚 , 近两年才开始兴起 , 主要用于在数据中心周围移动数据 , 进行数据处理 , 减轻网络和存储工作负载 , 补足CPU和GPU的算力 。

CPU 内核是为通用应用程序处理而设计的 , 随着网络速度的提高(现在每条链路的速度高达 200gb / s ) ,CPU 花费了太多宝贵的内核来分类、跟踪和控制网络流量 。

通过DPU的方式就可以解决网络传输中的瓶颈问题或丢包问题 。 典型通信延时可以从30-40微秒降低到3-4秒 , 性能提升10倍以上 。

03 DPU的三大主要功能:保证安全性、释放CPU算力和释放服务器容量 保证安全性:DPU 作为一个智能网卡, 是网络流量的入口 , 也是阻止攻击和加密传输最直接的地方 。 它通过与主 CPU 分开运行来提供安全隔离 , 如果主 CPU 受损 ,DPU 仍然可以检测或阻止恶意活动 。 DPU 可以在不立即涉及 CPU 的情况下检测或阻止攻击 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。