机器之心报道

编辑:陈萍、小舟

搞不起大模型 , 试一下超高性能的纯 MLP 架构?去年来自谷歌大脑的研究团队在网络架构设计方面挖出新坑 , 提出 MLP-Mixer, 这是一个纯 MLP 构建的视觉架构 。 该架构无需卷积、注意力机制 , 仅需 MLP , 在 ImageNet 数据集上就实现了媲美 CNN 和 ViT 的性能表现 。

之后清华大学等机构的研究者先后将纯 MLP 用于构建视觉架构和新的注意力机制 , 这些研究将 CV 的研究重心重新指向 MLP 。

众多研究者纷纷感叹:CV 领域网络架构的演变从 MLP 到 CNN 到 Transformer 再回到 MLP , 真简直是一场 AI 领域的「文艺复兴」 。

时隔不到一年 , 来自 IBM Research 的研究团队近日又提出了 pNLP-Mixer , 将 MLP-Mixer 应用于自然语言处理(NLP)任务 。

文章图片

论文地址:https://arxiv.org/pdf/2202.04350.pdf

大型预训练语言模型极大地改变了 NLP 的格局 , 如今它们成为处理各种 NLP 任务的首选框架 。 但是 , 由于内存占用和推理成本 , 在生产环境中使用这些模型(无论是在云环境还是在边缘环境)仍然是一个挑战 。

研究者开始提出可替代方案 , 他们最近对高效 NLP 的研究表明 , 小型权重高效(weight-efficient)模型可以以很低的成本达到具有竞争力的性能 。 IBM Research 提出的 pNLP-Mixer , 是一种可用于 NLP 任务的基于投影(projection)的 MLP-Mixer 模型 , 它通过一个全新的投影层(projection layer)实现了高权重效率 。

该研究在两个多语言语义分析数据集 MTOP 和 multiATIS 上对模型进行了评估 。 结果表明 , 在 MTOP 数据集上 , pNLP-Mixer 达到了与 mBERT 媲美的性能 , 而后者有 38 倍多的参数 , 此外 , pNLP-Mixer 还优于小模型 pQRNN , 而后者参数是前者的 3 倍 。 在长序列分类任务中 , pNLP-Mixer 在没有进行预训练的情况下比 RoBERTa 表现更好 , 后者的参数是 pNLP-Mixer 的 100 倍 。

pNLP-Mixer 架构

作为一种从头开始设计的高效架构 , pNLP-Mixer 适用于两种边缘情况 , 即内存和延迟受限 , 并作为 NLP pipeline 的主干网络而存在 。

文章图片

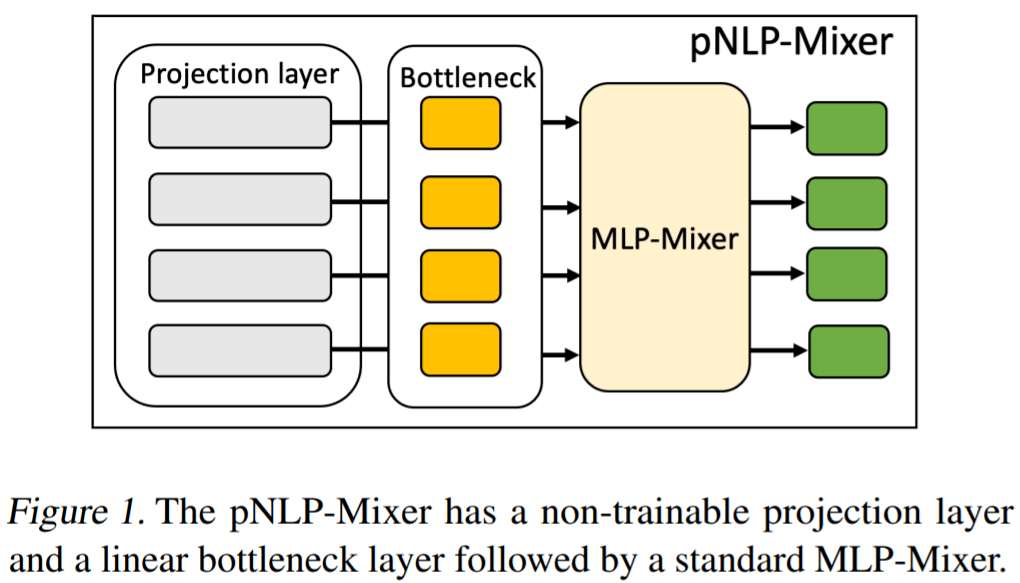

图 1 描述了 pNLP-Mixer 模型的架构 , 是基于投影的模型 , 不像基于 transformer 的模型那样可以存储大型嵌入表 。 pNLP-Mixer 使用投影层 , 该投影层使用不可训练的哈希函数从单个 token 中捕获词法知识 。 这个投影层可以被看作是从输入文本中生成表征的特征提取器 。 一旦输入特征被计算出来 , 它们就会被送入一个称为瓶颈层(bottleneck layer)的可训练线性层 。 其中瓶颈层的输出是标准 MLP- mixer 架构(Tolstikhin et al., 2021)的一系列 MLP 块的输入 。

使用全 MLP 架构进行语言处理具有一些优点 。 与基于注意力的模型相比 , MLP-Mixer 可以捕获长距离依赖关系 , 而不会在序列长度上引入二次成本 。 此外 , 仅使用 MLP , 模型不仅实现起来简单 , 而且在从手机到服务器级推理加速器的各种设备中都具有开箱即用的硬件加速功能 。

这项研究表明 , 在 NLP 任务中 , 像 MLP-Mixer 这样的简单模型可以作为基于 transformer 模型的有效替代方案 , 即使在不使用大型嵌入表的环境中也是如此 。 这其中的关键是模型提供了高质量的输入特征 。

投影层

投影层是基于局部敏感哈希(LSH) , 从文本中创建表征 。 虽然这一概念在其他现有的投影中是常见的(例如 pQRNN (Kaliamoorthi et al., 2021)) , 但该研究提出的投影方法却是全新的 。 MinHash 因计算简单被用作哈希函数 , 并依靠子词 tokenization 来确定哈希输入 。 子词 tokenization 通常在 transformer 模型中使用 , 它确保了任何字符串都可以被表征为子词单元的组合 , 即不存在词表外的词 。 在该研究的语境中 , 使用子词 tokenizer 有两个主要优点:

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。