而连接的权值可能迅速变化,从某种意义上说,网络具有了「自我参照」效应(认知心理学概念,指记忆材料与自我联系时记忆效果优于其它编码条件),这是由于理论上它可以学着运行任意可计算的权值变化算法或学习算法(作用于该网络的所有权值) 。这催生了 1990 年代和 2000 年代的许多后续工作 。

文章插图

不使用「老师」监督信号的深度强化学习(RL)也可以从快速权值中受益(即使系统的动力不可微) 。2005 年,我之前的博士后 Faustino Gomez [FAST5](现为 NNAISENSE 的 CEO)也说明了这一点,而那时人们负担得起的电脑的运行速度相较于 1990 年代已经提升了 1000 倍 。

此外,据我所知,我们同年在深度强化学习领域所做的相关工作(但是没有使用快速权值)是第一份在标题中包含了「Learn deep」词组的机器学习论文 [DL6](2005 年,不久之后许多人开始讨论「深度学习」) 。

文章插图

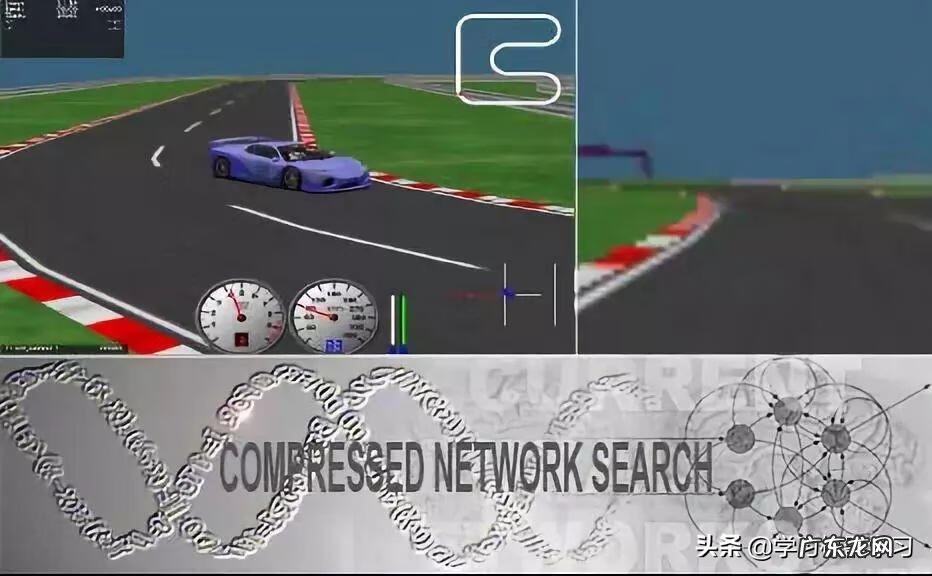

在过去的几十年中,我们发表了大量其它的方法来学习如何通过非常紧凑的代码,快速生成大型神经网络的大量的权值,例如:[KO0][KO1][KO2][CO1][CO2][CO3] 。在此,我们利用了「成功的大型神经网络的柯尔莫哥洛夫复杂性或算法的信息量实际上可能非常小」这一规律 。

值得一提的是,在 2013 年 7 月,「压缩网络搜索」(Compressed Network Search)[CO2] 成为了第一个在没有任何无监督预训练(与第一章不同)的情况下,使用强化学习技术成功地直接根据高维感知数据(视频)学会控制策略的深度学习模型 。不久之后,DeepMind 也开发出了一个用于高维感知输入的深度强化学习模型 [DM1][DM2] 。

现在,最著名的基于快速权值的端到端可微神经网络 [FAST0] 实际上是我们 2000 年提出的 vanilla LSTM 网络 [LSTM2](详见第 4 章),它的遗忘门可以学着控制内部 LSTM 神经元的自循环连接的快速权值 。今天,所有主要的 IT 公司都大量使用 vanilla LSTM[DL4] 。同样,这个模型的起源可以追溯到 1991 年(详见第 4 章和第 8 章) 。

9. 通过神经网络学习顺序注意力机制(1990)

文章插图

与传统的神经网络不同,人类使用连续的目光移动和选择性注意力来检测和识别模式 。这可能比传统 FNN 高度并行的方法有效得多 。这正是我们在 30 年前(1990 年及之前)提出顺序注意力学习神经网络的原因 [ATT0][ATT1] 。不久之后,我还明确地提出了在 RNN 中对「内部注意力关注点」的学习 [FAST2](详见第 8 章) 。

因此,当时我们已经提出了现在非常常用的两种类型的神经顺序注意力机制:

(1)(在潜在空间中)通过神经网络中的乘法单元实现的端到端可微的「软」注意力 [FAST2];

(2)(在观测空间中)实现的强化学习(RL)环境中的「硬」注意力机制 [ATT0][ATT1] 。

这催生了许多后续的工作 。今天,许多人都在使用带有顺序注意力学习机制的神经网络 。

我为 CMSS 1990 所写的综述论文 [ATT2] 在它的第 5 章中总结了我们早期关于注意力机制的工作 。据我所知,这是首次实现结合了 glimpse 注意力机制(使用注意力组件,即固定控制器同时训练识别和预测组件)的神经系统 。20 年后,我这篇 1990 年的论文的审稿人(Hinton)在一篇他以第二作者身份发表的相关论文中写道 [ATT3]:「据我们所知,这是首次使用一个注意力组件(固定控制器)实现结合了 glimpse 来同时训练识别组件...的系统」 。(相关内容请参阅第 10 章)

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。