文章图片

长城WEY 2021

- 技术路径:摄像头视觉识别

- 干预手段:能够根据驾驶员进入车舱时做出的不同表情进行视觉识别 , 并播放相应情绪场景的歌曲或提示 。

- 座舱搭载了第三代高通SA8155芯片 , 与车内虚拟助理、VIMS面部识别等功能进行联动

- 同时 , OMS系统会针对后排乘客采用B柱上的毫米波雷达对生命体征进行检测 。 (图片来源:长安官网)

文章图片

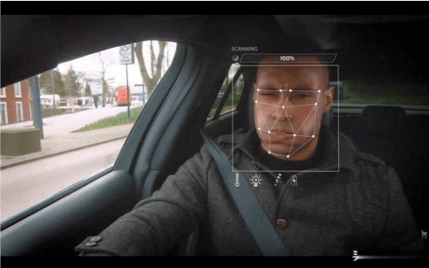

哈弗 2021

- 技术路径:面部表情识别

- 干预手段:环境变化

- 主动情绪识别系统会通过驾驶侧A柱上的摄像头来识别驾驶员的面部表情 , 从而判断驾驶员的情绪 , 比如高兴、生气、惊讶 , 并且还会有不同的语句反馈和干预方式

- 摄像头也有人脸识别+声纹ID解锁的功能 , 为不同家庭人员驾驶提供个性化设置

- 技术路径:行车数据联动处理

- 干预手段:语音提醒 , 环境变化

- 系统可以在车辆的行驶过程中做出主动判断 , 主动询问是否关窗 , 开空调 , 开音乐 , 或者开启座椅加热等 。

- 比如 , 系统会根据平常你开车时间的大数据计算 , 发现你今天晚回家了 , 然后特别为你推送加班关怀提醒 。

- 在车辆行驶过程中 , 能够判断当前的车速 , 如果速度大于80km/h ,PM2.5浓度数值大于115则会触发语音助手提醒功能 , 询问驾驶员是否需要关窗 。 如果你驾驶时突然走神或者分心 , 车速大于15公里/小时 , 而方向盘转角小于20° , 且未开启转向灯的情况下 , 分心监测功能就会激活 , 然后进行语音提醒 。 (图片来源:哈弗官网)

文章图片

/ / 车内应用目前存在的痛点与解决方案

技术痛点: 无法精准识别情绪强度

- 现在进行的情感识别工作多集中在简单的情感分类 , 对于情绪强弱程度方面 , 目前并没有太多的研究者去探究 。 而即使在情绪分类上 , 结果的准确度也因取决于人为的判断而受到质疑 。

- 深度学习(CNN/3DCNN)具有提取鲁棒性特征的潜力 。 利用海量数据学习到的特征比人工构造的特征更能反映数据的内在本质 , 能在一定程度上克服特征冗余问题 , 从而极大提高情绪识别效果 。

- 目前情绪识别研究大多是从数字信号分析的角度出发 , 探究情绪与信号特征的关系 。 但是本身训练模型的数据集如DEAP 数据集、MAHNOB-HCI 数据集、eNTERFACE’05数据集等采用的主体诱导式研究方法对数据产生了很大的局限性 , 非常可能和真实场景的情绪情景相差甚远 。

- 使用VR进行沉浸式情绪诱发

- 车企更倾向于无接触的感知方法 , 在自然状态下收集用户数据 , 达到无感交互的效果 , 如摄像头、红外摄像头、微型传感器、远程rPPG等

- 由于行车过程中存在各种环境不稳定因素 , 如车身剧烈晃动、快速变化的阳光、不同乘车人体态区别等

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。