文章图片

图片来自 ResNeXt 论文 , https://arxiv.org/abs/1611.05431

第二个优点是模型会更高效 , 即模型参数会随过滤器分组数的增大而减少 。 在之前的例子中 , 完整的标准 2D 卷积有 h x w x Din x Dout 个参数 。 具有 2 个过滤器分组的分组卷积有 (h x w x Din/2 x Dout/2) x 2 个参数 。 参数数量减少了一半 。

第三个优点有些让人惊讶 。 分组卷积也许能提供比标准完整 2D 卷积更好的模型 。 另一篇出色的博客已经解释了这一点:https://blog.yani.io/filter-group-tutorial 。 这里简要总结一下 。

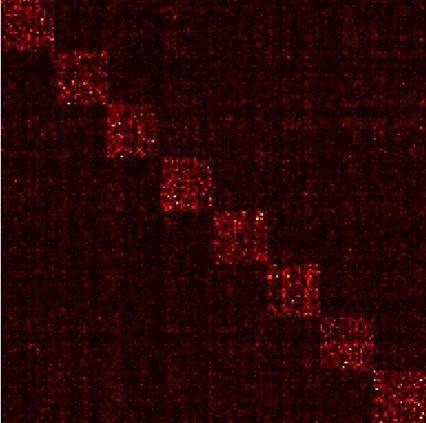

原因和稀疏过滤器的关系有关 。 下图是相邻层过滤器的相关性 。 其中的关系是稀疏的 。

文章图片

在 CIFAR10 上训练的一个 Network-in-Network 模型中相邻层的过滤器的相关性矩阵 。 高度相关的过滤器对更明亮 , 而相关性更低的过滤器则更暗 。 图片来自:https://blog.yani.io/filter-group-tutorial

分组矩阵的相关性映射图又如何?

文章图片

在 CIFAR10 上训练的一个 Network-in-Network 模型中相邻层的过滤器的相关性 , 动图分别展示了有 1、2、4、8、16 个过滤器分组的情况 。 图片来自 https://blog.yani.io/filter-group-tutorial

上图是当用 1、2、4、8、16 个过滤器分组训练模型时 , 相邻层的过滤器之间的相关性 。 那篇文章提出了一个推理:「过滤器分组的效果是在通道维度上学习块对角结构的稀疏性……在网络中 , 具有高相关性的过滤器是使用过滤器分组以一种更为结构化的方式学习到 。 从效果上看 , 不必学习的过滤器关系就不再参数化 。 这样显著地减少网络中的参数数量能使其不容易过拟合 , 因此 , 一种类似正则化的效果让优化器可以学习得到更准确更高效的深度网络 。 」

文章图片

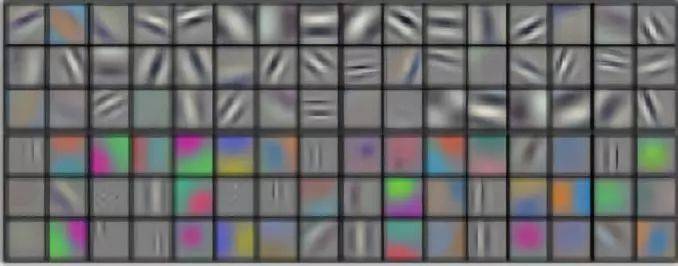

AlexNet conv1 过滤器分解:正如作者指出的那样 , 过滤器分组似乎会将学习到的过滤器结构性地组织成两个不同的分组 。 本图来自 AlexNet 论文 。

此外 , 每个过滤器分组都会学习数据的一个独特表征 。 正如 AlexNet 的作者指出的那样 , 过滤器分组似乎会将学习到的过滤器结构性地组织成两个不同的分组——黑白过滤器和彩色过滤器 。

你认为深度学习领域的卷积还有那些值得注意的地方?

原文链接:https://towardsdatascience.com/a-comprehensive-introduction-to-different-types-of-convolutions-in-deep-learning-669281e58215

—版权声明—

来源:机器之心 , 编辑:nhyilin

仅用于学术分享 , 版权属于原作者 。

若有侵权 , 请联系微信号:Eternalhui或nhyilin删除或修改!

【一文读懂深度学习中的各种卷积】—THE END—

? 平凡而又神奇的贝叶斯方法

? 怎样用数学找到一颗丢失的氢弹?

? 【物理方程】物理学中最难的方程之一 , 你知道多少?

? 为什么一定要拼尽全力考上985、211大学?

? 怎样判断漂亮女孩是不是单身的?

? 投资数学天才西蒙斯:尽你所能和最优秀的人合作

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。