文章图片

, 研究者有

文章图片

。

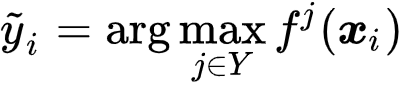

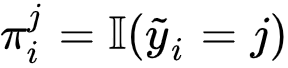

M-Step 。 在这一步 , 研究者假设后验类概率已知 , 并最大化似然 。 下述定理表明 , 最小化对比损失能够也最大化似然的一个下界 ,

文章图片

文章图片

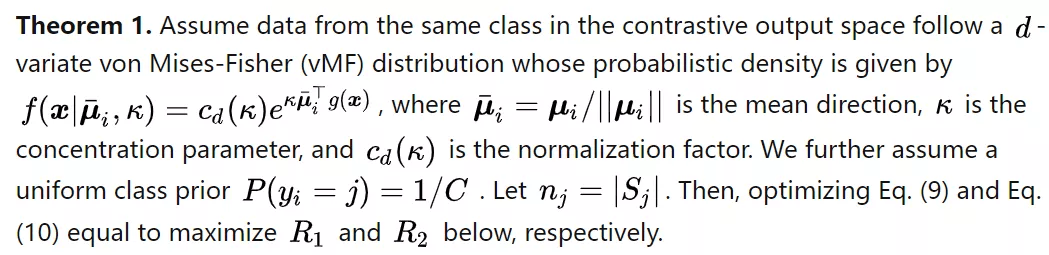

证明见原文 。 当

文章图片

接近 1 时 , 下界较紧 , 这意味着超球面的类内集中度很高 。

直观地说 , 当假设空间足够丰富时 , 研究者有可能在欧几里得空间中得到较低的类内协方差 , 从而导致均值向量

文章图片

的范数很大 。

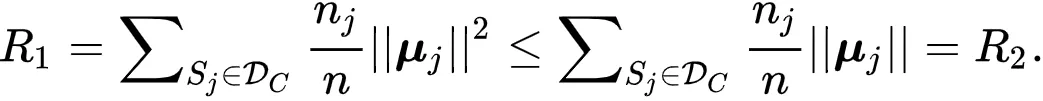

然后 , 超球面中的归一化 embedding 在也具有较强的类内集中度 , 因为大的

文章图片

也会导致大的 K 值 [7] 。 根据实验结果中的可视化结果 , 研究者发现 PiCO 确实能够学习紧凑的簇 。 因此 , 研究者认为最小化对比损失也能够最大化似然 。

结论

在本文中 , 研究者提出了一种新颖的偏标签学习框架 PiCO 。 其关键思想是通过使用对比学习的 embdding 原型从候选集合中识别真实标签 。 全面的实验结果表明 PiCO 达到了 SOTA 的结果 , 并在部分情况下达到了接近完全监督的效果 。 理论分析表明 , PiCO 可以被解释为一种 EM 算法 。 研究者希望研究者的工作能够引起社区的更多关注 , 以更广泛地使用对比学习技术进行偏标签学习 。

实验室简介

欢迎大家加入研究者赵俊博老师所在的浙江大学数据智能实验室和带领的M3 Group(与宝马那辆跑车没啥关系)!!实验室在计算机学院院长陈刚老师带领下 , 曾获 VLDB 2014/2019 best paper , 近年来在 VLDB、ICLR、ICML、ACL、KDD、WWW 等顶级会议和期刊上成果颇丰 , 多次获得国家级、省级奖项 。 赵俊博老师是浙江大学百人计划研究员、博士生导师 , 师承 Yann LeCun , Google 引用 1w+ , 知乎万粉小 V , AI 赛道连续创业者 。

赵俊博主页:http://jakezhao.net/

参考

1. 实际上 , PLL 有更直接的别名:Ambiguous Label Learning(模糊 / 歧义标签学习) , 或 Superset Label Learning(超集标签学习) 。 本文遵循最常用的名称 , 称作偏标签学习 。

2. Tongzhou Wang and Phillip Isola. Understanding contrastive representation learning through alignment and uniformity on the hypersphere. In ICML, volume 119 of Proceedings of Machine Learning Research, pp. 9929–9939. PMLR, 2020.

3. Prannay Khosla, Piotr Teterwak, Chen Wang, Aaron Sarna, Yonglong Tian, Phillip Isola, Aaron Maschinot, Ce Liu, and Dilip Krishnan. Supervised contrastive learning. In NeurIPS, 2020.

4. Kaiming He, Haoqi Fan, Yuxin Wu, Saining Xie, and Ross B. Girshick. Momentum contrast for unsupervised visual representation learning. In CVPR, pp. 9726–9735. IEEE, 2020.

5. Jiaqi Lv, Miao Xu, Lei Feng, Gang Niu, Xin Geng, and Masashi Sugiyama. Progressive identification of true labels for partial-label learning. In ICML, volume 119 of Proceedings of Machine Learning Research, pp. 6500–6510. PMLR, 2020.

6. Lei Feng, Jiaqi Lv, Bo Han, Miao Xu, Gang Niu, Xin Geng, Bo An, and Masashi Sugiyama. Provably consistent partial-label learning. In NeurIPS, 2020b.

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。