机器之心专栏

复旦大学数据智能与社会计算实验室

复旦大学数据智能与社会计算实验室(Fudan DISC)推出大规模跨视觉语言模态预训练模型:MVPTR 。本文介绍了 Fudan DISC 实验室提出的一种基于多层次语义对齐的多阶段视觉 - 语言预训练模型 MVPTR , MVPTR 是一个多阶段的视觉 - 语言表征模型和预训练方法 , 通过显式地学习表示不同层级的 , 来自图片和文本信息的语义 , 并且在不同的阶段对齐不同层次的语义 , 在大规模图片 - 文本对语料库上预训练的 MVPTR 模型在下游视觉 - 语言任务上取得了明显的进展 , 包括图片 - 文本检索、视觉语言问答、视觉推断、短语指代表示 。

文章图片

- 论文链接:https://arxiv.org/abs/2201.12596;

- 代码链接:https://github.com/Junction4Nako/mvp_pytorch.

视觉和语言是人类智能的两大重要体现 , 为了能协同处理来自视觉和文本的信息 , 近年来关于视觉 - 语言的多模态研究专注于从不同的任务出发去对齐视觉和语言的语义学习 , 比如图片文本检索、视觉语言问答(VQA)、短语表示指代等等 。 为了能打破任务间的壁垒 , 学习到泛化的多模态表示 , 研究者尝试去构建了视觉 - 语言的预训练模型(如 VL-BERT、UNITER、OSCAR 等) , 它们在大规模的图片 - 文本对上进行自监督的预训练后能在下游任务上通过微调取得不错的性能 。

目前的视觉语言预训练模型大多沿袭了 BERT 中的序列建模方法 , 从图片中通过物体检测器 / CNN / 视觉 Transformer 抽取物体级别 / grid 级别 / patch 级别的特征拼接为视觉序列 , 将其与分词后的文本序列拼接成一个序列 , 通过多层 Transformer 学习模态内和跨模态的交互 , 这样的方式比较直接 , 但研究者认为其背后却少了对于跨模态信息间多层语义粒度对齐的探索 。

文章图片

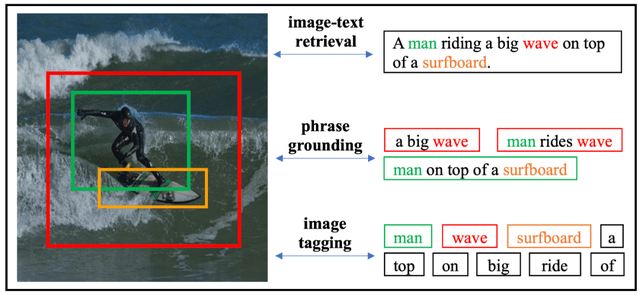

该研究在这里给出了一个图片 - 文本对的例子来说明图片 - 文本间的语义匹配情况 。 首先模态内的语义存在着层次嵌套结构 , 整个图片可以由很多的子图组成 , 每个子图里可能有多个物体存在;对于一个句子 , 可以被分词成很多的 token , 多个 token 可以组成短语 。 同时各个层次间的语义对齐是互相帮助的 , image tagging 将 token 对应到图片及图片中的物体 , 可以进一步帮助包含这个词的短语匹配到图片中的区域 , 完成 phrase grounding 的任务 。 基于物体和 token 的匹配、短语和图片区域的匹配信息 , 可以进一步推断出图片 - 句子间的相似度 , 完成 image-text retrieval 的任务 。

所以为了能协同利用起多个层次的语义对齐 , 来自 Fudan DISC 实验室的研究者提出了 MVPTR:a Multi-stage Vision-language Pre-training framework 。 MVPTR 首先从文本和图片中分别构建了两个层次的语义:对于图片 , 该研究使用物体检测器抽取区域的特征 , 并且用预测出的物体类别作为物体级别的语义概念;对于文本 , 除了分词后的 token , 该研究使用文本场景图解析器从中提取出场景图的结构化元组 , 作为短语级的语义概念 。 同时 MVPTR 的模型分成了两个阶段:单模态学习和跨模态学习阶段 。 在单模态阶段 , 模型学习模态内的交互 , 得到各个模态的多层语义的表示;在跨模态阶段 , 模型学习模态间的交互 , 并进行细粒度的推理 。 对于 MVPTR 的预训练 , 该研究设计在不同阶段设计了不同的自监督任务 , 来进行多层次的语义对齐 。 在单模态的视觉端 , 研究者引入了 MCR(masked concept recovering)来对齐区域特征和物体级别的概念;在跨模态阶段 , 首先通过 VSC(visual-semantic constrastive)来粗粒度地对齐全局的图片、文本单模态表征 , 然后使用 WPG(weakly-supervised phrase grouding)对齐短语级概念和区域特征 , 最后使用 ITM(image-text matching)和 MLM(masked language modeling)作为高层次的语义推断任务 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。