【小语种难度排名 语种识别】

文章插图

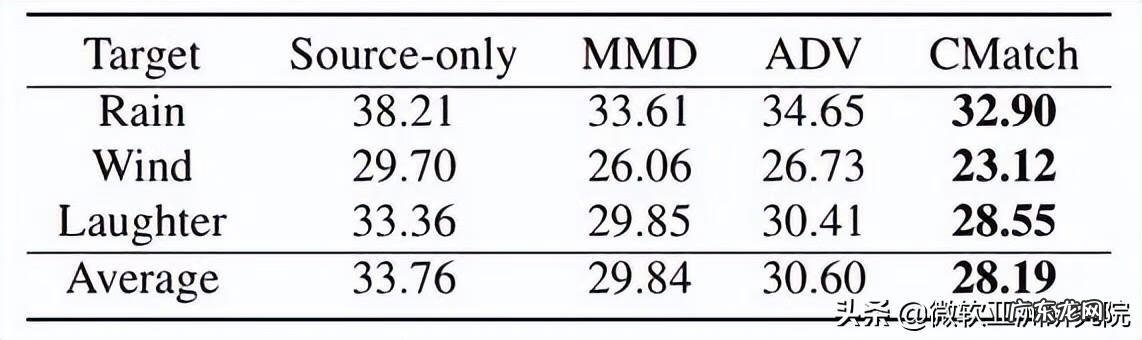

表3:跨环境(抗噪声)语音识别结果

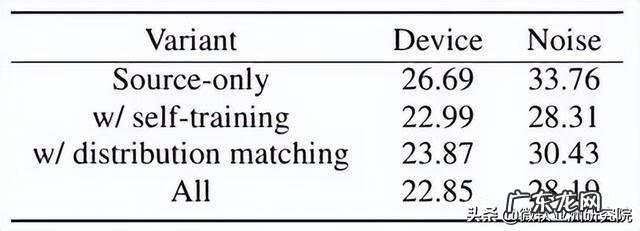

表4为消融实验,可以看到结合了自训练和细粒度的分布匹配能够使 CMatch 达到最好的效果 。

文章插图

表4:CMatch 消融实验结果

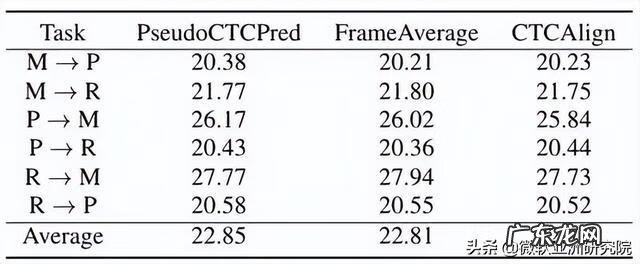

此外,研究员们还分析比较了三种字符分配方法 。在表5中可以看出 CTC 强制对齐取得了最好的效果,但是其计算开销也最大;而 FrameAverage 也取得了较好的效果,但它的假设前提是领域和目标域具有均匀的说话速度;而使用 CTC 伪标签的方法取得了与 CTC 强制对齐相近的结果,同时计算起来也更加高效 。

文章插图

表5:三种字符分配方法的实验结果

最后,对于是否需要在解码器端使用 CMatch Loss,实验结果如表6 。由于解码器在实验中本来就没有功能上的差别,目标文本都是标准的英文,因此减小其分布的差异并没有什么效果,甚至会损害性能 。

文章插图

表6:解码器端使用 CMatch Loss 的测试结果

在一代代科学家和工程师的努力下,语音识别系统在各种主流语言上都已经达到了非常好的效果,比如英语、中文、法语、俄语、西班牙语等……让人们在日常生活中就能享受其带来的便利 。然而,世界上有大约7,000种语言,其中绝大部分语言的使用者并不多,而且不同人的方言、口音、说话方式也有所不同,这就使得这些语言的语音数据十分稀缺,即低资源(low-resource)语言 。标注数据的稀缺导致近年来端到端语音识别的诸多成果迟迟不能应用到这些语言上 。

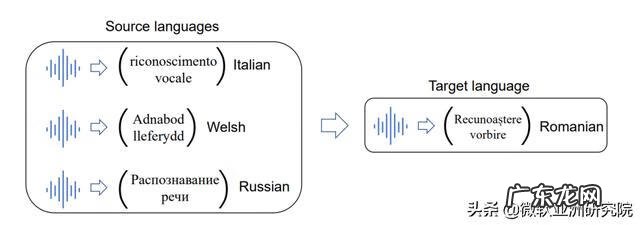

为此,微软亚洲研究院的研究员们开始思考如何利用迁移学习,将主流语言(如英语、中文等)的知识用于帮助低资源语言的学习,在多种语言之间共享,起到“四两拨千斤”的效果,从而提升小语种语音识别的表现 。如图3所示,给定罗马尼亚语作为目标语言,如何利用数据相对丰富的意大利语、威尔士语和俄语来训练出更好的罗马尼亚语语音识别模型?

文章插图

图3:给定若干源语言,如何将知识迁移到目标语言上?

幸运的是,近年来,如 wav2vec2.0 [2] 等预训练模型都已经推出了多语言版本,微软亚洲研究院之前的研究也证明了仅需要简单的微调,一个大规模的多语言模型就能被适配到一个低资源语言上,并能显著改善识别性能 。

但与此同时,研究员们也发现了两个新问题:

- 大规模的多语言模型往往含有大量的参数,导致在一些数据量非常少的情况下,模型极易过拟合 。

- 如果对于世界上的每一个小语种都维护一个微调后的大模型,成本将会十分巨大 。

不过,之前 Houlsby 等人发现[3],对于一个预训练好的 BERT,只需要在 Transformer 的每一层插入一个如图4所示的 Adapter,就能在不改变模型主干参数的情况下将模型适配到各种下游任务,甚至能够取得接近整个模型微调的表现 。Adapter 主要包含一个 LayerNorm 层,用于重新调节原始特征的尺度,接着分别是一个降采样层和一个升采样层对特征进行压缩和还原,最后由一个残差连接保证原始特征依然能通过,从而提升 Adapter 训练时的稳定性 。

- 若不差钱,建议给家里添置这5件小家电,提升生活幸福感!

- 考贵大的mba难度大吗 MBA考试难么

- 南海观世音菩萨在小说中出场的情节有哪些-观音的言行,对唐僧师徒西天取经有哪几方面的影响-请结合相关?

- 小学生清明节手抄报大全?

- 小朋友偏食怎么办?

- 小时候夏夜仰望星空满天都是星星,现在怎么都看不到那种景象了?

- 夜晚很无聊怎么办?

- 如何做好一名优秀的小班幼儿教师研修成果论文?

- 血小板低怎么调理 血小板低是怎么回事

- 今年高考数学那么难,区分度会好吗?

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。