生成模型的输出也在大幅提高 。 在过去几年里取得了显著的进步 , 尤其在图像的生成模型中最为明显 。 例如 , 最近的模型已经证明了仅给定一个类别(如“irish setter”或“steetcar”)便可以创建逼真的图像 , 可以“填充”一个低分辨率的图像 , 以创建一个看起来十分自然的高分辨率匹配图像 , 甚至可以构建任意长度的自然场景 。 另一个例子是 , 可以将图像转换成一系列离散 tokens , 然后使用自回归生成模型以高保真度进行合成 。

文章图片

图3/25

图丨级联扩散模型(cascade diffusion models)的例子 , 从一个给定的类别生成新的图像 , 然后使用这些图像作为种子来创建高分辨率的示例:第一个模型生成低分辨率图像 , 其余的执行向上采样(upsampling)到最终的高分辨率图像 。

文章图片

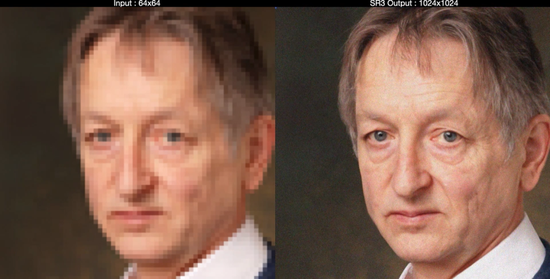

图4/25

图丨SR3 超分辨率扩散模型是以低分辨率图像作为输入 , 并从纯噪声中构建相应的高分辨率图像 。

鉴于这些强大的功能背后 , 潜藏着的是巨大的责任 , 所以我们不得不仔细审查 , 这类模型的潜在应用是否违背我们的人工智能原则 。

除了先进的单模态模型(single-modality models)外 , 大规模的多模态模型(multimodal models)也在陆续进入人们的视野 。 这些模型是迄今为止最前沿的模型 , 因为它们可以接受多种不同的输入模式(例如 , 语言、图像、语音、视频) , 而且在某些情况下 , 还可以产生不同的输出模式 , 例如 , 从描述性的句子或段落生成图像 , 或用人类语言简要描述图像的视觉内容 。 这是一个令人惊喜的研究方向 , 因为类似于现实世界 , 在多模态数据中更容易学习(例如 , 阅读一些文章并看时辅以演示比仅仅阅读有用得多) 。 因此 , 将图像和文本配对可以帮助完成多种语言的检索任务 , 并且更好地理解如何对文本和图像输入进行配对 , 可以对图像字幕任务(image captioning tasks)带来更好的改进效果 。 同样 , 在视觉和文本数据上的联合训练 , 也有助于提高视觉分类任务的准确性和鲁棒性 , 而在图像、视频和音频任务上的联合训练则可以提高所有模式的泛化性能 。 还有一些诱人的迹象表明 , 自然语言可以作为图像处理的输入 , 告诉机器人如何与这个世界互动 , 以及控制其他软件系统 , 这预示着用户界面的开发方式可能会发生变化 。 这些模型处理的模式将包括语音、声音、图像、视频和语言 , 甚至可能扩展到结构化数据、知识图和时间序列数据等等 。

文章图片

图5/25

图丨基于视觉的机器人操作系统的例子 , 能够泛化到新的任务 。 左图:机器人正在执行一项用自然语言描述为“将葡萄放入陶瓷碗中”的任务 , 而不需要对模型进行特定的训练 。 右图:和左图一样 , 但是有“把瓶子放在托盘里”的新的任务描述 。

这些模型通常使用自监督学习(Self-supervised learning)的训练 , 在这种方法中 , 模型从观察到的“原始”数据中学习 , 而这些数据没有被整理或标注 。 例如 , GPT-3 和 GLaM 使用的语言模型 , 自监督的语音模型 BigSSL , 视觉对比学习模型 SimCLR , 以及多模态对比模型 VATT 。 自监督学习允许大型语音识别模型匹配之前的语音搜索中的自动语音识别技术(Automatic Speech Recognition)的基准精度 , 同时仅使用 3% 的标注训练数据 。 这些趋势是令人兴奋的 , 因为它们可以大大减少为特定任务启用 ML 所需的努力 。 而且 , 它们使得在更有代表性的数据上训练模型变得更容易 , 这些数据可以更好地反映不同的亚种群、地区、语言或其他重要的表示维度 。

特别声明:本站内容均来自网友提供或互联网,仅供参考,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。